Редактируем Robots.txt в WordPress с помощью плагина All in One SEO

Файл robots.txt — это мощный инструмент SEO, поскольку он работает как руководство по веб-сайту для роботов, выполняющих сканирование страниц сайтов. Указание ботам не сканировать ненужные страницы может увеличить скорость загрузки вашего сайта и улучшить рейтинг в поисковых системах.

Несмотря на то, что однажды я уже создавал пост про этот важный файл для оптимизации работы сайтов, в этом мануале я более подробно расскажу, что такое файл robots.txt и почему он важен. А так же шаг за шагом покажу, как редактировать и как редактировать его в WordPress.

Содержание

- 1 Что такое файл Robots.txt?

- 2 Файл Robots.txt по умолчанию в WordPress

- 3 Почему важен файл Robots.txt?

- 4 Когда использовать мета-тег Noindex вместо robots.txt

- 5 Как редактировать файл Robots.txt в WordPress с помощью AIOSEO

- 6 Включаем пользовательский файл Robots.txt

- 7 Добавление правил с помощью создателя правил

- 7.

1 Пожертвуйте на развитие блога, пожалуйста.

1 Пожертвуйте на развитие блога, пожалуйста. - 7.2 Related Posts

- 7.

Что такое файл Robots.txt?

Файл robots.txt сообщает поисковым системам, как сканировать ваш сайт — где им можно это делать, а где нельзя.

Поисковые системы, такие как Google, используют этих поисковых роботов, иногда называемых веб-роботами, для архивирования и классификации веб-сайтов.

Большинство ботов настроены на поиск файла robots.txt на сервере до того, как он прочитает любой другой файл с вашего сайта. Это делается для того, чтобы увидеть, добавили ли вы особые инструкции по сканированию и индексированию вашего сайта.

Файл robots.txt обычно хранится в корневом каталоге, также известном как основная папка веб-сайта. URL-адрес может выглядеть так: https://www.example.com/robots.txt

Чтобы проверить файл robots.txt на своем веб-сайте, просто замените https://www.example.com/ на свой домен и добавьте robots.txt в конце.

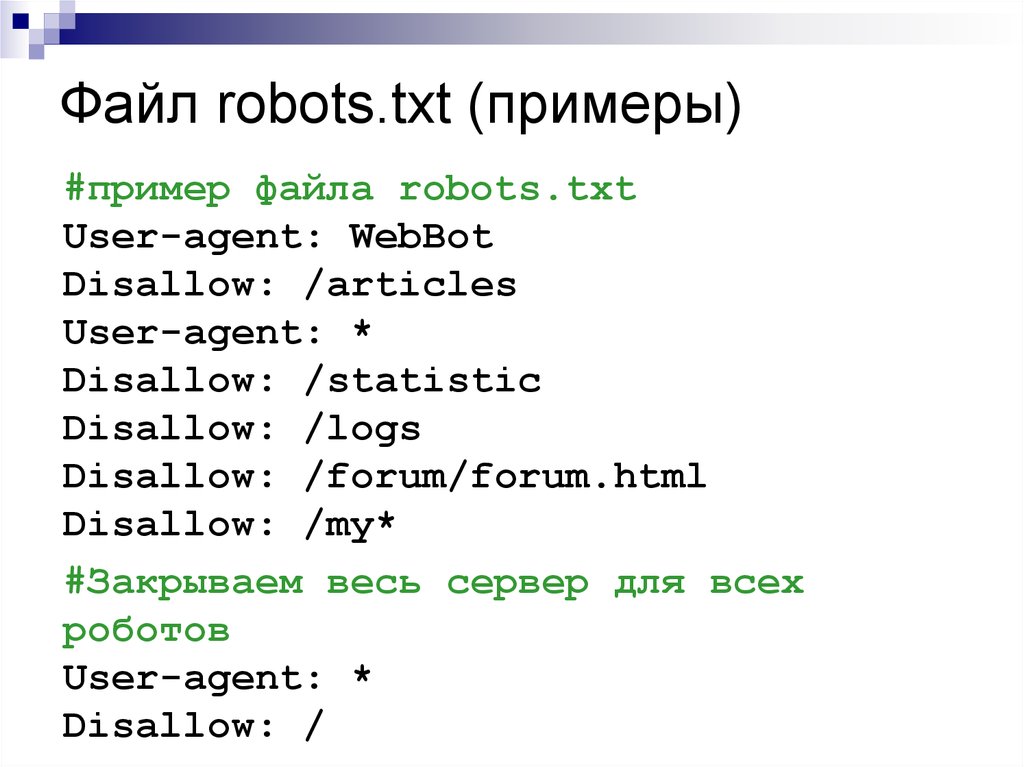

Сейчас же, давайте посмотрим, как выглядит основной формат файла robots.

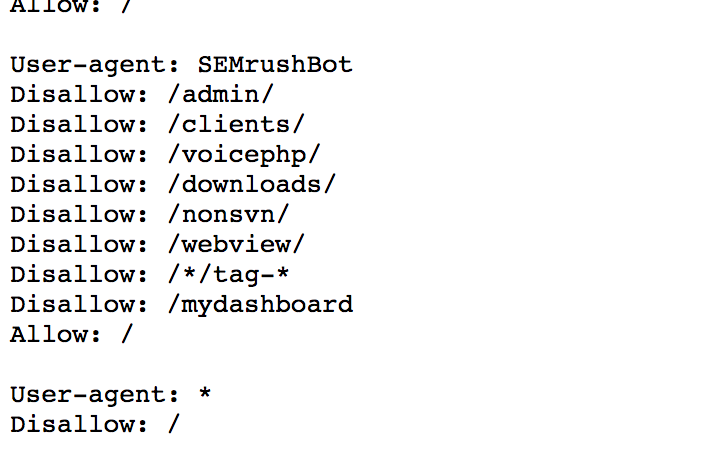

User-agent: [user-agent name] Disallow: [URL string not to be crawled] User-agent: [user-agent name] Allow: [URL string to be crawled] Sitemap: [URL of your XML Sitemap]

Чтобы это имело смысл, сначала нужно объяснить, что означает User-agent.

По сути, это имя бота или робота поисковой системы, которому вы хотите заблокировать или разрешить сканировать ваш сайт (например, робот Googlebot).

Во-вторых, вы можете включить несколько инструкций, чтобы разрешить или запретить определенные URL-адреса, а также добавить несколько карт сайта. Как вы, наверное, догадались, опция запрета указывает роботам поисковых систем не сканировать эти URL-адреса.

Файл Robots.txt по умолчанию в WordPress

Но когда вы позже настроите его своими собственными правилами, содержимое по умолчанию будет заменено.

Стандартные файлы robots.txt выглядит так:

User-agent: * Disallow: /wp-admin/ Allow: /wp-admin/admin-ajax.php

Звездочка после User-agent: * означает, что файл robots.txt предназначен для всех веб-роботов, посещающих ваш сайт. И, как уже упоминалось, Disallow: / wp-admin / указывает роботам не посещать вашу страницу wp-admin.

Вы можете протестировать свой файл robots.txt, добавив /robots.txt в конце своего доменного имени. Например, если вы введете в адресную строку браузера запись https://aioseo.com/robots.txt , то в нем отобразится файл robots.txt для сайта плагина AIOSEO, который его разработчики настроили вот так:

Теперь, когда вы знаете, что такое файл robots.txt и основы его работы, давайте посмотрим, почему файл robots.txt имеет значение в первую очередь.

Почему важен файл Robots.txt?

Файл robots.txt важен, потому, что с помощью него вы:

1. Оптимизируйте скорость загрузки вашего сайта — указав ботам не тратить время на страницы, которые вы не хотите, чтобы они сканировали и индексировали, вы можете освободить ресурсы и увеличить скорость загрузки вашего сайта.

2. Оптимизируете использования сервера — блокировка ботов, которые тратят ресурсы впустую, очистит ваш сервер и уменьшит количество ошибок 404.

Когда использовать мета-тег Noindex вместо robots.txt

Однако, если ваша основная цель — предотвратить включение определенных страниц в результаты поисковых систем, правильным подходом является использование метатега noindex.

Это связано с тем, что файл robots.txt напрямую не говорит поисковым системам не индексировать контент — он просто говорит им не сканировать его.

Другими словами, вы можете использовать файл robots.txt для добавления определенных правил взаимодействия поисковых систем и других ботов с вашим сайтом, но он не будет явно контролировать, индексируется ли ваш контент или нет.

С учетом сказанного, давайте покажем вам, как легко шаг за шагом редактировать файл robots.txt в WordPress с помощью сео-плагина для WordPress — All in One SEO (AIOSEO)

Как редактировать файл Robots.

txt в WordPress с помощью AIOSEO

txt в WordPress с помощью AIOSEOСамый простой способ отредактировать файл robots.txt — использовать лучший плагин WordPress SEO All in One SEO (AIOSEO). Если вы его установили, то это позволит вам контролировать свой веб-сайт и настраивать файл robots.txt, который заменяет файл WordPress по умолчанию.

Если вы этого еще не знали, AIOSEO — это полноценный плагин WordPress для SEO,

который позволяет вам оптимизировать контент для поисковых систем и повысить рейтинг всего за несколько кликов. Ознакомьтесь с его мощными инструментами и функциями SEO здесь.

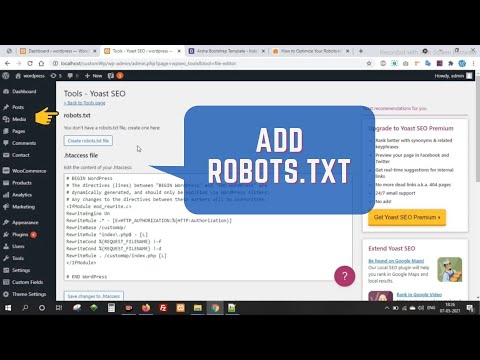

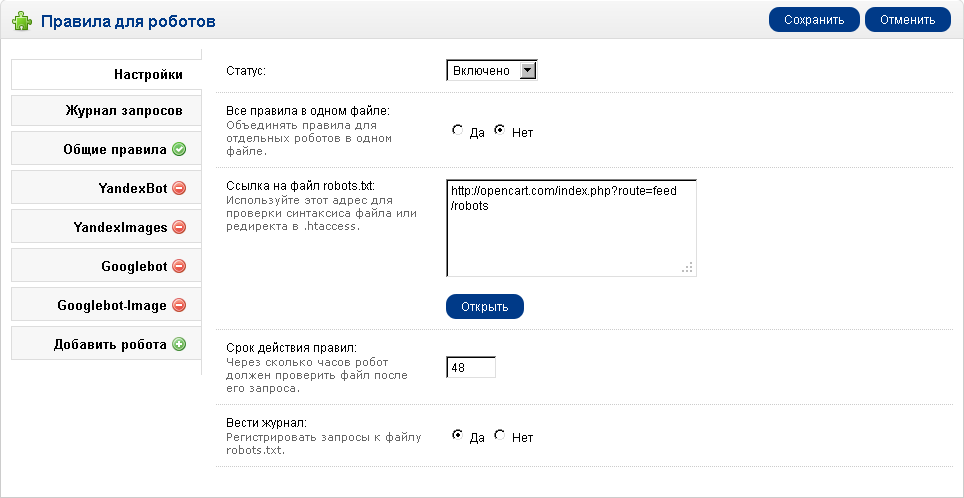

Включаем пользовательский файл Robots.txt

Чтобы приступить к редактированию файла robots.txt, с помощью уже установленного плагина AIOSEO, выберите в меню плагина строку «Инструменты». Таким образом вы откроете вкладку «Редактор Robots.txt». Далее приступаем к настройкам плагина.

Примечание* Если у вас уже был настроен файл и он вас вполне устраивает, вы можете просто импортировать его в AIOSEO.

Перевод страницы предупреждения и рекомендаций, если у вас уже был установлен файл: «AIOSEO обнаружила физический файл robots. txt в корневой папке вашей установки WordPress. Мы рекомендуем удалить этот файл, так как он может вызвать конфликт с динамически созданным файлом WordPress. AIOSEO может импортировать этот файл и удалить его, или вы можете просто удалить его».

txt в корневой папке вашей установки WordPress. Мы рекомендуем удалить этот файл, так как он может вызвать конфликт с динамически созданным файлом WordPress. AIOSEO может импортировать этот файл и удалить его, или вы можете просто удалить его».Теперь на странице редактирования можно легко добавлять или удалять необходимые правила. Если вы пожелаете удалить ранее созданный файл-роботс — просто импортируйте и удалите его и пользуйтесь настройками по умолчанию. Но действовать нужно с осторожностью и не спешить удалять старый, несмотря на предупреждения плагина, а лучше используйте редактор.

AIOSEO сгенерирует динамический файл robots.txt. Его содержимое хранится в вашей базе данных WordPress и может быть просмотрено в вашем веб-браузере.

После того, как вы вошли в редактор Robots.txt, вам необходимо включить Custom Robots.txt.

Кнопка включения окна редактирования файла robots.txtЗатем вы увидите раздел предварительного просмотра файла Robots.txt в нижней части экрана, в котором показаны правила WordPress по умолчанию, которые вы можете заменить своими собственными.

Правила по умолчанию предписывают роботам не сканировать ваши основные файлы WordPress (страницы администратора). Также не рекомендуется сканировать плагины и темы. Они не содержат релевантного содержания и не нужны поисковым системам для сканирования.

Теперь давайте перейдем к тому, как вы можете добавить (или редактировать уже созданные) свои собственные правила с помощью создателя правил.

Добавление правил с помощью создателя правил

Конструктор правил используется для добавления ваших собственных правил для того, какие страницы роботы должны сканировать или нет.

Например, если вы хотите добавить правило, которое блокирует всех роботов из временного каталога (имеется в виду временная папка, например, на жестком диске), вы можете использовать для этого создатель правил.

Чтобы добавить собственное правило, просто введите User Agent (например, поисковый робот Googlebot) в поле User Agent. Или вы можете использовать символ *, чтобы ваше правило применялось ко всем пользовательским агентам (роботам).

Затем выберите «Разрешить» или «Запретить», или удалить (справа в таблице значок корзины), чтобы разрешить или заблокировать User Agent.

Или добавить новое правило:

По окончании редактирования и внесения изменений, вернитесь на верх страницы и осуществите просмотр файла в адресной строке браузера «Open Robots.txt»:

Что бы операция установки редактирования файла robots.txt была завершена, не забудьте сохранить изменения, кликнув на соответствующую кнопку в самом верху или внизу страницы редактирования.

Надеюсь, что это руководство показало вам, как легко редактировать файл robots.txt в WordPress. Теперь продолжайте и добавляйте свои собственные правила, и вы в кратчайшие сроки убедитесь, что ваш веб-сайт оптимизирован для достижения оптимальной производительности.

Пожертвуйте на развитие блога, пожалуйста.

(Visited 1 times, 1 visits today)

Virtual Robots.txt — Плагин для WordPress

- Детали

- Отзывы

- Установка

- Разработка

Поддержка

Virtual Robots.

By default, the Virtual Robots.txt plugin allows access to the parts of WordPress that good bots like Google need to access. Other parts are blocked.

If the plugin detects an existing XML sitemap file, a reference to it will be automatically added to your robots.txt file.

- Upload pc-robotstxt folder to the

/wp-content/plugins/directory - Активируйте плагин используя меню ‘Плагины’ в WordPress.

- Once you have the plugin installed and activated, you’ll see a new Robots.txt menu link under the Settings menu. Click that menu link to see the plugin settings page. From there you can edit the contents of your robots.txt file.

Will it conflict with an existing robots.txt file?

If a physical robots.

txt file exists on your site, WordPress won’t process any request for one, so there will be no conflict.

txt file exists on your site, WordPress won’t process any request for one, so there will be no conflict.Will this work for sub-folder installations of WordPress?

Out of the box, no. Because WordPress is in a sub-folder, it won’t «know» when someone is requesting the robots.txt file which must be at the root of the site.

Does this plugin modify individual posts, pages, or categories?

No it doesn’t.

Why does the default plugin block certain files and folders?

By default, the virtual robots.txt is set to block WordPress files and folders that don’t need to be accessed by search engines. Of course, if you disagree with the defaults, you can easily change them.

Simple and easy. Works perfectly.

Works great and easy to use and customise. It already set by default the directories that need to be left out of Search Engines scanning/indexing. ..

Very happy with it!

..

Very happy with it!

What I saw wasn’t what I got. The XML sitemap wasn’t included in the robots.txt file, even thought this was described as a feature that should work out of the box. In addition to that, upon installing this plugin, it blocked certain directories without asking. Lastly, it inserts a line at the top of the file, promoting the plugin. That should be an optional feature that users are empowered to turn off. All in all, it offers the functionality, but falls short and disappoints in other areas.

It was good

I thought this would be simple. Sure sounds simple.

But after I saved your suggested text to my brand new «virtual robots.txt», I clicked the link where it says «You can preview your robots.txt file here (opens a new window). If your robots.txt file doesn’t match what is shown below, you may have a physical file that is being displayed instead.»

That new window shows text that is indeed different from the plugin’s.

I like the fact that it’s so clean.

Посмотреть все 9 отзывов

«Virtual Robots.txt» — проект с открытым исходным кодом. В развитие плагина внесли свой вклад следующие участники:

Участники

- Marios Alexandrou

«Virtual Robots.txt» переведён на 1 язык. Благодарим переводчиков за их работу.

Перевести «Virtual Robots.txt» на ваш язык.

Заинтересованы в разработке?

Посмотрите код, проверьте SVN репозиторий, или подпишитесь на журнал разработки по RSS.

1.10

- Fix to prevent the saving of HTML tags within the robots.txt form field. Thanks to TrustWave for identifying this issue.

1.9

1.8

- Undoing last fixes as they had unintended side-effects.

1.7

- Further fixes to issue with newlines being removed. Thanks to FAMC for reporting and for providing the code fix.

- After upgrading, visit and re-save your settings and confirm they look correct.

1.6

- Fixed bug where newlines were being removed. Thanks to FAMC for reporting.

1.5

- Fixed bug where plugin assumed robots.txt would be at http when it may reside at https. Thanks to jeffmcneill for reporting.

1.4

- Fixed bug for link to robots.txt that didn’t adjust for sub-folder installations of WordPress.

- Updated default robots.txt directives to match latest practices for WordPress.

- Plugin development and support transferred to Marios Alexandrou.

1.3

- Now uses do_robots hook and checks for is_robots() in plugin action.

1.2

- Added support for existing sitemap.xml.gz file.

1.1

- Added link to settings page, option to delete settings.

1.0

- Первая версия.

Мета

- Версия: 1.

- Обновление: 3 месяца назад

- Активных установок: 40 000+

- Версия WordPress: 5.0 или выше

- Совместим вплоть до: 6.1.1

- Языки:

English (US) и Swedish.

Перевести на ваш язык

- Метки:

crawlerrobotrobotsrobots.txt

- Дополнительно

Оценки

Посмотреть все

- 5 звёзд 6

- 4 звезды 0

- 3 звезды 0

- 2 звезды 1

- 1 звезда 1

Войдите, чтобы оставить отзыв.

Участники

- Marios Alexandrou

Поддержка

Решено проблем за последние 2 месяца:

0 из 1

Перейти в форум поддержки

Пожертвование

Would you like to support the advancement of this plugin?

Пожертвовать на развитие плагина

WP Robots Txt — плагин WordPress

- Детали

- отзывов

- Установка

- Развитие

Опора

WordPress по умолчанию включает простой файл robots.txt, который динамически генерируется в приложении WP. Отлично! но, возможно, вы хотите изменить содержание.

Войдите в WP Robots Txt, плагин, который добавляет дополнительное поле на страницу администратора «Чтение», где вы можете сделать именно это.

Просто посетите https://your-site.com/wp-admin/options-reading.php, и вы сможете управлять содержимым своего https://your-site.com/robots.txt

Журнал изменений

WP Robots Txt изначально был разработан chrisguitarguy. Плагин был принят и обновлен Джорджем Паттихисом, который продолжит разработку.

Плагин был принят и обновлен Джорджем Паттихисом, который продолжит разработку.

- Просмотр опции администратора

- Скачать плагин

- Разархивировать

- Загрузить разархивированную папку на

wp-content/pluginsкаталог - Активируйте и наслаждайтесь!

Или вы можете просто установить его через установщик плагинов в админке.

Я полностью испортил свой файл robots.txt. Как я могу восстановить версию по умолчанию?

Удалите все содержимое из поля Robots.txt Content и сохраните параметры конфиденциальности.

Могу ли я этим случайно заблокировать всех поисковых ботов?

Да. Будь осторожен! Тем не менее,

файлов robots.txtявляются рекомендациями. На самом деле они не столько блокируют ботов, сколько предлагают , что боты не сканируют части сайта. Вот почему параметры на странице настроек конфиденциальности говорят: «Попросить поисковые системы не индексировать этот сайт».

Где я могу узнать больше о файлах robots.txt?

Вот общее руководство от Google, а вот SEO-документация WordPress.

Изменить настройки плагина

Мне понадобилось около недели, чтобы заметить это. Посещаемость сайта упала на 600%. Спасибо!

Хороший код, приятный интерфейс. В нем нет встроенной функции динамической замены (например, {siteurl}/sitemap_index.xml), но его можно добавить с помощью простого фильтра. Спасибо за отличный плагин!

Простой плагин, который помог мне исправить ошибку js. проблема в поиске гугл

Я использую этот плагин для решения проблемы с файлом robots.txt. Это очень полезный плагин. http://www.gemstonesprices.in Аметистовый камень

Прочитать 17 отзывов

«WP Robots Txt» — это программное обеспечение с открытым исходным кодом. Следующие люди внесли свой вклад в этот плагин.

Авторы

- Крисгитаргай

- Джордж Паттихис

1.

2

2- Обновить содержимое robots.txt по умолчанию

- Включить ссылку на карту сайта

- Код устранения предупреждений/ошибок

- Соответствие стандартам кодирования WP

- Обеспечьте совместимость с WP v6

1.1

- Поле настроек перенесено «официально» на страницу чтения

- Очистка общего кода

1.0

- Первоначальная версия

Служба поддержки

Проблемы, решенные за последние два месяца:

1 из 1

Посмотреть форум поддержки

Пожертвовать

Хотите поддержать продвижение этого плагина?

Пожертвовать этому плагину

Как оптимизировать файл robots.txt для SEO в WordPress (Руководство для начинающих)

Недавно один из наших читателей попросил нас дать совет, как оптимизировать файл robots.txt для улучшения SEO.

Файл Robots.txt сообщает поисковым системам, как сканировать ваш веб-сайт, что делает его невероятно мощным инструментом SEO.

В этой статье мы покажем вам, как создать идеальный файл robots.txt для SEO.

Что такое файл robots.txt?

Robots.txt — это текстовый файл, который владельцы веб-сайтов могут создать, чтобы указать роботам поисковых систем, как сканировать и индексировать страницы на их сайте.

Обычно он хранится в корневом каталоге, также известном как основная папка вашего веб-сайта. Базовый формат файла robots.txt выглядит следующим образом:

. Агент пользователя: [имя агента пользователя] Запретить: [строка URL не должна сканироваться] Агент пользователя: [имя агента пользователя] Разрешить: [строка URL для сканирования] Карта сайта: [URL вашего файла Sitemap в формате XML]

У вас может быть несколько строк инструкций, чтобы разрешить или запретить определенные URL-адреса и добавить несколько карт сайта. Если вы не запретите URL-адрес, поисковые роботы будут считать, что им разрешено его сканировать.

Вот как может выглядеть пример файла robots. txt:

txt:

Пользовательский агент: * Разрешить: /wp-content/uploads/ Запретить: /wp-content/plugins/ Запретить: /wp-admin/ Карта сайта: https://example.com/sitemap_index.xml

В приведенном выше примере robots.txt мы разрешили поисковым системам сканировать и индексировать файлы в нашей папке загрузки WordPress.

После этого мы запретили поисковым ботам сканировать и индексировать плагины и папки администратора WordPress.

Наконец, мы предоставили URL-адрес нашей XML-карты сайта.

Вам нужен файл robots.txt для вашего сайта WordPress?

Если у вас нет файла robots.txt, поисковые системы все равно будут сканировать и индексировать ваш сайт. Однако вы не сможете указать поисковым системам, какие страницы или папки им не следует сканировать.

Это не окажет большого влияния, если вы только начинаете вести блог и у вас мало контента.

Однако по мере того, как ваш веб-сайт растет и у вас появляется много контента, вы, вероятно, захотите лучше контролировать, как ваш веб-сайт сканируется и индексируется.

Вот почему.

Поисковые боты имеют квоту сканирования для каждого веб-сайта.

Это означает, что они сканируют определенное количество страниц во время сеанса сканирования. Если они не закончат сканирование всех страниц вашего сайта, они вернутся и возобновят сканирование в следующем сеансе.

Это может замедлить индексацию вашего сайта.

Вы можете исправить это, запретив поисковым роботам сканировать ненужные страницы, такие как страницы администратора WordPress, файлы плагинов и папку тем.

Запрещая ненужные страницы, вы сохраняете квоту сканирования. Это помогает поисковым системам сканировать еще больше страниц на вашем сайте и индексировать их как можно быстрее.

Еще одна веская причина использовать файл robots.txt — это когда вы хотите запретить поисковым системам индексировать пост или страницу на вашем сайте.

Это не самый безопасный способ скрыть контент от широкой публики, но он поможет вам предотвратить его появление в результатах поиска.

Как выглядит идеальный файл robots.txt?

Многие популярные блоги используют очень простой файл robots.txt. Их содержание может варьироваться в зависимости от потребностей конкретного сайта:

Пользовательский агент: * Запретить: Карта сайта: http://www.example.com/post-sitemap.xml Карта сайта: http://www.example.com/page-sitemap.xml

Этот файл robots.txt позволяет всем ботам индексировать весь контент и предоставляет им ссылку на карты сайта в формате XML.

Для сайтов WordPress мы рекомендуем следующие правила в файле robots.txt:

Пользовательский агент: * Разрешить: /wp-content/uploads/ Запретить: /wp-admin/ Запретить: /readme.html Запретить: /см./ Карта сайта: http://www.example.com/post-sitemap.xml Карта сайта: http://www.example.com/page-sitemap.xml

Указывает поисковым роботам индексировать все изображения и файлы WordPress. Он запрещает поисковым ботам индексировать панель администратора WordPress, файл readme и скрытые партнерские ссылки.

Добавляя карты сайта в файл robots.txt, вы облегчаете роботам Google поиск всех страниц на вашем сайте.

Теперь, когда вы знаете, как должен выглядеть идеальный файл robots.txt, давайте посмотрим, как создать файл robots.txt в WordPress.

Как создать файл robots.txt в WordPress?

Существует два способа создания файла robots.txt в WordPress. Вы можете выбрать метод, который лучше всего подходит для вас.

Метод 1: Редактирование файла Robots.txt с использованием All-in-One SEO

All-in-One SEO, также известный как AIOSEO, — лучший SEO-плагин для WordPress на рынке, используемый более чем 2 миллионами веб-сайтов.

Он прост в использовании и поставляется с генератором файлов robots.txt.

Если у вас еще не установлен плагин AIOSEO, вы можете ознакомиться с нашим пошаговым руководством по установке плагина WordPress.

Примечание: Бесплатная версия AIOSEO также доступна и имеет эту функцию.

После установки и активации плагина вы можете использовать его для создания и редактирования файла robots.txt непосредственно из области администрирования WordPress.

Просто перейдите на страницу All in One SEO » Инструменты , чтобы отредактировать файл robots.txt.

Во-первых, вам нужно включить параметр редактирования, щелкнув переключатель «Включить настраиваемые файлы Robots.txt» в синий цвет.

Включив этот переключатель, вы можете создать собственный файл robots.txt в WordPress.

All in One SEO покажет ваш существующий файл robots.txt в разделе «Предварительный просмотр Robots.txt» в нижней части экрана.

В этой версии будут отображаться правила по умолчанию, добавленные WordPress.

Эти правила по умолчанию предписывают поисковым системам не сканировать ваши основные файлы WordPress, позволяют ботам индексировать весь контент и предоставляют им ссылку на карты сайта XML вашего сайта.

Теперь вы можете добавить свои собственные правила, чтобы улучшить файл robots. txt для SEO.

txt для SEO.

Чтобы добавить правило, введите пользовательский агент в поле «Пользовательский агент». Использование * применит правило ко всем пользовательским агентам.

Затем выберите, хотите ли вы «Разрешить» или «Запретить» поисковым системам сканировать.

Затем введите имя файла или путь к каталогу в поле «Путь к каталогу».

Правило будет автоматически применено к вашему файлу robots.txt. Чтобы добавить другое правило, нажмите кнопку «Добавить правило».

Мы рекомендуем добавлять правила, пока вы не создадите идеальный формат robots.txt, о котором мы рассказали выше.

Ваши пользовательские правила будут выглядеть следующим образом.

Когда вы закончите, не забудьте нажать кнопку «Сохранить изменения», чтобы сохранить изменения.

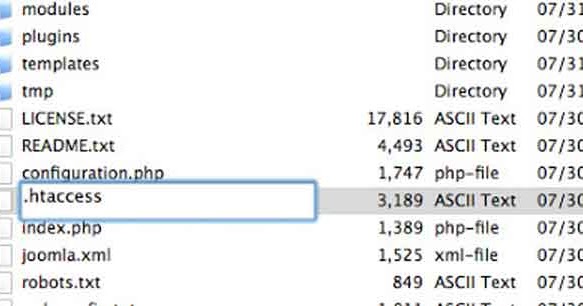

Способ 2. Редактирование файла robots.txt вручную с использованием FTP

Для этого метода вам потребуется использовать FTP-клиент для редактирования файла robots.txt.

Просто подключитесь к своей учетной записи хостинга WordPress с помощью FTP-клиента.

Оказавшись внутри, вы сможете увидеть файл robots.txt в корневой папке вашего сайта.

Если вы его не видите, скорее всего, у вас нет файла robots.txt.

В этом случае вы можете просто создать его.

Robots.txt — это обычный текстовый файл, что означает, что вы можете загрузить его на свой компьютер и отредактировать с помощью любого текстового редактора, такого как Блокнот или TextEdit.

После сохранения изменений вы можете загрузить их обратно в корневую папку вашего сайта.

Как проверить файл robots.txt?

После создания файла robots.txt рекомендуется протестировать его с помощью инструмента для проверки robots.txt.

Существует множество инструментов для тестирования robots.txt, но мы рекомендуем использовать один из них в Google Search Console.

Во-первых, ваш сайт должен быть связан с Google Search Console. Если вы еще этого не сделали, ознакомьтесь с нашим руководством о том, как добавить свой сайт WordPress в Google Search Console.

Затем вы можете использовать инструмент тестирования роботов Google Search Console.

Просто выберите свой объект из выпадающего списка.

Инструмент автоматически извлечет файл robots.txt вашего веб-сайта и выделит ошибки и предупреждения, если они были обнаружены.

Заключительные мысли

Целью оптимизации файла robots.txt является предотвращение сканирования поисковыми системами страниц, которые не являются общедоступными. Например, страницы в папке wp-plugins или страницы в папке администратора WordPress.

Среди экспертов по SEO распространен миф о том, что блокировка категорий, тегов и архивных страниц WordPress улучшит скорость сканирования и приведет к более быстрому индексированию и более высокому рейтингу.

Это неправда. Это также противоречит рекомендациям Google для веб-мастеров.

Мы рекомендуем использовать указанный выше формат robots.txt для создания файла robots.txt для вашего веб-сайта.

Мы надеемся, что эта статья помогла вам научиться оптимизировать файл robots.

1 Пожертвуйте на развитие блога, пожалуйста.

1 Пожертвуйте на развитие блога, пожалуйста. txt file exists on your site, WordPress won’t process any request for one, so there will be no conflict.

txt file exists on your site, WordPress won’t process any request for one, so there will be no conflict.