Правильный robots.txt для WordPress — 2023

- 1. Оптимальный robots.txt

- 2. Расширенный вариант (разделенные правила для Google и Яндекса)

- 3. Оптимальный Robots.txt для WooCommerce

- 4. Где находится файл robots.txt в WordPress

- 5. Часто задаваемые вопросы

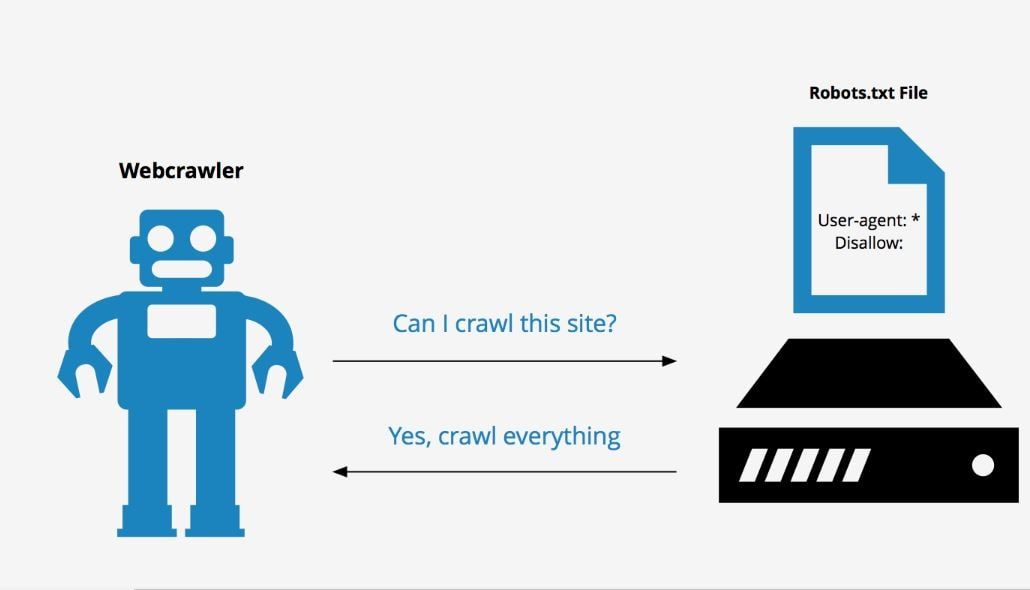

Robots.txt – текстовой файл, который сообщает поисковым роботам, какие файлы и папки следует сканировать (индексировать), а какие сканировать не нужно.

Поисковые системы, такие как Яндекс и Google сначала проверяют файл robots.txt, после этого начинают обход с помощью веб-роботов, которые занимаются архивированием и категоризацией веб сайтов.

youtube.com/embed/NOU6O8GbmMU?feature=oembed&enablejsapi=1&origin=https://wptuts.ru» frameborder=»0″ allow=»accelerometer; autoplay; clipboard-write; encrypted-media; gyroscope; picture-in-picture» allowfullscreen=»»>Файл robots.txt содержит набор инструкций, которые просят бота игнорировать определенные файлы или каталоги. Это может быть сделано в целях конфиденциальности или потому что владелец сайта считает, что содержимое этих файлов и каталогов не должны появляться в выдаче поисковых систем.

Если веб-сайт имеет более одного субдомена, каждый субдомен должен иметь свой собственный файл robots.txt. Важно отметить, что не все боты будут использовать файл robots.txt. Некоторые злонамеренные боты даже читают файл robots.txt, чтобы найти, какие файлы и каталоги Вы хотели скрыть. Кроме того, даже если файл robots.txt указывает игнорировать определенные страницы на сайте, эти страницы могут по-прежнему появляться в результатах поиска, если на них ссылаются другие просканированные страницы.

Оптимальный robots.txt

User-agent: * # общие правила для роботов, кроме Яндекса и Google,

# т.к. для них правила ниже

Disallow: /cgi-bin # системная папка на хостинге, закрывается всегда

Disallow: /? # все параметры запроса на главной

Disallow: /wp- # все файлы WP: /wp-json/, /wp-includes, /wp-content/plugins

Disallow: /wp/ # если есть подкаталог /wp/, где установлена CMS (если нет,

# правило можно удалить)

Disallow: *?s= # запрос поиска

Disallow: *&s= # запрос поиска

Disallow: /search/ # запрос поиска

Disallow: /author/ # архив автора, если у Вас новостной блог с авторскими колонками, то можно открыть

# архив автора, если у Вас новостной блог с авторскими колонками, то можно открыть

Disallow: /users/ # архив авторов

Disallow: */trackback # трекбеки, уведомления в комментариях о появлении открытой

# ссылки на статью

Disallow: */feed # все фиды

Disallow: */rss # rss фид

Disallow: */embed # все встраивания

Disallow: */wlwmanifest.

xml # xml-файл манифеста Windows Live Writer (если не используете,

# правило можно удалить)

Disallow: /xmlrpc.php # файл WordPress API

Disallow: *utm*= # ссылки с utm-метками

Disallow: *openstat= # ссылки с метками openstat

Allow: */uploads # открываем папку с файлами uploads

# Укажите один или несколько файлов Sitemap (дублировать для каждого User-agent

# не нужно). Google XML Sitemap создает 2 карты сайта, как в примере ниже.

Sitemap: http://site.ru/sitemap.xml

Sitemap: http://site.ru/sitemap.xml.gz

# Host прописывать больше не нужно.Скачать оптимальную версию robots.txt

Расширенный вариант (разделенные правила для Google и Яндекса)

User-agent: * # общие правила для роботов, кроме Яндекса и Google,

# т.к. для них правила ниже

Disallow: /cgi-bin # папка на хостинге

Disallow: /? # все параметры запроса на главной

Disallow: /wp- # все файлы WP: /wp-json/, /wp-includes, /wp-content/plugins

Disallow: /wp/ # если есть подкаталог /wp/, где установлена CMS (если нет,

# правило можно удалить)

Disallow: *?s= # поиск

Disallow: *&s= # поиск

Disallow: /search/ # поиск

Disallow: /author/ # архив автора

Disallow: /users/ # архив авторов

Disallow: */trackback # трекбеки, уведомления в комментариях о появлении открытой

# ссылки на статью

Disallow: */feed # все фиды

Disallow: */rss # rss фид

Disallow: */embed # все встраивания

Disallow: */wlwmanifest.

xml # xml-файл манифеста Windows Live Writer (если не используете,

# правило можно удалить)

Disallow: /xmlrpc.php # файл WordPress API

Disallow: *utm*= # ссылки с utm-метками

Disallow: *openstat= # ссылки с метками openstat

Allow: */uploads # открываем папку с файлами uploads

User-agent: GoogleBot # правила для Google (комментарии не дублирую)

Disallow: /cgi-bin

Disallow: /?

Disallow: /wp-

Disallow: /wp/

Disallow: *?s=

Disallow: *&s=

Disallow: /search/

Disallow: /author/

Disallow: /users/

Disallow: */trackback

Disallow: */feed

Disallow: */rss

Disallow: */embed

Disallow: */wlwmanifest.xml

Disallow: /xmlrpc.php

Disallow: *utm*=

Disallow: *openstat=

Allow: */uploads

Allow: /*/*.js # открываем js-скрипты внутри /wp- (/*/ - для приоритета)

Allow: /*/*.css # открываем css-файлы внутри /wp- (/*/ - для приоритета)

Allow: /wp-*.png # картинки в плагинах, cache папке и т.д.

Allow: /wp-*.

jpg # картинки в плагинах, cache папке и т.д.

Allow: /wp-*.jpeg # картинки в плагинах, cache папке и т.д.

Allow: /wp-*.gif # картинки в плагинах, cache папке и т.д.

Allow: /wp-admin/admin-ajax.php # используется плагинами, чтобы не блокировать JS и CSS

User-agent: Yandex # правила для Яндекса (комментарии не дублирую)

Disallow: /cgi-bin

Disallow: /?

Disallow: /wp-

Disallow: /wp/

Disallow: *?s=

Disallow: *&s=

Disallow: /search/

Disallow: /author/

Disallow: /users/

Disallow: */trackback

Disallow: */feed

Disallow: */rss

Disallow: */embed

Disallow: */wlwmanifest.xml

Disallow: /xmlrpc.php

Allow: */uploads

Allow: /*/*.js

Allow: /*/*.css

Allow: /wp-*.png

Allow: /wp-*.jpg

Allow: /wp-*.jpeg

Allow: /wp-*.gif

Allow: /wp-admin/admin-ajax.php

Clean-Param: utm_source&utm_medium&utm_campaign # Яндекс рекомендует не закрывать

# от индексирования, а удалять параметры меток,

# Google такие правила не поддерживает

Clean-Param: openstat # аналогично

# Укажите один или несколько файлов Sitemap (дублировать для каждого User-agent

# не нужно).

Скачать Расширенный вариант robots.txt

Оптимальный Robots.txt для WooCommerce

Владельцы интернет-магазинов на WordPress – WooCommerce также должны позаботиться о правильном robots.txt. Мы закроем от индексации корзину, страницу оформления заказа и ссылки на добавление товара в корзину.

User-agent: * Disallow: /cgi-bin Disallow: /? Disallow: /wp- Disallow: /wp/ Disallow: *?s= Disallow: *&s= Disallow: /search/ Disallow: /author/ Disallow: /users/ Disallow: */trackback Disallow: */feed Disallow: */rss Disallow: */embed Disallow: */wlwmanifest.xml Disallow: /xmlrpc.php Disallow: *utm*= Disallow: *openstat= Disallow: /cart/ Disallow: /checkout/ Disallow: /*add-to-cart=* Allow: */uploads Allow: /*/*.js Allow: /*/*.css Allow: /wp-*.png Allow: /wp-*.jpg Allow: /wp-*.jpeg Allow: /wp-*.gif Allow: /wp-admin/admin-ajax.php Sitemap: https://site.ru/sitemap_index.xml

Скачать robots.txt для WooCommerce

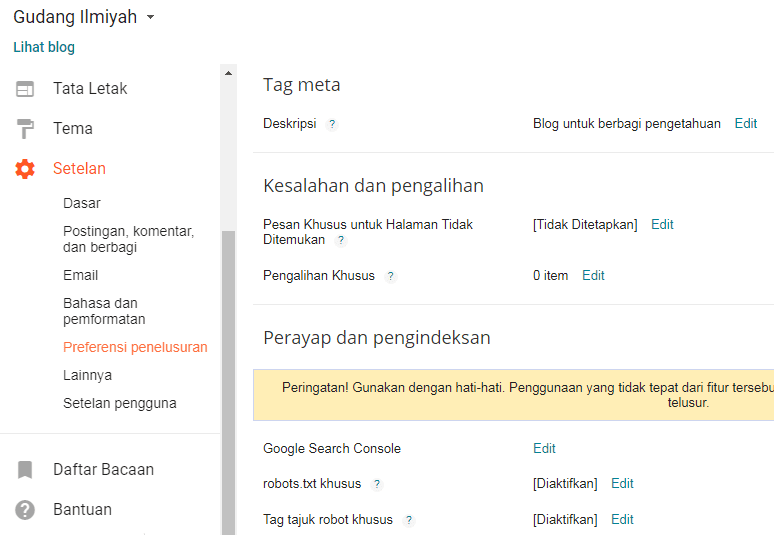

Где находится файл robots.txt в WordPress

Обычно robots.txt располагается в корне сайта. Если его нет, то потребуется создать текстовой файл и загрузить его на сайт по FTP или панель управления на хостинге. Если Вы не смогли найти robots.txt в корне сайта, но при переходе по ссылке вашсайт.ру/robots.txt он открывается, значит какой то из SEO плагинов сам генерирует его.

К примеру плагин Yoast SEO создает виртуальный файл, которого нет в корне сайта.

Как редактировать robots.txt с помощью Yoast SEO

- Зайдите в админ панель сайта

Админа панель находится по следующему адресу вашсайт.ру/wp-admin/

- Слева в консоли наведите на кнопку SEO и в выпадающем окне выберите “Инструменты”. Перейдите в раздел, как указано на картинке.

- Зайдите в редактор файлов

Этот инструмент позволит быстро отредактировать такие важные для вашего SEO файлы, как robots.

txt и .htaccess (при его наличии).

txt и .htaccess (при его наличии). - Если файла robots.txt нет, нажмите на кнопку создать, либо вставьте нужное содержимое.

Содержимое файла для WordPress и WooCommerce можно взять из примеров выше.

- Сохраните изменения в robots.txt

После сохранения файла вы можете проверить правильность через сервисы проверки.

Чтобы установить плагин Yoast SEO воспользуйтесь данной статьей – ссылка.

Часто задаваемые вопросы

Как проверить правильность работы robots.txt?

У Google и Яндекс есть средства для проверки файла robots.txt:

Яндекс – https://webmaster.yandex.ru/tools/robotstxt/

Google – https://support.google.com/webmasters/answer/6062598?hl=ru

Закрывать ли feed в robots.txt?

По умолчанию мы рекомендуем закрывать feed от индексации в robots.txt. Открытие feed может потребоваться, если вы например настраиваете Турбо-страницы от Яндекса или выгружаете свою ленту в другой сервис.

Как разрешить индексировать feed Турбо-страниц

Добавьте директиву: Allow: /feed/turbo/, тогда Яндекс сможет проверять ваши турбо-страницы и обновлять их.

Если вы нашли ошибку, пожалуйста, выделите фрагмент текста и нажмите Ctrl+Enter.

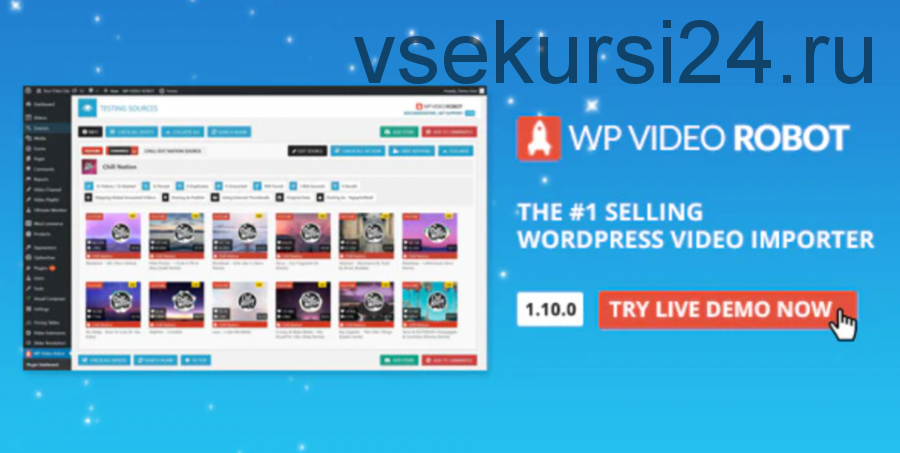

Virtual Robots.txt — Плагин для WordPress

- Детали

- Отзывы

- Установка

- Разработка

Поддержка

Virtual Robots.txt is an easy (i.e. automated) solution to creating and managing a robots.txt file for your site. Instead of mucking about with FTP, files, permissions ..etc, just upload and activate the plugin and you’re done.

By default, the Virtual Robots.txt plugin allows access to the parts of WordPress that good bots like Google need to access. Other parts are blocked.

If the plugin detects an existing XML sitemap file, a reference to it will be automatically added to your robots. txt file.

txt file.

- Upload pc-robotstxt folder to the

- Активируйте плагин используя меню ‘Плагины’ в WordPress.

- Once you have the plugin installed and activated, you’ll see a new Robots.txt menu link under the Settings menu. Click that menu link to see the plugin settings page. From there you can edit the contents of your robots.txt file.

Will it conflict with an existing robots.txt file?

If a physical robots.txt file exists on your site, WordPress won’t process any request for one, so there will be no conflict.

Will this work for sub-folder installations of WordPress?

Out of the box, no. Because WordPress is in a sub-folder, it won’t «know» when someone is requesting the robots.txt file which must be at the root of the site.

Does this plugin modify individual posts, pages, or categories?

No it doesn’t.

Why does the default plugin block certain files and folders?

By default, the virtual robots.

txt is set to block WordPress files and folders that don’t need to be accessed by search engines. Of course, if you disagree with the defaults, you can easily change them.

txt is set to block WordPress files and folders that don’t need to be accessed by search engines. Of course, if you disagree with the defaults, you can easily change them.

Simple and easy. Works perfectly.

Works great and easy to use and customise. It already set by default the directories that need to be left out of Search Engines scanning/indexing… Very happy with it!

What I saw wasn’t what I got. The XML sitemap wasn’t included in the robots.txt file, even thought this was described as a feature that should work out of the box. In addition to that, upon installing this plugin, it blocked certain directories without asking. Lastly, it inserts a line at the top of the file, promoting the plugin. That should be an optional feature that users are empowered to turn off. All in all, it offers the functionality, but falls short and disappoints in other areas.

It was good

I thought this would be simple. Sure sounds simple.

But after I saved your suggested text to my brand new «virtual robots.txt», I clicked the link where it says «You can preview your robots.txt file here (opens a new window). If your robots.txt file doesn’t match what is shown below, you may have a physical file that is being displayed instead.»

That new window shows text that is indeed different from the plugin’s. So I understand that to mean there’s a physical robots.txt file on my server.

So which one is actually going to be used?

Your FAQ offers this:

Q: Will it conflict with any existing robots.txt file?

A: If a physical robots.txt file exists on your site, WordPress won’t process any request for one, so there will be no conflict.

If a physical file exists, WP won’t process ANY request for one?

This SOUNDS like WP will ignore BOTH the physical file AND your virtual one. In which case, what’s the point? Might as well not have one, it seems to me.

When I manually go to mydomain.com/robots.txt, I see what’s in the physical file, not what the plugin saved.

Sure sounds simple.

But after I saved your suggested text to my brand new «virtual robots.txt», I clicked the link where it says «You can preview your robots.txt file here (opens a new window). If your robots.txt file doesn’t match what is shown below, you may have a physical file that is being displayed instead.»

That new window shows text that is indeed different from the plugin’s. So I understand that to mean there’s a physical robots.txt file on my server.

So which one is actually going to be used?

Your FAQ offers this:

Q: Will it conflict with any existing robots.txt file?

A: If a physical robots.txt file exists on your site, WordPress won’t process any request for one, so there will be no conflict.

If a physical file exists, WP won’t process ANY request for one?

This SOUNDS like WP will ignore BOTH the physical file AND your virtual one. In which case, what’s the point? Might as well not have one, it seems to me.

When I manually go to mydomain.com/robots.txt, I see what’s in the physical file, not what the plugin saved. So… is it working? I don’t know!

Should I delete the physical file and assume the virtual one will work? I don’t know!

Should I delete this plugin and edit the physical file manually? Most likely.

2 stars instead of 1 because I appreciate getting the suggested lines to include in my file.

So… is it working? I don’t know!

Should I delete the physical file and assume the virtual one will work? I don’t know!

Should I delete this plugin and edit the physical file manually? Most likely.

2 stars instead of 1 because I appreciate getting the suggested lines to include in my file.

I like the fact that it’s so clean. Thanks for building it!

Посмотреть все 9 отзывов

«Virtual Robots.txt» — проект с открытым исходным кодом. В развитие плагина внесли свой вклад следующие участники:

Участники

- Marios Alexandrou

«Virtual Robots.txt» переведён на 1 язык. Благодарим переводчиков за их работу.

Перевести «Virtual Robots.txt» на ваш язык.

Заинтересованы в разработке?

Посмотрите код, проверьте SVN репозиторий, или подпишитесь на журнал разработки по RSS.

1.10

- Fix to prevent the saving of HTML tags within the robots.

txt form field. Thanks to TrustWave for identifying this issue.

txt form field. Thanks to TrustWave for identifying this issue.

1.9

- Fix for PHP 7. Thanks to SharmPRO.

1.8

- Undoing last fixes as they had unintended side-effects.

1.7

- Further fixes to issue with newlines being removed. Thanks to FAMC for reporting and for providing the code fix.

- After upgrading, visit and re-save your settings and confirm they look correct.

1.6

- Fixed bug where newlines were being removed. Thanks to FAMC for reporting.

1.5

- Fixed bug where plugin assumed robots.txt would be at http when it may reside at https. Thanks to jeffmcneill for reporting.

1.4

- Fixed bug for link to robots.txt that didn’t adjust for sub-folder installations of WordPress.

- Updated default robots.txt directives to match latest practices for WordPress.

- Plugin development and support transferred to Marios Alexandrou.

1.

3

3- Now uses do_robots hook and checks for is_robots() in plugin action.

1.2

- Added support for existing sitemap.xml.gz file.

1.1

- Added link to settings page, option to delete settings.

1.0

- Первая версия.

Мета

- Версия: 1.10

- Обновление: 1 неделя назад

- Активных установок: 40 000+

- Версия WordPress: 5.0 или выше

- Совместим вплоть до: 6.2

- Языки:

English (US) и Swedish.

Перевести на ваш язык

- Метки:

crawlerrobotrobotsrobots.txt

- Дополнительно

Оценки

Посмотреть все

- 5 звёзд 6

- 4 звезды 0

- 3 звезды 0

- 2 звезды 1

- 1 звезда 1

Войдите, чтобы оставить отзыв.

Участники

- Marios Alexandrou

Поддержка

Решено проблем за последние 2 месяца:

0 из 1

Перейти в форум поддержки

Пожертвование

Would you like to support the advancement of this plugin?

Пожертвовать на развитие плагина

Что это такое и как его использовать

Вы когда-нибудь слышали термин robots.txt и задавались вопросом, как он применим к вашему веб-сайту? На большинстве веб-сайтов есть файл robots.txt, но это не значит, что большинство владельцев сайтов понимают его. В этом посте мы надеемся изменить это, предложив подробно изучить файл robots.txt WordPress, а также то, как он может контролировать и ограничивать доступ к вашему сайту.

Нам предстоит многое рассказать, так что давайте начнем!

Мгновенно ускорьте свой сайт WordPress на 20%

Воспользуйтесь преимуществами самых быстрых серверов Google и сети Premium Tier, поддерживаемой более чем 275 CDN Cloudflare по всему миру, для невероятно быстрой загрузки. Входит бесплатно во все планы WordPress.

Входит бесплатно во все планы WordPress.

Начните сегодня

Что такое файл robots.txt WordPress?

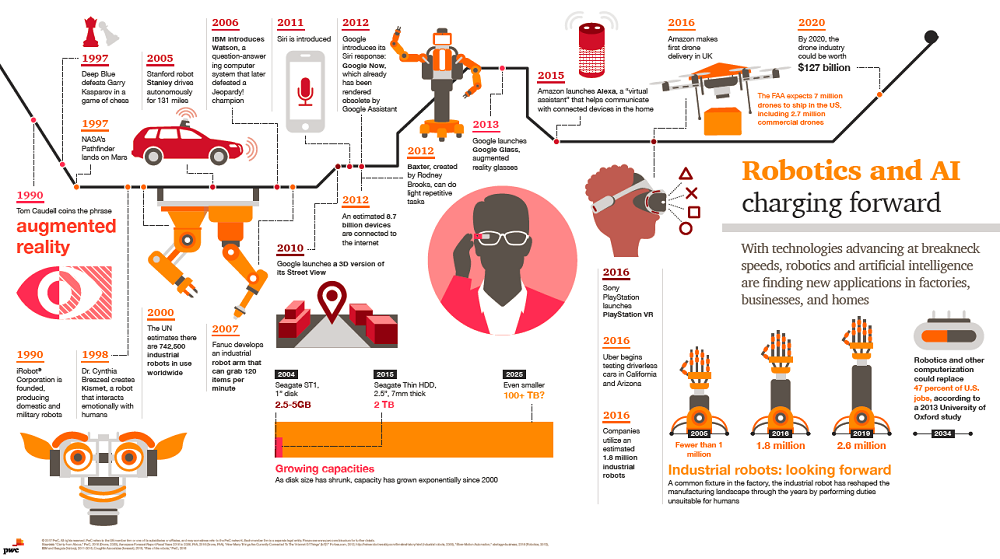

Прежде чем мы поговорим о файле robots.txt WordPress, важно определить, что такое «робот» в данном случае. Роботы — это «боты» любого типа, которые посещают веб-сайты в Интернете. Наиболее распространенным примером являются сканеры поисковых систем. Эти боты «ползают» по сети, помогая таким поисковым системам, как Google, индексировать и ранжировать миллиарды страниц в Интернете.

Итак, боты есть, вообще , хорошая вещь для интернета… ну или хотя бы нужная вещь. Но это не обязательно означает, что вы или другие владельцы сайтов хотите, чтобы боты свободно бегали. Желание контролировать взаимодействие веб-роботов с веб-сайтами привело к созданию в середине 1990-х годов стандарта исключения роботов . Robots.txt является практической реализацией этого стандарта — , он позволяет вам контролировать взаимодействие участвующих ботов с вашим сайтом . Вы можете полностью заблокировать ботов, ограничить их доступ к определенным областям вашего сайта и многое другое.

Вы можете полностью заблокировать ботов, ограничить их доступ к определенным областям вашего сайта и многое другое.

Однако эта часть «участия» важна. Robots.txt не может заставить бота следовать его указаниям. А вредоносные боты могут и будут игнорировать файл robots.txt. Кроме того, даже авторитетные организации игнорируют некоторых команд, которые вы можете поместить в robots.txt. Например, Google будет игнорировать любые правила, которые вы добавите в файл robots.txt о том, как часто его поисковые роботы посещают ваш сайт. Вы можете настроить скорость, с которой Google сканирует ваш веб-сайт, на странице настроек скорости сканирования вашего ресурса в Google Search Console.

Если у вас много проблем с ботами, может пригодиться защитное решение, такое как Cloudflare или Sucuri.

Как найти robots.txt?

Файл robots.txt находится в корне вашего веб-сайта, поэтому добавление /robots.txt после вашего домена должно загрузить файл (если он у вас есть). Например, https://kinsta.com /robots.txt .

Например, https://kinsta.com /robots.txt .

Когда следует использовать файл robots.txt?

Для большинства владельцев сайтов преимущества хорошо структурированного файла robots.txt сводятся к двум категориям:

- Оптимизация ресурсов сканирования поисковых систем путем указания им не тратить время на страницы, которые вы не хотите индексировать. Это помогает поисковым системам сосредоточиться на сканировании наиболее важных для вас страниц.

- Оптимизация использования сервера путем блокировки ботов, которые тратят ресурсы впустую.

Robots.txt не предназначен специально для управления тем, какие страницы индексируются в поисковых системах

Robots.txt не является надежным способом управления тем, какие страницы индексируются поисковыми системами. Если вашей основной целью является предотвращение включения определенных страниц в результаты поисковой системы, правильным подходом является использование мета-тега noindex или защиты паролем.

Это связано с тем, что файл robots.txt прямо не указывает поисковым системам не индексировать контент — он просто говорит им не сканировать его. Хотя Google не будет сканировать отмеченные области внутри вашего сайта, сам Google заявляет, что если внешний сайт ссылается на страницу, которую вы исключаете с помощью файла robots.txt, Google все равно может проиндексировать эту страницу.

Джон Мюллер, аналитик Google для веб-мастеров, также подтвердил, что если на страницу есть ссылки, указывающие на нее, даже если она заблокирована файлом robots.txt, она все равно может быть проиндексирована. Ниже приводится то, что он сказал в видеовстрече Webmaster Central:

Здесь следует иметь в виду одну вещь: если эти страницы заблокированы robots.txt, то теоретически может случиться так, что кто-то случайно свяжется с одной из этих страниц. И если они это сделают, то может случиться так, что мы проиндексируем этот URL без какого-либо контента, потому что он заблокирован robots.

txt. Таким образом, мы не знали бы, что вы не хотите, чтобы эти страницы действительно индексировались.

Принимая во внимание, что если они не заблокированы robots.txt, вы можете поместить на эти страницы метатег noindex. И если кто-то ссылается на них, и мы случайно просканируем эту ссылку и подумаем, что, может быть, здесь есть что-то полезное, тогда мы будем знать, что эти страницы не нужно индексировать, и мы можем просто полностью исключить их из индексации.

Итак, в этом отношении, если на этих страницах есть что-то, что вы не хотите индексировать, не запрещайте их, вместо этого используйте noindex .

Нужен ли мне файл robots.txt?

Важно помнить, что у вас нет файла robots.txt на вашем сайте. Если у вас нет проблем с тем, что все боты могут свободно сканировать все ваши страницы, вы можете не добавлять их, поскольку у вас нет реальных инструкций для сканеров.

В некоторых случаях вы даже не сможете добавить файл robots. txt из-за ограничений используемой вами CMS. Это нормально, но есть и другие способы проинструктировать ботов о том, как сканировать ваши страницы без использования файла robots.txt.

txt из-за ограничений используемой вами CMS. Это нормально, но есть и другие способы проинструктировать ботов о том, как сканировать ваши страницы без использования файла robots.txt.

Какой код состояния HTTP должен быть возвращен для файла robots.txt?

Файл robots.txt должен возвращать код состояния HTTP 200 OK, чтобы поисковые роботы могли получить к нему доступ.

Если у вас возникли проблемы с индексацией ваших страниц поисковыми системами, стоит дважды проверить код состояния, возвращенный для вашего файла robots.txt. Все, кроме кода состояния 200, может помешать поисковым роботам получить доступ к вашему сайту.

Некоторые владельцы сайтов сообщают о деиндексации страниц из-за того, что их файл robots.txt возвращает статус, отличный от 200. В марте 2022 года владелец веб-сайта спросил о проблеме с индексацией во время встречи Google SEO в рабочее время, и Джон Мюллер объяснил, что файл robots.txt должен либо возвращать статус 200, если они присутствуют, либо статус 4XX, если файл не существовать. В этом случае возвращалась внутренняя ошибка сервера 500, которая, по словам Мюллера, могла привести к тому, что робот Googlebot исключил сайт из индексации.

В этом случае возвращалась внутренняя ошибка сервера 500, которая, по словам Мюллера, могла привести к тому, что робот Googlebot исключил сайт из индексации.

То же самое можно увидеть в этом твите, где владелец сайта сообщил, что весь его сайт деиндексирован из-за того, что файл robots.txt возвращает ошибку 500.

[Совет по поисковой оптимизации]

Если у вас возникли проблемы с индексированием, убедитесь, что ваш файл robots.txt возвращает либо 200, либо 404.

Если ваш файл возвращает 500, Google в конечном итоге деиндексирует ваш веб-сайт, как я видел в этом проекте. pic.twitter.com/8KiYLgDVRo

— Антуан Эрипрет (@antoineripret) 14 ноября 2022 г.

Можно ли использовать метатег Robots вместо файла robots.txt?

Нет. Метатег robots позволяет вам контролировать, какие страницы индексируются, а файл robots.txt позволяет вам контролировать, какие страницы сканируются. Боты должны сначала просканировать страницы, чтобы увидеть метатеги, поэтому вам следует избегать попыток использовать метатеги disallow и noindex, так как noindex не будет обнаружен.

Боты должны сначала просканировать страницы, чтобы увидеть метатеги, поэтому вам следует избегать попыток использовать метатеги disallow и noindex, так как noindex не будет обнаружен.

Если ваша цель — исключить страницу из поисковых систем, метатег noindex обычно является лучшим вариантом.

Как создать и отредактировать файл robots.txt в WordPress

По умолчанию WordPress автоматически создает виртуальный файл robots.txt для вашего сайта. Так что, даже если вы и пальцем не пошевелите, на вашем сайте уже должен быть файл robots.txt по умолчанию. Вы можете проверить, так ли это, добавив «/robots.txt» в конец вашего доменного имени. Например, «https://kinsta.com/robots.txt» открывает файл robots.txt, который мы используем здесь, в Kinsta.

Пример файла robots.txt

Вот пример файла robots.txt от Kinsta:

Пример файла robots.txt Это предоставляет всем роботам инструкции о том, какие пути игнорировать (например, путь wp-admin) с любыми исключениями (например, admin-ajax. php), а также расположение XML-карты сайта Kinsta.

php), а также расположение XML-карты сайта Kinsta.

Поскольку этот файл является виртуальным, вы не можете его редактировать. Если вы хотите отредактировать файл robots.txt, вам нужно фактически создать физический файл на своем сервере, которым вы сможете манипулировать по мере необходимости. Вот три простых способа сделать это:

Как создать и отредактировать файл robots.txt в WordPress с помощью Yoast SEO

Если вы используете популярный плагин Yoast SEO, вы можете создать (а затем отредактировать) файл robots.txt прямо из интерфейса Yoast. Однако, прежде чем вы сможете получить к нему доступ, вам нужно перейти к SEO → Инструменты и нажать Редактор файлов

Перейдите к редактору файлов в Yoast SEOИ как только вы нажмете эту кнопку, вы сможете редактировать содержимое вашего файла robots.txt непосредственно из того же интерфейса, а затем сохраните все внесенные изменения.

Отредактируйте и сохраните изменения в файле robots. txt

txtЕсли у вас еще нет физического файла robots.txt, Yoast предложит вам вариант Создать файл robots.txt :

Создать файл robots.txt Как вы читаете дальше, мы углубимся в то, какие типы директив следует помещать в файл robots.txt WordPress.

Как создать и отредактировать файл robots.txt с помощью All-in-One SEO

Если вы используете почти такой же популярный плагин Yoast All-in-One SEO Pack , вы также можете создавать и редактировать ваш файл WordPress robots.txt прямо из интерфейса плагина. Все, что вам нужно сделать, это перейти к All-in-One SEO → Инструменты :

Как перейти к robots.txt в All-in-One SEOЗатем переключите переключатель Enable Custom robots.txt , чтобы он был включен. Это позволит вам создавать собственные правила и добавлять их в файл robots.txt:

Как добавить собственные правила в robots.txt в All-in-One SEOКак создать и отредактировать файл robots.

txt через FTP

txt через FTPЕсли вы не используете SEO-плагин, предлагающий функциональность robots.txt, вы все равно можете создавать файл robots.txt и управлять им через SFTP. Сначала с помощью любого текстового редактора создайте пустой файл с именем «robots.txt»:

Как создать свой собственный файл Robots.txtЗатем подключитесь к своему сайту через SFTP и загрузите этот файл в корневую папку вашего сайта. Вы можете внести дополнительные изменения в файл robots.txt, отредактировав его через SFTP или загрузив новые версии файла.

Что поместить в файл robots.txt

Хорошо, теперь у вас есть физический файл robots.txt на вашем сервере, который вы можете редактировать по мере необходимости. Но что вы на самом деле делаете с этим файлом? Что ж, как вы узнали из первого раздела, robots.txt позволяет вам контролировать, как роботы взаимодействуют с вашим сайтом. Вы делаете это с помощью двух основных команд:

- User-agent — позволяет настроить таргетинг на определенных ботов.

Пользовательские агенты — это то, что боты используют для идентификации себя. С ними можно было бы, например, создать правило, применимое к Bing, но не к Google.

Пользовательские агенты — это то, что боты используют для идентификации себя. С ними можно было бы, например, создать правило, применимое к Bing, но не к Google. - Запретить — позволяет запретить роботам доступ к определенным областям вашего сайта.

Существует также команда Разрешить , которую вы будете использовать в определенных ситуациях. По умолчанию все на вашем сайте отмечено цифрой 9.0019 Разрешить , поэтому нет необходимости использовать команду Разрешить в 99% ситуаций. Но это удобно, когда вы хотите Запретить доступ к папке и ее дочерним папкам, но Разрешить доступ к одной конкретной дочерней папке.

Чтобы добавить правила, сначала укажите, к какому User-agent должно применяться правило, а затем укажите, какие правила следует применять, используя Disallow и Allow . Есть также некоторые другие команды, такие как Задержка сканирования и Карта сайта , но это либо:

- Игнорируется большинством основных поисковых роботов, либо интерпретируется совершенно по-разному (в случае задержки сканирования)

- Излишне использовать такие инструменты, как Google Search Console (для карт сайта)

Давайте рассмотрим некоторые конкретные варианты использования, чтобы показать вам, как все это сочетается.

Как использовать Robots.txt Запретить все, чтобы заблокировать доступ ко всему вашему сайту

Допустим, вы хотите заблокировать все доступ поисковых роботов к вашему сайту. Это вряд ли произойдет на живом сайте, но пригодится для сайта разработки. Для этого вы должны добавить код robots.txt, запрещающий весь код, в файл robots.txt WordPress:

User-agent: * Disallow: /

Что происходит в этом коде?

Звездочка * рядом с User-agent означает «все пользовательские агенты». Звездочка — это подстановочный знак, означающий, что он применяется к каждому отдельному пользовательскому агенту. /slash рядом с Disallow говорит, что вы хотите запретить доступ к всем страницам, которые содержат «yourdomain.com/» (то есть каждую страницу на вашем сайте).

Как использовать robots.txt, чтобы заблокировать доступ одного бота к вашему сайту

Давайте изменим ситуацию. В этом примере мы притворимся, что вам не нравится тот факт, что Bing сканирует ваши страницы. Вы все время являетесь командой Google и даже не хотите, чтобы Bing просматривал ваш сайт. Чтобы заблокировать только Bing от сканирования вашего сайта, вы должны заменить подстановочный знак *звездочка с Bingbot:

В этом примере мы притворимся, что вам не нравится тот факт, что Bing сканирует ваши страницы. Вы все время являетесь командой Google и даже не хотите, чтобы Bing просматривал ваш сайт. Чтобы заблокировать только Bing от сканирования вашего сайта, вы должны заменить подстановочный знак *звездочка с Bingbot:

Агент пользователя: Bingbot Disallow: /

По сути, приведенный выше код говорит , что только применяют правило Disallow к ботам с агентом пользователя «Bingbot» . Теперь вы вряд ли захотите заблокировать доступ к Bing, но этот сценарий пригодится, если есть конкретный бот, которому вы не хотите получать доступ к своему сайту. На этом сайте есть хороший список имен большинства известных пользовательских агентов службы.

Как использовать robots.txt для блокировки доступа к определенной папке или файлу

В этом примере предположим, что вы хотите заблокировать доступ только к определенному файлу или папке (и ко всем подпапкам этой папки). Чтобы применить это к WordPress, допустим, вы хотите заблокировать:

Чтобы применить это к WordPress, допустим, вы хотите заблокировать:

- Всю папку wp-admin

- WP-логин.php

Вы можете использовать следующие команды:

User-agent: * Запретить: /wp-admin/ Disallow: /wp-login.php

Как использовать robots.txt Разрешить все, чтобы предоставить роботам полный доступ к вашему сайту

Если в настоящее время у вас нет причин блокировать доступ сканеров к любой из ваших страниц, вы можете добавить следующую команду.

Агент пользователя: * Позволять: /

Или альтернативно:

User-agent: * Запретить:

Как использовать Robots.txt, чтобы разрешить доступ к определенному файлу в запрещенной папке

Хорошо, теперь предположим, что вы хотите заблокировать всю папку, но при этом разрешить доступ к определенному файлу внутри этой папки. Вот где 9Команда 0019 Разрешить пригодится. И это на самом деле очень применимо к WordPress. Фактически, виртуальный файл robots. txt WordPress прекрасно иллюстрирует этот пример:

txt WordPress прекрасно иллюстрирует этот пример:

User-agent: * Запретить: /wp-admin/ Разрешить: /wp-admin/admin-ajax.php

Этот фрагмент блокирует доступ ко всей папке /wp-admin/ , кроме файла /wp-admin/admin-ajax.php .

Как использовать robots.txt, чтобы запретить ботам сканировать результаты поиска WordPress

Одна из настроек WordPress, которую вы, возможно, захотите сделать, — запретить поисковым роботам сканировать ваши страницы результатов поиска. По умолчанию WordPress использует параметр запроса «?s=». Итак, чтобы заблокировать доступ, все, что вам нужно сделать, это добавить следующее правило:

User-agent: * Запретить: /?s= Disallow: /search/

Это также может быть эффективным способом предотвращения программных ошибок 404, если вы их получаете. Обязательно прочитайте наше подробное руководство о том, как ускорить поиск в WordPress.

Как создать разные правила для разных ботов в robots.

txt

txtДо сих пор все примеры касались одного правила за раз. Но что, если вы хотите применить разные правила к разным ботам? Вам просто нужно добавить каждый набор правил в объявление User-agent для каждого бота. Например, если вы хотите сделать одно правило, которое применяется к всем ботам , а другое правило, которое применяется к только к Bingbot , вы можете сделать это следующим образом:

User-agent: * Запретить: /wp-admin/ Агент пользователя: Bingbot Запретить: /

В этом примере всем ботам будет заблокирован доступ к /wp-admin/, но Bingbot будет заблокирован доступ ко всему вашему сайту.

Проверка файла robots.txt

Чтобы убедиться, что файл robots.txt настроен правильно и работает должным образом, его следует тщательно протестировать. Один неуместный символ может иметь катастрофические последствия для производительности сайта в поисковых системах, поэтому тестирование может помочь избежать потенциальных проблем.

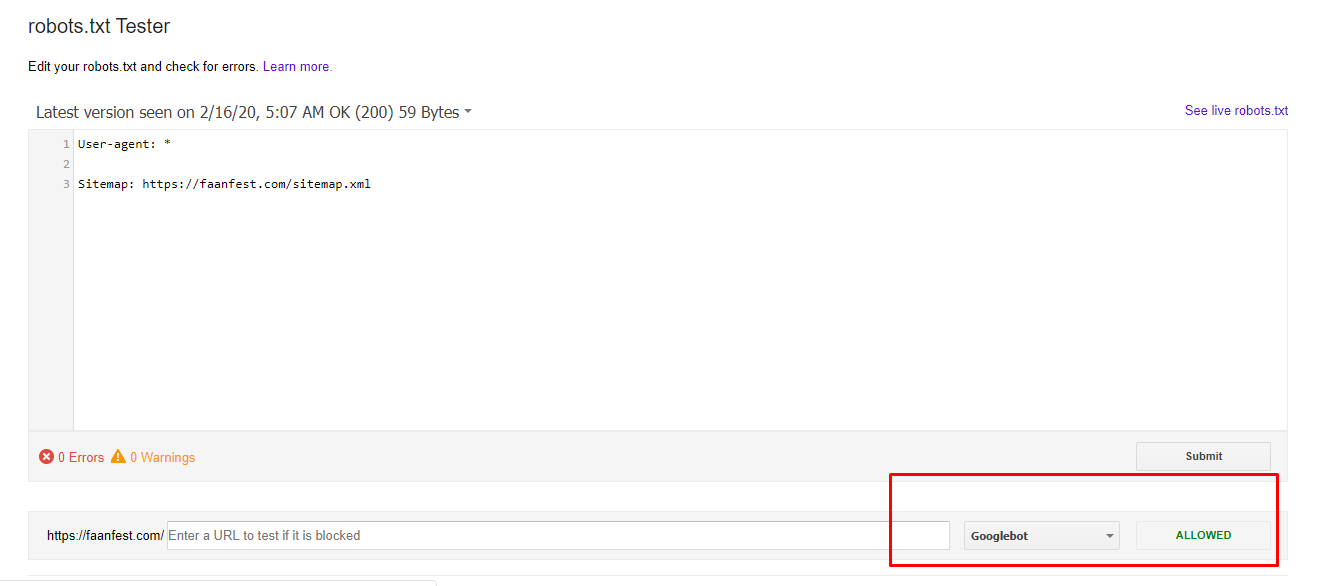

Тестер Google robots.txt

Инструмент Google robots.txt Tester (ранее входивший в состав Google Search Console) прост в использовании и выявляет потенциальные проблемы в вашем файле robots.txt.

Просто перейдите к инструменту и выберите свойство сайта, который вы хотите протестировать, затем прокрутите страницу вниз и введите любой URL-адрес в поле, затем нажмите красную кнопку TEST :

Testing robots.txt filesЕсли все доступно для сканирования, вы увидите зеленый ответ Разрешено .

Вы также можете выбрать, с какой версией Googlebot вы хотите провести тест: Googlebot, Googlebot-News, Googlebot-Image, Googlebot-Video, Googlebot-Mobile, Mediapartners-Google или Adsbot-Google.

Вы также можете проверить каждый отдельный URL-адрес, который вы заблокировали, чтобы убедиться, что они действительно заблокированы и/или запрещены .

Остерегайтесь спецификации UTF-8

Спецификация означает метку порядка следования байтов и в основном является невидимым символом, который иногда добавляется в файлы старыми текстовыми редакторами и т. п. Если это произойдет с вашим файлом robots.txt, Google может неправильно его прочитать. Вот почему важно проверить файл на наличие ошибок. Например, как показано ниже, наш файл имел невидимый символ, и Google жалуется на непонимание синтаксиса. По сути, это делает первую строку нашего файла robots.txt недействительной, что нехорошо! У Гленна Гейба есть отличная статья о том, как UTF-8 Bom может убить ваш SEO.

п. Если это произойдет с вашим файлом robots.txt, Google может неправильно его прочитать. Вот почему важно проверить файл на наличие ошибок. Например, как показано ниже, наш файл имел невидимый символ, и Google жалуется на непонимание синтаксиса. По сути, это делает первую строку нашего файла robots.txt недействительной, что нехорошо! У Гленна Гейба есть отличная статья о том, как UTF-8 Bom может убить ваш SEO.

Робот Google в основном базируется в США

Также важно не блокировать робота Googlebot из США, даже если вы ориентируетесь на локальный регион за пределами США. Иногда они выполняют локальное сканирование, но Googlebot в основном базируется в США .

Робот Google в основном базируется в США, но иногда мы также выполняем локальное сканирование. https://t.co/9KnmN4yXpe

— Google Search Central (@googlesearchc) 13 ноября 2017 г.

Что популярные сайты WordPress помещают в свой файл robots.

txt

txtЧтобы на самом деле представить некоторый контекст для перечисленных выше пунктов, вот как некоторые из самых популярных сайтов WordPress используют свои файлы robots.txt.

TechCrunch

TechCrunch Robots.txt FileПомимо ограничения доступа к ряду уникальных страниц, TechCrunch, в частности, запрещает поисковым роботам доступ к:

- /wp-admin/

- /wp-логин.php

Также установлены специальные ограничения на двух ботов:

- Swiftbot

- ИРЛбот

Если вам интересно, IRLbot — это поисковый робот из исследовательского проекта Техасского университета A&M. Странно!

Фонд Обамы

Фонд Обамы Файл Robots.txtФонд Обамы не вносил никаких специальных дополнений, ограничивая доступ исключительно к /wp-admin/.

Angry Birds

Angry Birds Файл Robots.txtAngry Birds имеет те же настройки по умолчанию, что и Фонд Обамы. Ничего особенного не добавляется.

Дрифт

Дрифт Robots. txt Файл

txt ФайлНаконец, Drift решает определить свои карты сайта в файле Robots.txt, но в остальном оставляет те же ограничения по умолчанию, что и The Obama Foundation и Angry Birds.

Правильно используйте Robots.txt

Завершая руководство по robots.txt, мы хотим еще раз напомнить вам, что использование команды Disallow в файле robots.txt не равнозначно использованию Тег noindex . Robots.txt блокирует сканирование, но не обязательно индексирование. Вы можете использовать его, чтобы добавить определенные правила, определяющие взаимодействие поисковых систем и других ботов с вашим сайтом, но он не будет явно контролировать, индексируется ли ваш контент или нет.

Большинству случайных пользователей WordPress нет необходимости в срочном изменении стандартного виртуального файла robots.txt. Но если у вас возникли проблемы с определенным ботом или вы хотите изменить способ взаимодействия поисковых систем с определенным плагином или темой, которую вы используете, вы можете добавить свои собственные правила.

Мы надеемся, что вам понравилось это руководство, и обязательно оставьте комментарий, если у вас есть дополнительные вопросы об использовании вашего файла WordPress robots.txt.

WP Robots Txt — плагин WordPress

- Детали

- отзывов

- Монтаж

- Разработка

Опора

WordPress по умолчанию включает простой файл robots.txt, который динамически генерируется в приложении WP. Отлично! но, возможно, вы хотите изменить содержание.

Войдите в WP Robots Txt, плагин, который добавляет дополнительное поле на страницу администратора «Чтение», где вы можете сделать именно это.

Просто зайдите на https://your-site.com/wp-admin/options-reading.php, и вы сможете контролировать содержимое своего https://your-site.com/robots.txt

Список изменений

WP Robots Txt изначально был разработан chrisguitarguy. Плагин был принят и обновлен Джорджем Паттихисом, который продолжит разработку.

- Просмотр опции администратора

- Скачать плагин

- Разархивировать

- Загрузите распакованную папку в каталог

wp-content/plugins - Активируйте и наслаждайтесь!

Или вы можете просто установить его через установщик плагинов в админке.

Я полностью испортил свой файл robots.txt. Как я могу восстановить версию по умолчанию?

Удалите все содержимое из поля Robots.txt Content и сохраните параметры конфиденциальности.

Могу ли я этим случайно заблокировать всех поисковых ботов?

Да. Будь осторожен! Тем не менее,

файла robots.txtявляются рекомендациями. На самом деле они не блокируют ботов так сильно, как предлагают , что боты не сканируют части сайта. Вот почему параметры на странице настроек конфиденциальности говорят: «Попросить поисковые системы не индексировать этот сайт».Где я могу узнать больше о файлах robots.txt?

Вот общее руководство от Google, а вот SEO-документация WordPress.

Изменить настройки плагина

Мне понадобилось около недели, чтобы заметить это. Посещаемость сайта упала на 600%. Спасибо!

Хороший код, приятный интерфейс. В нем нет встроенной функции динамической замены (например, {siteurl}/sitemap_index.xml), но его можно добавить с помощью простого фильтра.

Спасибо за отличный плагин!

В нем нет встроенной функции динамической замены (например, {siteurl}/sitemap_index.xml), но его можно добавить с помощью простого фильтра.

Спасибо за отличный плагин!

Простой плагин, который помог мне исправить ошибку js. проблема в поиске гугл

Я использую этот плагин для решения проблемы с файлом robots.txt. Это очень полезный плагин. http://www.gemstonesprices.in Аметистовый камень

Прочитать все 17 отзывов

«WP Robots Txt» — это программное обеспечение с открытым исходным кодом. Следующие люди внесли свой вклад в этот плагин.

Авторы

- Крисгитаргай

- Джордж Паттихис

1.2

- Обновить содержимое robots.txt по умолчанию

- Включить ссылку на карту сайта

- Код устранения предупреждений/ошибок

- Соответствие стандартам кодирования WP

- Обеспечьте совместимость с WP v6

1.1

- Поле настроек перенесено «официально» на страницу чтения

- Очистка общего кода

1.

txt и .htaccess (при его наличии).

txt и .htaccess (при его наличии). txt is set to block WordPress files and folders that don’t need to be accessed by search engines. Of course, if you disagree with the defaults, you can easily change them.

txt is set to block WordPress files and folders that don’t need to be accessed by search engines. Of course, if you disagree with the defaults, you can easily change them. txt form field. Thanks to TrustWave for identifying this issue.

txt form field. Thanks to TrustWave for identifying this issue. txt. Таким образом, мы не знали бы, что вы не хотите, чтобы эти страницы действительно индексировались.

txt. Таким образом, мы не знали бы, что вы не хотите, чтобы эти страницы действительно индексировались. Пользовательские агенты — это то, что боты используют для идентификации себя. С ними можно было бы, например, создать правило, применимое к Bing, но не к Google.

Пользовательские агенты — это то, что боты используют для идентификации себя. С ними можно было бы, например, создать правило, применимое к Bing, но не к Google.