«Я не могу войти в YouTube. Мне пишет YouTube недоступен в вашем аккаунте.Что делать? » — Яндекс Кью

Популярное

Сообщества

ИнтернетЮтубАвторизация

Даша Григорьева

·

32,4 K

ОтветитьУточнитьV. K.

4

6 мар 2021

Заблокированы на youtube все аккаунты google!

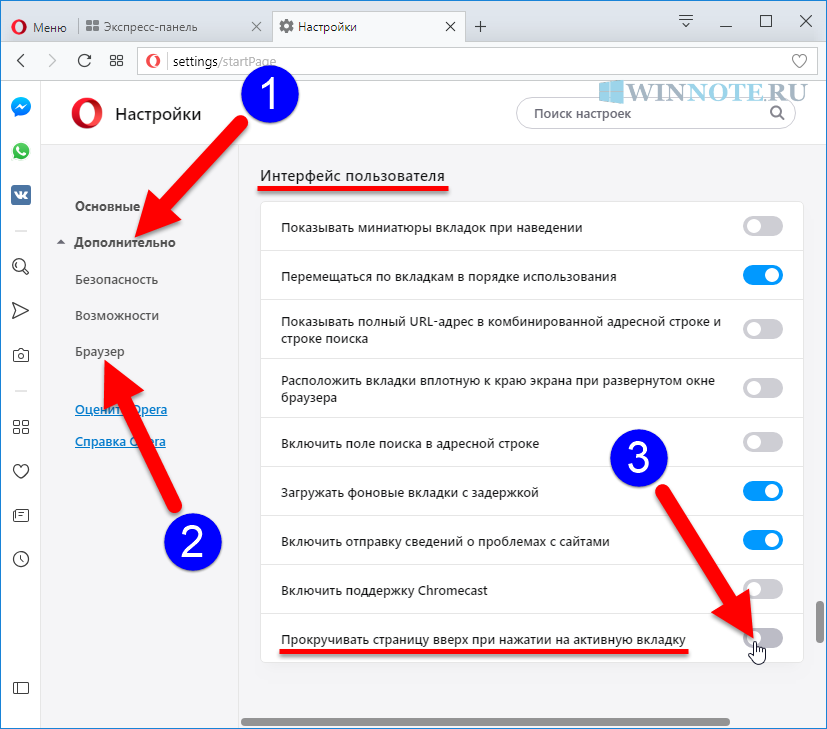

У вас заблокировали канал youtube, горе, конечно, помимо контента исчезли все ссылки и подписки, самые важные из которых нужно было дублировать в закладках броузера. Дополнительно заблокировались все аккаунты google на доступ к youtube. Даже создав новый аккаунт вы с удивлением узнаете что и он заблокирован. Поискав в интернете решение данной проблемы, стал прощатся с полным доступом к youtube. Осенило неожиданно, в настройках броузера выделил и удалил куки google и вот оно, счастье, все аккаунты заработали, кроме, конечно, забаненного.

Осенило неожиданно, в настройках броузера выделил и удалил куки google и вот оно, счастье, все аккаунты заработали, кроме, конечно, забаненного.

Комментировать ответ…Комментировать…

Первый

Елена Левина

1

25 сент 2020

Создай аккаунт пользователя и переключись на него и сможешь войти в ютуб дело в том когда регестрируешся на ютуб кидс твой аккаунт привязывается к сайту.

10,1 K

Комментировать ответ…Комментировать…

даниил Г.

111

9 мая 2020

Причина одна: Вас заблокировали из — за :

на вас подали жалобу

или ошибка бота

Совет: смените аккаунт в Гугле, однако это поможет необязательно.

16,3 K

Владислав. В.

В.

24 июня 2020

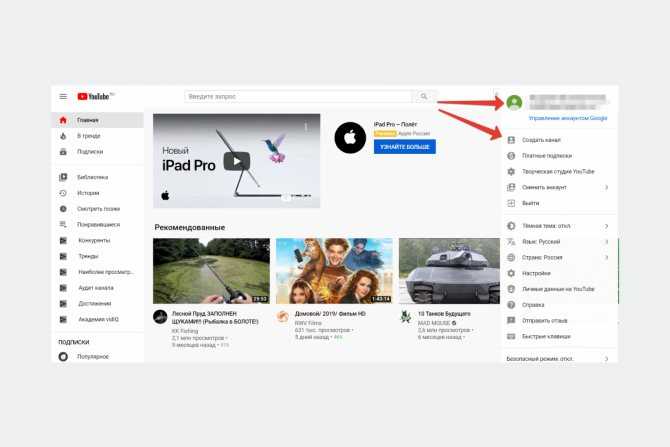

у меня было точно так же Как исправить: 1: зайдите в гугл 2: зайдите в аккаунт( В ВИДЕ КРУЖКА С КОКОЙ НИБУТЬ… Читать дальше

Комментировать ответ…Комментировать…

Лучший

Пахом О.

1

9 мая 2020

Скорее всего, ваш аккаунт был заблокирован. На это были две причины:

1. Вы оскорбили другого пользователя и он подал на вас жалобу.

2. Алгоритмы YouTube совершили ошибку.

Как я знаю, с этим ничего нельзя поделать. Советую пользоваться другим аккаунтом Google для входа в YouTube.

16,0 K

артем

12 августа 2020

а как мне зайти в другой аккаунт ютуба если я кроме надписи (В твоем аккаунте YouTube недоступен. Если у тебя есть… Читать дальше

Комментировать ответ…Комментировать…

Вы знаете ответ на этот вопрос?

Поделитесь своим опытом и знаниями

Войти и ответить на вопрос

Дорабатываем Яндекс.

Станцию для просмотра YouTube / Хабр

Станцию для просмотра YouTube / ХабрНа Яндекс.Станции неудобно смотреть YouTube. Нет рекомендаций, подписок и даже поиск нормально не работает. Поэтому я написал телеграмм бота для отправки на неё любого видео.

Под катом история, как я это сделал несмотря на то, что официального открытого API нет.

С чего все началось?

Я инженер. Постоянно изучаю, как работают разные технологии и вещи вокруг, а также делаю много интересных проектов сам. Когда друзья подарили мне Яндекс.Станцию, я зареверсил протокол активации и развил идею передачи данных, ориентированной на wow-эффект.

У меня глупый (не smart) телевизор, а в качестве основной медиа приставки я использую Станцию. Все отлично, да только YouTube смотреть на ней совсем неудобно. Нельзя войти в аккаунт Ютуба, а значит, никаких рекомендаций и подписок. Кроме того, поиск по видео в Станции, как я понял, осуществляется через Яндекс.

Я почти смирился с тем, что YouTube на Станции смотреть нельзя, но все изменилось пару недель назад.

Что же произошло?

В субботу утром я решил посмотреть последний сезон «Кремниевой долины». Зашел на «Кинопоиск» и увидел следующее:

После клика по кнопке видео улетело на Яндекс.Станцию и воспроизвелось дальше там. Прямо как ChromeCast или AirPlay. Восторг! Но я обрадовался не самому функционалу, а потенциальной возможности отправить любое видео на станцию.

Я и думать забыл про сериал — на все выходные ушел в реверс инжиниринг и разработку.

Давайте разбираться.

Открываем «Кинопоиск» или «Яндекс.Видео» в Хроме — там отличные инструменты для web разработки. Находим нужную кнопку, кликаем правой клавишей мыши, выбираем «Исследовать элемент».

Находим нужную кнопку, кликаем правой клавишей мыши, выбираем «Исследовать элемент».

Можно много, что там поизучать, но нас интересует, какой запрос выполняется при клике по этой кнопке. Переходим во вкладку «Network» инструментов разработчика и смотрим запросы.

Да, отлетает много статистики, но сразу видно 2 интересных запроса. Это devices_online_stats и station.

Получаем список устройств

devices_online_stats — запрос активных устройств пользователя. Простой GET запрос. Если вы авторизованы в Яндексе, то можете узнать о своих устройствах просто открыв в браузере ссылку:

quasar.yandex.ru/devices_online_stats

Что в ответе:

{

"items":[

{

"icon":"https://avatars.mds.yandex.net/get-yandex-station/1540981/yandexstationicon/orig",

"id":"************",

"name":"Яндекс Станция",

"online":true,

"platform":"yandexstation",

"screen_capable":true,

"screen_present":true

}

],

"status":"ok"

}

Интересно и достаточно интуитивно. ID Станции в примере я заменил на звездочки на всякий случай, но именно он понадобится нам в дальнейшем.

ID Станции в примере я заменил на звездочки на всякий случай, но именно он понадобится нам в дальнейшем.

Воспроизводим видео

Запрос на yandex.ru/video/station отправляется методом POST. Повторим его из консоли, получив команду следующим образом:

Запускаем в терминале и получаем ответ:

{

"status": "play",

"msg": "success",

"code": 1

}Через пару секунд видео запускается на станции. Успех!

Собираем

Я удалил все «лишние» поля из запроса так, чтобы он остался рабочим. Для отправки видео на Станцию в тело и заголовки POST запроса нужно положить всего 4 параметра:

- SessionID — авторизация в Яндексе

- x-csrf-token

- provider_item_id — ссылка на видео (или идентификатор для некоторых сервисов)

- device — Идентификатор устройства, который мы получили ранее

Что за x-csrf-token? Не будем сейчас углубляться.

К этому моменту я уже стал оборачивать все в скрипт на Python. В итоге функция для отправки видео на станцию выглядит примерно так:

def sendToScreen(video_url):

# Auth and getting Session_id

auth_data = {

'login': config.login,

'passwd': config.password

}

s = requests.Session()

s.get("https://passport.yandex.ru/")

s.post("https://passport.yandex.ru/passport?mode=auth&retpath=https://yandex.ru", data=auth_data)

Session_id = s.cookies["Session_id"]

# Getting x-csrf-token

token = s.get('https://frontend.vh.yandex.ru/csrf_token').text

# Getting devices info TODO: device selection here

devices_online_stats = s.get("https://quasar.yandex.ru/devices_online_stats").text

devices = json.loads(devices_online_stats)["items"]

# Preparing request

headers = {

"x-csrf-token": token,

}

data = {

"msg": {

"provider_item_id": video_url

},

"device": devices[0]["id"]

}

if "https://www.

youtube" in video_url:

data["msg"]["player_id"] = "youtube"

# Sending command with video to device

res = s.post("https://yandex.ru/video/station", data=json.dumps(data), headers=headers)

return res.textВы могли заметить, что я добавляю поле player_id если прислана ссылка с Ютуба. Дело в том, что на Станции есть несколько плееров с кодами youtube, vh и ott. По умолчанию используется vh, но тогда ломается превью и название ролика. Кроме того, его состояние не сбрасывается при смене ролика, что часто вызывает ошибки (Возможно, не все поля в запросе были «лишними»). Плеер ott, как я понял, используется для стриминговых сервисов, а это значит, что в перспективе можно смотреть IPTV через станцию.

Что в итоге?

Я не стал делать его публичным, чтобы не собирать логины и пароли. Но вы можете развернуть такого же для себя или доработать для OAuth авторизации или отправки видео с других сайтов. Все исходники доступны на GitHub.

Я хотел сделать расширение для браузера, чтобы работало совсем как AirPlay с любыми видео, но понял, что удобнее отправлять из приложения с телефона. А для такого сценария лучше подходит бот. Вот видео его работы:

Заключение

Когда инженеру нехватает функционала, он доделывает его сам. Мы теперь действительно регулярно пользуемся этим ботом — очень удобно 🙂

Разработчики Яндекса, пожалуйста не ломайте этот запрос. Это не уязвимость. Работает только с аутентификацией. А если есть возможность — сделайте API устройств публичным — столько всего можно еще сделать!

Спасибо, что читаете мои статьи! Надеюсь, вам было интересно.

Успехов!

Яндекс.Музыка на YouTube — перенос плейлистов и избранного с помощью Soundiiz

Лучшее решение для управления вашей музыкальной онлайн-коллекцией!

- Поддерживается 44 музыкальных сервиса

- Перенесите свои плейлисты и избранное

- Нет необходимости устанавливать какое-либо приложение

Как перенести плейлисты с Яндекс Музыки (Яндекс.

Музыка) на YouTube?

Музыка) на YouTube?Это краткое руководство поможет вам переместить один или несколько плейлистов из Яндекс.Музыки (Яндекс.Музыка) на YouTube

Бесплатно (по одному) Премиум (несколько сразу) Плейлисты Передача

- Откройте Soundiiz и выберите инструмент передачи

- Подключите аккаунты Яндекс.Музыки (Яндекс.Музыка) и YouTube

- Выберите все списки воспроизведения, которые вы хотите скопировать на YouTube

- Подтвердите свой выбор и начните передачу!

Переход с Яндекс.Музыки (Яндекс.Музыка) на YouTube!

Как перенести альбомы с Яндекс.Музыки (Яндекс.Музыка) на YouTube?

Мы не можем перенести такой элемент на YouTube. Эта платформа не может поддерживать этот тип данных, или мы не можем получить эти данные с исходной платформы. Узнать больше

Как перенести исполнителей с Яндекс Музыки (Яндекс.

Музыка) на YouTube?

Музыка) на YouTube?У вас есть любимые исполнители на Яндекс.Музыке (Яндекс.Музыка) и вы хотите перенести их на YouTube? Следующие шаги могут вам помочь:

Бесплатно (по одному) Премиум Художники Передача

- Откройте Soundiiz и выберите инструмент передачи

- Подключите аккаунты Яндекс.Музыки (Яндекс.Музыка) и YouTube

- Выберите всех исполнителей, за которыми вы хотите следить на YouTube

- Подтвердите свой выбор и начните передачу!

Переход с Яндекс.Музыки (Яндекс.Музыка) на YouTube!

Как перенести любимые треки с Яндекс.Музыки (Яндекс.Музыка) на YouTube?

У вас есть любимые треки на Яндекс.Музыке (Яндекс.Музыка) и вы хотите перенести их на YouTube? Следующие шаги могут вам помочь:

Бесплатно (по одному) Премиум Треки Передача

- Откройте Soundiiz и выберите инструмент передачи

- Подключите аккаунты Яндекс.

Музыки (Яндекс.Музыка) и YouTube

Музыки (Яндекс.Музыка) и YouTube - Выберите все песни, которые вы хотите добавить на YouTube

- Подтвердите свой выбор и начните передачу!

Переход с Яндекс.Музыки (Яндекс.Музыка) на YouTube!

Что такое Яндекс Музыка (Яндекс.Музыка)?

Яндекс.Музыка, основанная на крупнейшей поисковой системе в России, предоставляет исключительно легальную, платную и бесплатную потоковую передачу музыки пользователям в России, Украине и Казахстане.

Что такое YouTube?

YouTube — это веб-сайт видеохостинга, на котором пользователи могут загружать, оценивать, просматривать, обсуждать и обмениваться видео.

Что такое Soundiiz?

Soundiiz — наиболее полный онлайн-инструмент для управления вашей музыкальной библиотекой между несколькими сервисами. Он предлагает простой способ импорта и экспорта плейлистов и избранных треков, исполнителей и альбомов.

Перевод прямых трансляций через Яндекс Браузер: Принципы и отличия от озвучивания видео по запросу | Сергей Дуканов | Яндекс

Мы уже рассказывали о том, как работает автоматический перевод и озвучивание видео в Яндекс Браузере. Пользователи просмотрели 81 миллион видеороликов с озвученным переводом за первые десять месяцев после релиза. Механизм работает по запросу: как только пользователь нажимает на кнопку, нейросеть получает всю звуковую дорожку, а дублированный перевод на язык пользователя появляется через несколько минут.

Но этот способ не подходит для прямых трансляций, где нужно переводить практически в реальном времени. Именно поэтому мы просто запустили отдельный, более сложный механизм трансляции прямых трансляций в Яндекс.Браузере. Анонсы устройств, спортивные соревнования, вдохновляющие космические запуски — все это и многое другое теперь можно смотреть на целевом языке в прямом эфире. Производственная версия в настоящее время поддерживает перевод только на русский язык, а английский язык появится этой осенью. Также на данный момент озвучка доступна для ограниченного набора потоков YouTube: вы можете найти полный список в конце этой статьи. В будущем мы, конечно же, откроем эту функцию для всех прямых трансляций YouTube. Нам пришлось перестраивать всю архитектуру с нуля, чтобы адаптировать механизм трансляции для потоков.

Также на данный момент озвучка доступна для ограниченного набора потоков YouTube: вы можете найти полный список в конце этой статьи. В будущем мы, конечно же, откроем эту функцию для всех прямых трансляций YouTube. Нам пришлось перестраивать всю архитектуру с нуля, чтобы адаптировать механизм трансляции для потоков.

С инженерной точки зрения перевод и дублирование прямых трансляций — сложная задача. Здесь сталкиваются два противоречивых требования. С одной стороны, вам нужно скормить модели как можно больше текста за раз, чтобы нейронная сеть понимала контекст каждой фразы. С другой стороны, необходимо минимизировать задержку; иначе «прямой эфир» перестанет быть таковым. Поэтому мы должны начать переводить как можно скорее: не в режиме настоящего синхронного перевода, но очень близко к нему.

Мы разработали новую услугу на основе существующих алгоритмов для быстрого и качественного перевода и дублирования прямых трансляций. Новая архитектура позволила уменьшить задержку без потери качества.

Вкратце принцип работы прямой трансляции сводится к пяти моделям машинного обучения. Одна нейросеть отвечает за распознавание речи звуковой дорожки и преобразует ее в текст. Второй движок определяет пол говорящих. Третий разбивает текст на предложения, расставляя знаки препинания и определяя, какие части текста содержат законченные мысли. Четвертая нейросеть переводит полученные куски. Наконец, пятая модель синтезирует речь на целевом языке.

На бумаге все выглядит просто, но если копнуть глубже, можно обнаружить множество подводных камней. Давайте рассмотрим этот процесс более подробно.

На начальном этапе нужно точно понимать, о чем идет речь в эфире, и определить, когда произносятся слова. Мы не просто переводим речь, но и накладываем результат обратно на видео в нужные моменты.

Глубокое обучение — идеальное решение проблемы ASR (автоматического распознавания речи). Архитектура нейронной сети должна допускать сценарий использования прямой трансляции, когда необходимо обрабатывать звук по мере его поступления. Такое ограничение может повлиять на точность предсказания, но мы можем применить модель с некоторой задержкой (несколько секунд), что придает модели некоторый контекст.

Такое ограничение может повлиять на точность предсказания, но мы можем применить модель с некоторой задержкой (несколько секунд), что придает модели некоторый контекст.

Видео могут содержать посторонние шумы и музыку. Кроме того, люди могут иметь разную дикцию или говорить с разным акцентом и скоростью. Говорящих может быть много, и они могут кричать, а не говорить на умеренной громкости. И, конечно же, нужно поддерживать богатый словарный запас, ведь возможных тем видео очень много. Таким образом, сбор данных, необходимых для обучения, играет ключевую роль.

На вход алгоритм получает последовательность звуковых фрагментов, берет N из них с конца, извлекает акустические признаки (спектрограмму MEL) и подает результат на вход нейронной сети. Он, в свою очередь, выдает набор последовательностей слов (так называемых гипотез), из которых языковая модель — текстовая часть нейронной сети — выбирает наиболее правдоподобную гипотезу. Когда поступает новый фрагмент аудио, процесс повторяется.

Полученную последовательность слов необходимо перевести. Качество пострадает, если вы будете переводить слово за словом или фразу за фразой. Если вы дождетесь длинной паузы, означающей конец предложения, произойдет значительная задержка. Поэтому необходимо группировать слова в предложения, чтобы избежать потери смысла или слишком длинных предложений. Одним из способов решения этих проблем является использование модели восстановления пунктуации.

С появлением трансформеров нейронные сети стали намного лучше понимать смысл текста, отношения между словами и шаблоны языковых конструкций. Вам нужен только большой объем данных. Для восстановления пунктуации достаточно взять корпус текстов, подать текст без знаков препинания на вход нейронной сети и обучить сеть исправлять его обратно.

Текст поступает на вход нейросети в токенизированном виде; обычно это токены BPE. Такое разбиение не слишком мало, чтобы предотвратить удлинение последовательности, но и не слишком велико, чтобы избежать проблемы отсутствия словарного запаса, когда токен отсутствует в глоссарии. На выходе модели каждое слово имеет последующую метку, которая отмечает, какой знак препинания следует поставить.

На выходе модели каждое слово имеет последующую метку, которая отмечает, какой знак препинания следует поставить.

Необходимо установить некоторый ограниченный контекст, чтобы обеспечить правильную работу в условиях прямой трансляции. Размер этого контекста должен найти компромисс между качеством и задержкой. Если мы не уверены, нужно ли разбивать предложения в данном конкретном месте, мы можем немного подождать, пока не появятся новые слова. Тогда мы либо лучше определим разбиение, либо превысим контекстный предел и будем вынуждены разбиваться там, где мы лишь немного конечно.

Для корректного перевода и качественного озвучивания необходимо определить пол говорящего. Если вы используете классификатор пола на уровне предложения, в сценарии прямой трансляции не будет различий по сравнению со сценарием по запросу. Хранение истории голосовых линий каждого говорящего помогает нам более точно классифицировать половую принадлежность. Это снижает количество ошибок в полтора раза. Мы не только можем определить пол человека всего по одной фразе, но и рассматриваем результаты гендерной классификации по фразам, произнесенным ранее. Для этого нам нужно на лету определить, кому принадлежит линия, тем самым уточнив пол говорящего.

Мы не только можем определить пол человека всего по одной фразе, но и рассматриваем результаты гендерной классификации по фразам, произнесенным ранее. Для этого нам нужно на лету определить, кому принадлежит линия, тем самым уточнив пол говорящего.

С точки зрения машинного перевода ничего не изменилось по сравнению с переводом готовых видео, поэтому сейчас не будем в это углубляться. В прошлом мы рассмотрели внутреннюю работу перевода.

Базовая технология синтеза в Алисе, умном помощнике Яндекса, аналогична той, которую мы используем в видеопереводе. Разница в том, как осуществляется применение (вывод) этих нейронных сетей. Говорящий в ролике может очень быстро произнести реплику, либо перевод предложения может получиться в два раза длиннее оригинала. В этих случаях вам придется сжимать синтезированный звук, чтобы не отставать от времени. Этого можно добиться двумя способами: на уровне звуковой волны, например, с помощью PSOLA (Pitch Synchronous Overlap and Add) или внутри нейронной сети. Второй метод обеспечивает более естественное звучание речи, но требует возможности редактирования скрытых параметров.

Второй метод обеспечивает более естественное звучание речи, но требует возможности редактирования скрытых параметров.

Важно не только доводить длительности синтезируемых фраз до нужной длины, но и разлагать их в нужные моменты. Не всегда будет идеально: придется либо ускорять запись, либо сдвигать тайминги — за это отвечает алгоритм стекирования. В прямом эфире нельзя изменить прошлое, поэтому может возникнуть ситуация, когда нужно озвучить фразу в два раза быстрее, чем она произносится в исходном видео. Для справки: ускорение более чем на 30% существенно влияет на человеческое восприятие.

Решение следующее: резервируем время заранее. Мы не торопимся складывать голосовые линии и можем дождаться новых, чтобы учесть их продолжительность. Мы также можем позволить накапливаться небольшому временному сдвигу, поскольку рано или поздно в видео будет несколько секунд тишины, и сдвиг будет сброшен до нуля.

Полученная звуковая дорожка разрезается на фрагменты и оборачивается аудиопотоком, который будет микшироваться локально в самом Браузер-клиенте.

При просмотре трансляции Браузер опрашивает стриминговый сервис (например, YouTube) на наличие новых фрагментов видео и аудио; если они есть, он загружает и воспроизводит их последовательно.

Когда пользователь нажимает на кнопку живого перевода, Яндекс.Браузер запрашивает ссылку на поток с переведенным звуком из своего бэкенда. Браузер накладывает этот трек поверх основного, соблюдая тайминги.

В отличие от готовых видео, прямая трансляция обрабатывается машинным переводом каждый момент своего существования. Stream Downloader считывает аудиопоток и отправляет его в конвейер обработки ML, компоненты которого мы разобрали выше.

Существует несколько способов организации взаимодействия между компонентами. Мы остановились на варианте с очередями сообщений, где каждый компонент оформлен как отдельный сервис:

- Запускать все модели на одной машине проблематично: они могут просто не помещаться в памяти или требовать очень специфической аппаратной конфигурации.

- Требуется для балансировки нагрузки и возможности горизонтального масштабирования. Например, сервисы машинного перевода и синтеза голоса имеют разную пропускную способность, поэтому количество фраз может отличаться.

- Службы иногда аварийно завершают работу (недостаточно памяти графического процессора, утечка памяти или отключение питания в центре обработки данных), а очереди предоставляют механизм повторных попыток.

Поток не привязан к одному экземпляру, но для обработки может потребоваться некоторый контекст (фон). Например, синтезатору необходимо хранить записи, которые еще не были помещены на окончательную звуковую дорожку. Следовательно, необходим глобальный репозиторий контекста для всех потоков. На схеме он обозначен как Global Context — по сути, это просто хранилище ключ-значение в памяти.

Наконец, полученный аудиопоток должен быть доставлен пользователю. Здесь за дело берется Stream Sender: он оборачивает аудиофрагменты в потоковый протокол, а клиент читает этот поток по ссылке.

В настоящее время мы предоставляем прямую трансляцию со средней задержкой 30–50 секунд. Иногда мы вылетаем из этого диапазона, но ненамного: стандартное отклонение около 5 секунд.

Основная трудность при переводе прямых трансляций заключается в обеспечении того, чтобы задержка не колебалась слишком сильно. Простой пример: вы открываете прямую трансляцию и через 15 секунд начинаете получать трансляцию. Если вы продолжите смотреть, рано или поздно одной из моделей понадобится больше контекста — например, если говорящий произносит длинное предложение без пауз, нейронный движок попытается получить его целиком. Тогда задержка увеличится, возможно, еще на десять секунд. Естественно, предпочтительна небольшая задержка в начале, чтобы этого не произошло.

Наша глобальная цель — сократить задержку примерно до 15 секунд. Это немного больше, чем в настоящем синхронном переводе, но достаточно для прямых трансляций, где ведущие взаимодействуют с аудиторией, например, на Twitch.

Музыки (Яндекс.Музыка) и YouTube

Музыки (Яндекс.Музыка) и YouTube