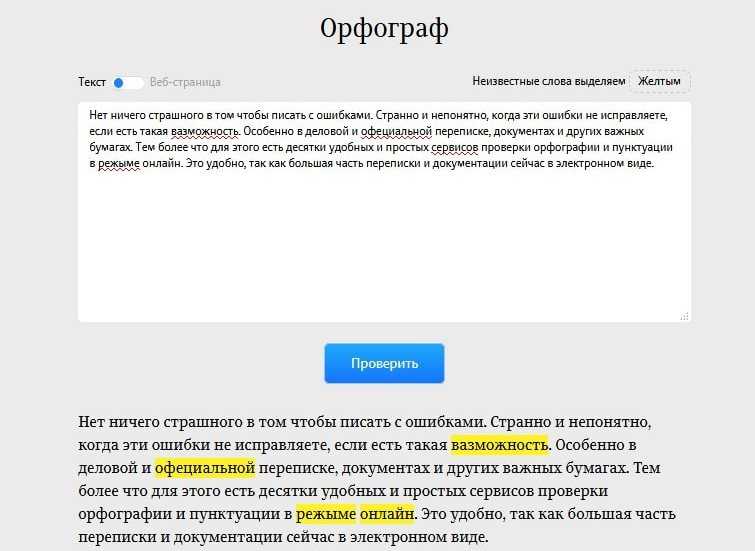

Проверка орфографии, грамматики и стилистики онлайн

Наши партнеры и клиенты:

- BMW Group

- Amazon

- RingCentral

- European Union

- Spiegel Magazine

- Deutsche Presse-Agentur (dpa)

- Heise

- Bertelsmann Stiftung

- Schweizer Radio und Fernsehen (SRF)

- JetBrains

- IP Australia

- Wirtschaftsuniversität Wien

Создайте аккаунт бесплатно

Зарегистрироваться

- Chrome

- Firefox

- Edge

Наше расширение для браузера работает на всех сайтах

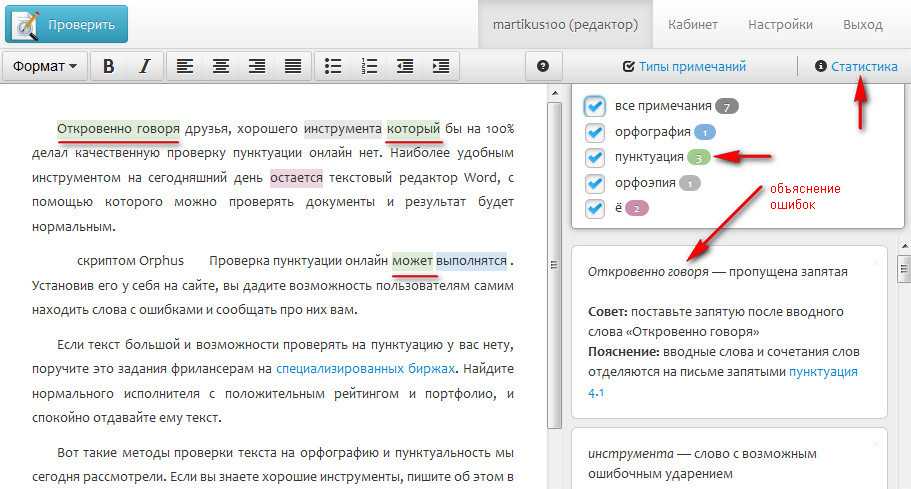

Получайте советы о том, как улучшить свой текст (включая советы по пунктуации и т. д.), когда печатаете электронное письмо, делаете запись в блоге или публикуете твит. На каком бы языке вы не писали, LanguageTool определит его автоматически и предоставит вам подсказки по правописанию. В целях обеспечения конфиденциальности информации расширение LanguageTool не хранит ваши тексты.

д.), когда печатаете электронное письмо, делаете запись в блоге или публикуете твит. На каком бы языке вы не писали, LanguageTool определит его автоматически и предоставит вам подсказки по правописанию. В целях обеспечения конфиденциальности информации расширение LanguageTool не хранит ваши тексты.

Добавьте в Firefox это бесплатно!

Более 1250 отзывов о расширении Firefox

Самое популярное расширение для корректуры текстов для Firefox с более чем 1 миллионом пользователей по всему миру

Meet LanguageTool For macOS

Experience LanguageTool’s advanced Grammar-, Spelling and Style suggestions right in your all your favorite writing apps.

Supported Apps

Download LanguageTool for Desktop Read more

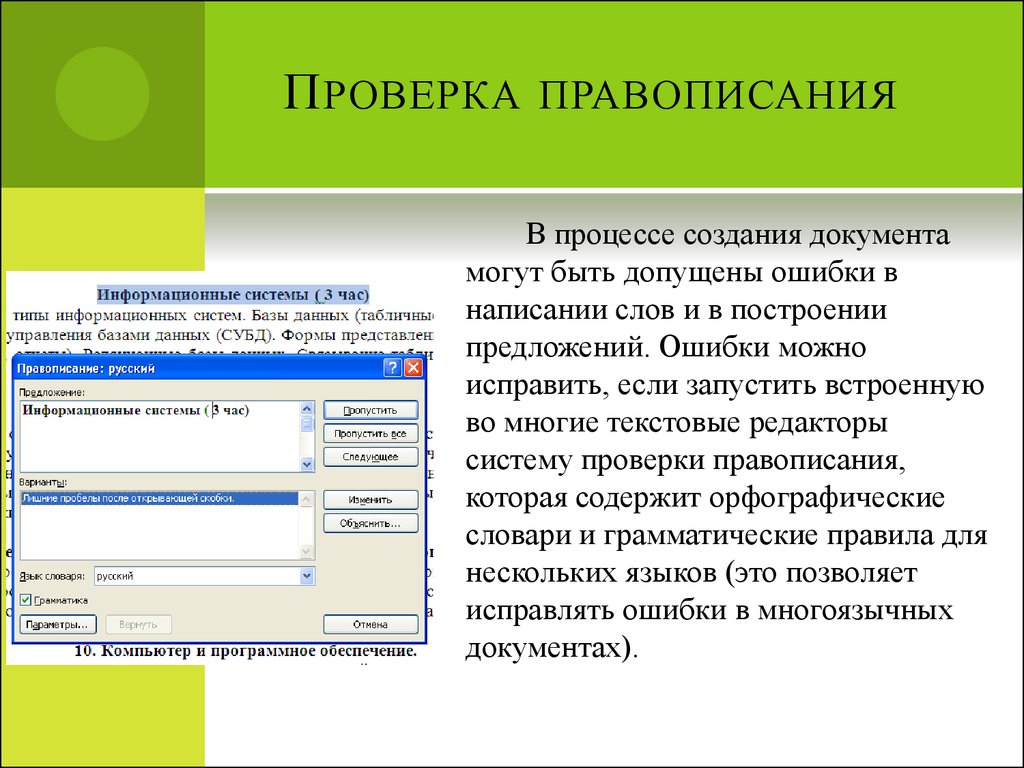

Интегрируется с вашей любимой офисной программой

Получайте больше от работы над документами и пишите профессиональные тексты без ошибок.

Дополнение для Google Docs

После установки обязательно настройте свой аккаунт LanguageTool:

«Надстройки» → «LanguageTool» → «Параметры»

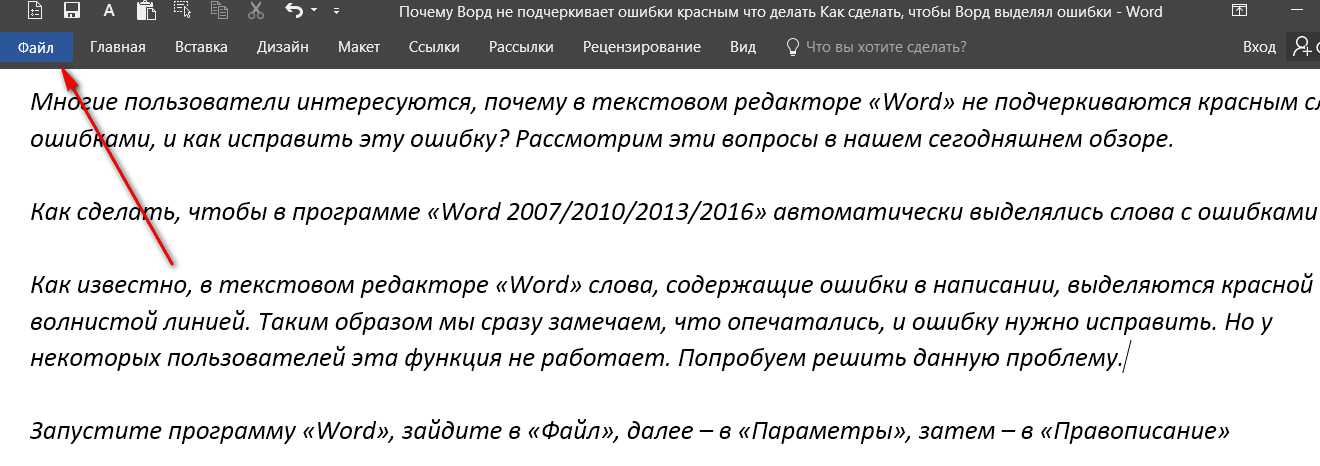

УстановитьДополнение для Microsoft Word

Работает с Windows, Mac и веб-версией Word. Требуется версия Word 2016 и выше, или Office 365.

Установить

Проверка текстов для LibreOffice и OpenOffice

* Для проверки грамматики в OpenOffice требуется Java 8. В настоящее время недоступно для версии Premium. Возникли проблемы с его установкой? Обратитесь за справкой сюда: Troubleshooting

Откройте в себе профессионального автора с LanguageTool Premium

Не ограничивайтесь проверкой грамматики и орфографии — удивляйте всех понятным, четким и стилистически безупречным текстом.

Узнать больше

Заказать исправление ошибок в тексте — ФРИЛАНС.ру

Фрилансеры

исправление ошибок в текстеСео SEO копирайтинг, тексты

Посты и продающие тексты для социальных сетей

Переводы, редактирование, корректура

Тексты для сайтов, ВК, соцсетей

Описание вкусов Флайчипсов

Текст для главной страницы, который дочитают до конца

О b2b-продажах для блога маркетолога

ПОЧЕМУ ВАМ СТОИТ ОБРАТИТЬСЯ ИМЕННО КО МНЕ

УСЛУГИ КОПИРАЙТЕРА

ПОЧЕМУ ВАМ СТОИТ ОБРАТИТЬСЯ ИМЕННО КО МНЕ

Описание тура лёгким слогом

Статья о технологии. Экспертность + понятный язык

SEO

11 лет в копирайтинге

SEO

Коммерческое предложение на английском языке

Рерайт

Продающий текст

Преподавание в НИУ ВШЭ

Дистанционные курсы

Преподавание в Московской школе кино

Прототипы, тексты для лендингов, презентации

Переводы, веб-контент, лонгриды

SEO\LSI-тексты, внутренняя оптимизация

Продающие карточки

Рекламная статья

Федор Конюхов: биография, творчество, карьера, личная жизнь

сео тексты

Фокус-группа

Интервью

Текст со скринами

Логотип Solnceya

Картина — акрил, холст

Рекламные креативы для мебельного производства

Размещение на Авито объявления

Исполнительные схемы

Исполнительные схемы

Редактирование и корректировка текстов — Freelance.

Ru

RuКаждый автор, который пишет текст, обязательно перечитывает его на наличие ошибок. Но даже это не уберегает от мелких опечаток, стилистических ошибок и других нелепостей. Лучше всего вычитывать текст спустя время, а еще лучше — нанять для этого другого человека, который сможет оценить материал свежим взглядом.

У фрилансеров, которых вы видите на этой странице каталога, вы можете заказать подготовку текста к публикации: исправить текст, доработать, поднять уникальность, исправить ошибки, добавить объем или наоборот, убрать воду.

В том числе и такие Редактирование/корректировка как исправление ошибок в тексте.

Набор текста, перевод видео-аудио в текст, корректировка

Предлагаю набор текста с различных носителей — цена 60р страница; транскрибация видео-аудио от 40р/минута; также помогу сделать корректировку текста на грамотность, исправление ошибок и т.п. Грамотно, внимательно, в срок.

Грамотно, внимательно, в срок.

40 Руб 3 Дня

Транскибатор

Меня зовут Любовь, я занимаюсь набором текста: перепечатываю с фото, сканов, рукописи, расшифровываю аудио и видео в текст. Переписываю лекции, конспекты от руки. Проверяю тексты на грамматические и пунктуационные ошибки. Могу взяться за написание и офор…

400 Руб 1 День

Проверка на ошибки, исправление.

•Обработаю ваш текст;

•исправлю ошибки;

•заменю слова,на более подходящие;

•разделю текст на абзацы;

•и т.п.

100 Руб 2 Дня

Продвижение аккаунта

В мои обязанности входит улучшение вашей аватарки, шапка профиля будет сразу же зазывать каждого, исправление ошибок в вечных историях

300 Руб 2 Дня

Доработка сайтов на Битрикс

Официальный партнер Битрикс. Любые доработки сайтов на Битрикс. Стоимость от 5000 р. Написание нестандартных компонентов и модулей. Исправление ошибок.

Любые доработки сайтов на Битрикс. Стоимость от 5000 р. Написание нестандартных компонентов и модулей. Исправление ошибок.

5 000 Руб 7 Дней

Написание текстов (рефератов, проектов) и исправление ошибок в текстах

Мне 16 лет, я регулярно занимаюсь написанием рефератов и проектов в учебной деятельности. Помогу вам написать текст и исправить ошибки.

200 Руб 3 Дня

Исправление грамматических ошибок | НЛП-прогресс

Исправление грамматических ошибок (GEC) — это задача исправления различных типов ошибок в тексте, таких как орфографические, пунктуационные, грамматические ошибки и ошибки выбора слов.

GEC обычно формулируется как задание на исправление предложений. Система GEC принимает потенциально ошибочное предложение в качестве входных данных и, как ожидается, преобразует его в исправленную версию. См. приведенный ниже пример:

См. приведенный ниже пример:

| Ввод (ошибочный) | Выход (исправлено) |

|---|---|

| Она видит, что прошлой ночью Тома поймал полицейский в парке. | Вчера вечером она видела, как полицейский поймал Тома в парке. |

Общая задача CoNLL-2014

Тестовый набор общих задач CoNLL-2014 является наиболее широко используемым набором данных для тестирования систем GEC. Тестовый набор содержит 1312 предложений на английском языке с аннотациями ошибок, сделанными двумя экспертами-аннотаторами. Модели оцениваются с помощью счетчика MaxMatch (Dahlmeier and Ng, 2012), который вычисляет F 9 на основе диапазона.0027 β -оценка (β установлен на 0,5 для точности взвешивания в два раза, как отзыв).

Параметр общей задачи ограничивает использование системами только общедоступных наборов данных для обучения, чтобы обеспечить справедливое сравнение между системами. Ниже приведены самые высокие опубликованные баллы по набору тестов CoNLL-2014. Проводится различие между статьями, в которых сообщается о результатах ограниченной совместной постановки задач CoNLL-2014 для обучения с использованием только общедоступных наборов обучающих данных ( Ограничено ) и те, которые использовали большие закрытые наборы данных ( Unrestricted ).

Ниже приведены самые высокие опубликованные баллы по набору тестов CoNLL-2014. Проводится различие между статьями, в которых сообщается о результатах ограниченной совместной постановки задач CoNLL-2014 для обучения с использованием только общедоступных наборов обучающих данных ( Ограничено ) и те, которые использовали большие закрытые наборы данных ( Unrestricted ).

Ограничено :

| Модель | Ф0.5 | Бумага / Источник | Код |

|---|---|---|---|

| ESC (Кориб и др., NAACL 2022) | 69,51 | Удивительно простая комбинация систем для исправления грамматических ошибок | официальный |

| T5 (t5.1.1.xxl), обученный cLang-8 (Rothe et al., ACL-IJCNLP 2021) | 68,87 | Простой рецепт исправления многоязычных грамматических ошибок | T5, cLang-8 |

| Помеченные искажения — ансамбль (Штальберг и Кумар, 2021) | 68,3 | Генерация синтетических данных для исправления грамматических ошибок с помощью тегированных моделей искажения | Официальный |

TMTC (Lai et al. , ACL Findings 2022) , ACL Findings 2022) | 67.02 | Управляемые типом многооборотные исправления для исправления грамматических ошибок | официальный |

| Тегирование последовательностей + преобразования на уровне токенов + двухэтапная тонкая настройка + (BERT, RoBERTa, XLNet), ансамбль (Omelianchuk et al., BEA 2020) | 66,5 | GECToR — исправление грамматических ошибок: тег, а не перезапись | Официальный |

| Неглубокое агрессивное декодирование с BART (12+2), одиночная модель (луч = 1) (Sun et al., ACL 2021) | 66,4 | Мгновенное исправление грамматических ошибок с поверхностным агрессивным декодированием | Официальный |

| DeBERTa(L) + RoBERTa(L) + XLNet (Тарнавский и др., ACL 2022) | 65,3 | Сборка и анализ знаний о больших последовательностях тегов для исправления грамматических ошибок | Официальный |

Тегирование последовательностей + преобразования на уровне токенов + двухэтапная тонкая настройка + XLNet, одна модель (Омельянчук и др. , BEA 2020) , BEA 2020) | 65,3 | GECToR — исправление грамматических ошибок: тег, а не перезапись | Официальный |

| Трансформатор + предварительная подготовка с псевдоданными + BERT (Канеко и др., ACL 2020) | 65,2 | Модели кодировщика-декодерамогут извлечь выгоду из предварительно обученных моделей маскированного языка при исправлении грамматических ошибок | Официальный |

| Трансформатор + предварительная тренировка с псевдоданными (Kiyono et al., EMNLP 2019) | 65,0 | Эмпирическое исследование включения псевдоданных в исправление грамматических ошибок | Официальный |

| Ансамбль Seq2Edits + полная переоценка последовательности (Stahlberg and Kumar, EMNLP 2020) | 62,7 | Seq2Edits: Преобразование последовательности с использованием операций редактирования на уровне интервала | Официальный |

Маркировка последовательности с редактированием с использованием BERT, более быстрый вывод (ансамбль) (Awasthi et al. , EMNLP 2019) , EMNLP 2019) | 61,2 | Модели параллельного итеративного редактирования для преобразования локальной последовательности | Официальный |

| Трансформатор с копией дополнений + предварительный поезд (Чжао и Ван, NAACL 2019) | 61,15 | Улучшение исправления грамматических ошибок посредством предварительного обучения архитектуры с дополненной копией с немаркированными данными | Официальный |

| Маркировка последовательности с редактированием с использованием BERT, ускоренный вывод (одиночная модель) (Awasthi et al., EMNLP 2019) | 59,7 | Модели параллельного итеративного редактирования для преобразования локальной последовательности | Официальный |

| CNN Seq2Seq + оценка качества (Chollampatt and Ng, EMNLP 2018) | 56,52 | Нейронная оценка качества исправления грамматических ошибок | Официальный |

| SMT + BiGRU (Grundkiewicz and Junczys-Dowmunt, 2018) | 56,25 | Производительность, близкая к человеческому уровню, при исправлении грамматических ошибок с помощью гибридного машинного перевода | нет данных |

Трансформатор (Junczys-Dowmunt et al. , 2018) , 2018) | 55,8 | Подход к исправлению нейронных грамматических ошибок как задаче машинного перевода с низким уровнем ресурсов | Официальный |

| CNN Seq2Seq (Chollampatt and Ng, 2018) | 54,79 | Многослойная сверточная нейронная сеть кодировщика-декодера для исправления грамматических ошибок | Официальный |

Без ограничений :

| Модель | Ф0.5 | Бумага / Источник | Код |

|---|---|---|---|

| CNN Seq2Seq + Fluency Boost (Ge et al., 2018) | 61,34 | Достижение производительности на уровне человека в автоматическом исправлении грамматических ошибок: эмпирическое исследование | нет данных |

Restricted : используются только общедоступные наборы данных. Без ограничений : использует закрытые наборы данных.

Без ограничений : использует закрытые наборы данных.

CoNLL-2014 10 Аннотации

Брайант и Нг, 2015 г. выпустили 8 дополнительных аннотаций (в дополнение к двум официальным аннотациям) для общего набора тестов CoNLL-2014 (ссылка).

Ограничено :

| Модель | Ф0.5 | Бумага / Источник | Код |

|---|---|---|---|

| SMT + BiGRU (Grundkiewicz and Junczys-Dowmunt, 2018) | 72.04 | Производительность, близкая к человеческому уровню, при исправлении грамматических ошибок с помощью гибридного машинного перевода | нет данных |

| CNN Seq2Seq (Chollampatt and Ng, 2018) | 70,14 (измерено Ge et al., 2018) | Многослойная сверточная нейронная сеть кодировщика-декодера для исправления грамматических ошибок | Официальный |

Без ограничений :

| Модель | Ф0. 5 5 | Бумага / Источник | Код |

|---|---|---|---|

| CNN Seq2Seq + Fluency Boost (Ge et al., 2018) | 76,88 | Достижение производительности на уровне человека в автоматическом исправлении грамматических ошибок: эмпирическое исследование | нет данных |

Restricted : используются только общедоступные наборы данных. Без ограничений : использует закрытые наборы данных.

JFLEG

Набор тестовJFLEG, выпущенный Napoles et al., 2017, состоит из 747 английских предложений с 4 ссылками на каждое предложение. Модели оцениваются с помощью показателя GLEU (Napoles et al., 2016).

Ограничено :

| Модель | ГЛЕУ | Бумага / Источник | Код |

|---|---|---|---|

| Коррупция с тегами (Stahlberg and Kumar, 2021) | 64,7 | Генерация синтетических данных для исправления грамматических ошибок с помощью тегированных моделей искажения | Официальный |

Трансформатор + предварительная подготовка с псевдоданными + BERT (Kaneko et al. , ACL 2020) , ACL 2020) | 62,0 | Модели кодировщика-декодера могут извлечь выгоду из предварительно обученных моделей маскированного языка при исправлении грамматических ошибок | Официальный |

| SMT + BiGRU (Grundkiewicz and Junczys-Dowmunt, 2018) | 61,50 | Производительность, близкая к человеческому уровню, при исправлении грамматических ошибок с помощью гибридного машинного перевода | нет данных |

| Трансформатор (Junczys-Dowmunt et al., 2018) | 59,9 | Подход к исправлению нейронных грамматических ошибок как задаче машинного перевода с низким уровнем ресурсов | нет данных |

| CNN Seq2Seq (Chollampatt and Ng, 2018) | 57,47 | Многослойная сверточная нейронная сеть кодировщика-декодера для исправления грамматических ошибок | Официальный |

Без ограничений :

| Модель | ГЛЕУ | Бумага / Источник | Код |

|---|---|---|---|

CNN Seq2Seq + Fluency Boost и вывод (Ge et al. , 2018) , 2018) | 62,42 | Достижение производительности на уровне человека в автоматическом исправлении грамматических ошибок: эмпирическое исследование | нет данных |

Restricted : используются только общедоступные наборы данных. Без ограничений : использует закрытые наборы данных.

Общая задача BEA — 2019

Общая задача BEA — набор данных 2019 года, выпущенный для общей задачи BEA по исправлению грамматических ошибок, предоставляет более новый и больший набор данных для оценки моделей GEC в 3 треках на основе наборов данных, используемых для обучения:

- Ограниченный путь

- Трек без ограничений

- Трек с низким ресурсом

Наборы для обучения и разработки публикуются публично, а производительность модели GEC оценивается по баллу F-0,5. Выходные данные модели в тестовом наборе должны быть загружены в Codalab (общедоступно), где отображаются метрики ошибок по категориям. Набор тестов состоит из 4477 предложений (больше и разнообразнее, чем набор данных CoNLL-14), а результаты оцениваются с помощью инструментария ERRANT. Опубликованные данные собираются из 2 источников:

Набор тестов состоит из 4477 предложений (больше и разнообразнее, чем набор данных CoNLL-14), а результаты оцениваются с помощью инструментария ERRANT. Опубликованные данные собираются из 2 источников:

- Write & Improve, онлайн-платформа, которая помогает учащимся, для которых английский язык не является родным, писать.

- LOCNESS, корпус, состоящий из эссе, написанных носителями английского языка.

Ниже приведено описание дорожек с сайта BEA:

Ограниченный трек: В треке с ограниченным доступом участники могут использовать только следующие наборы обучающих данных:

.- FCE (Yannakoudakis et al., 2011)

- Lang-8 Corpus of Learner English (Mizumoto et al., 2011; Tajiri et al., 2012)

- ЯДРО (Dahlmeier et al., 2013)

- W&I+LOCNESS (Bryant et al., 2019; Granger, 1998)

Обратите внимание, что мы ограничиваем участников предварительно обработанным Lang-8 Corpus of Learner English, а не необработанным, многоязычным Lang-8 Learner Corpus, поскольку в противном случае участникам пришлось бы фильтровать сам сырой корпус. Мы также не разрешаем использовать наборы общих тестов CoNLL 2013/2014 в этом треке.

Мы также не разрешаем использовать наборы общих тестов CoNLL 2013/2014 в этом треке.

Отслеживание без ограничений: В неограниченном треке участники могут использовать что угодно и что угодно для создания своих систем. Сюда входят проприетарные наборы данных и программное обеспечение.

Низкоресурсная дорожка (ранее неконтролируемая дорожка): В треке с низким уровнем ресурсов участники могут использовать только следующий набор обучающих данных: набор разработки W&I+LOCNESS.

Поскольку современные современные системы для достижения наилучшей производительности полагаются на максимально возможное количество аннотированных данных об учащихся, цель направления с низкими ресурсами — стимулировать исследования систем, которые не полагаются на большие объемы данных об учащихся. Это направление должно представлять особый интерес для исследователей, работающих над GEC для языков, для которых не существует больших обучающих корпусов.

Результаты тестового набора WI-LOCNESS:

Ограниченный трек :

| Модель | Ф0.5 | Бумага / Источник | Код |

|---|---|---|---|

| ESC (Кориб и др., NAACL 2022) | 79,90 | Удивительно простая комбинация систем для исправления грамматических ошибок | официальный |

| TMTC (Lai et al., ACL Findings 2022) | 77,93 | Управляемые типом многооборотные исправления для исправления грамматических ошибок | официальный |

| DeBERTa(L) + RoBERTa(L) + XLNet (Тарнавский и др., ACL 2022) | 76.05 | Сборка и анализ знаний о больших последовательностях тегов для исправления грамматических ошибок | Официальный |

| GECToR большой без синтетической предварительной подготовки — ансамбль (Тарнавский и Омельянчук, 2021) | 76. 05 05 | Улучшение маркировки последовательностей для исправления грамматических ошибок | Официальный |

| T5 (t5.1.1.xxl), обученный cLang-8 (Rothe et al., ACL-IJCNLP 2021) | 75,88 | Простой рецепт исправления многоязычных грамматических ошибок | T5, cLang-8 |

| Помеченные искажения — ансамбль (Штальберг и Кумар, 2021) | 74,9 | Генерация синтетических данных для исправления грамматических ошибок с использованием тегированных моделей искажения | Официальный |

| Тегирование последовательностей + преобразования на уровне токенов + двухэтапная тонкая настройка + (BERT, RoBERTa, XLNet), ансамбль (Omelianchuk et al., BEA 2020) | 73,6 | GECToR — исправление грамматических ошибок: тег, а не перезапись | Официальный |

| Комбинация BEA | 73,18 | Учимся комбинировать исправления грамматических ошибок | официальный |

Неглубокое агрессивное декодирование с BART (12+2), одиночная модель (луч=1) (Sun et al. , ACL 2021) , ACL 2021) | 72,9 | Мгновенное исправление грамматических ошибок с поверхностным агрессивным декодированием | Официальный |

| Тегирование последовательностей + преобразования на уровне токенов + двухэтапная тонкая настройка + XLNet, одна модель (Омельянчук и др., BEA 2020) | 72,4 | GECToR — исправление грамматических ошибок: тег, а не перезапись | Официальный |

| Трансформатор + предварительная тренировка с псевдоданными (Kiyono et al., EMNLP 2019) | 70,2 | Эмпирическое исследование включения псевдоданных в исправление грамматических ошибок | нет данных |

| Трансформатор + предварительная подготовка с псевдоданными + BERT (Канеко и др., ACL 2020) | 69,8 | Модели кодировщика-декодера могут извлечь выгоду из предварительно обученных моделей маскированного языка при исправлении грамматических ошибок | Официальный |

| Трансформатор | 69,47 | Нейронные системы коррекции грамматических ошибок с неконтролируемым предварительным обучением на синтетических данных | Официально: Код скоро будет обновлен |

| Трансформатор | 69,00 | Нейронная система исправления грамматических ошибок, построенная на лучшем предварительном обучении и последовательном переносе обучения | Официальный |

| Сборка моделей | 66,78 | Системы LAIX в общей задаче BEA-2019 GEC | нет данных |

Трек с низким ресурсом :

| Модель | Ф0. 5 5 | Бумага / Источник | Код |

|---|---|---|---|

| Трансформатор | 64,24 | Нейронные системы исправления грамматических ошибок с неконтролируемым предварительным обучением на синтетических данных | Официально: Код скоро будет обновлен |

| Трансформатор | 58,80 | Система исправления нейронных грамматических ошибок, построенная на лучшем предварительном обучении и обучении с последовательным переносом | Официальный |

| Сборка моделей | 51,81 | Системы LAIX в общей задаче BEA-2019 GEC | нет данных |

№ по каталогу :

- Хелен Яннакудакис, Екатерина Кочмар, Клаудия Ликок, Нитин Маднани, Ильдико Пилан, Торстен Зеш, в материалах четырнадцатого семинара по инновационному использованию НЛП для создания образовательных приложений

- Кристофер Брайант, Мариано Феличе и Тед Бриско.

2017. Автоматическая аннотация и оценка типов ошибок для исправления грамматических ошибок. В материалах 55-го ежегодного собрания Ассоциации компьютерной лингвистики (Том 1: Длинные статьи). Ванкувер, Канада.

2017. Автоматическая аннотация и оценка типов ошибок для исправления грамматических ошибок. В материалах 55-го ежегодного собрания Ассоциации компьютерной лингвистики (Том 1: Длинные статьи). Ванкувер, Канада.

Исправление грамматических ошибок: Машины понимают и исправляют ошибки в тексте! | Айшани Басу | Аналитика Vidhya

Photo by nadi borodina on Unsplash Исправление грамматических ошибок (GEC) относится к задаче обнаружения и исправления грамматической ошибки грамматически неправильного предложения. Эти ошибки могут включать в себя все виды грамматических ошибок, таких как орфографические ошибки , неправильное использование артиклей, предлогов, местоимений, существительных и т. д. или даже неправильное построение предложения.0033 . GEC — это, по сути, задача НЛП, которая заставляет наши машины думать так же, как мы, учась исправлять грамматику, как это делал бы любой человек. Существует широкий спектр приложений, в которых используется исправление грамматических ошибок, проверяющих грамматику вводимого текста, например, в почтовых приложениях, текстовых редакторах, блокнотах и т. д.

д.

Этот блог направлен на решение задачи исправления грамматических ошибок используя нейронные сети, и пытается проанализировать шаги, необходимые для его улучшения.

Ниже приводится содержание этого блога:- Обзор литературы

- ML постановка задачи

- Бизнес-ограничения

- EDA

- Базовая модель

- Окончательная модель

- др. рассказывает о последних тенденциях и предыдущих работах в области систем обнаружения и исправления грамматических ошибок, а также о проблемах, с которыми сталкиваются эти работы. Подходы к решению этой проблемы в основном основаны на правилах, синтаксисе, машинном обучении и глубоких нейронных сетях. Кроме того, также рассматриваются менее ресурсоемкие языки, такие как амхарский, датский, греческий, латышский, пенджаби, филиппинский, арабский. Основанные на правилах, основанные на синтаксисе по сравнению с машинным обучением и глубокими нейронными сетями

Системы на основе правил используют набор предопределенных правил (образцов ошибок) для сопоставления с текстом, и все правила разрабатываются вручную.

Системы, основанные на синтаксисе, , с другой стороны, используют синтаксис текста вместе с лексической базой данных, морфологическим анализатором и синтаксическим анализатором. Парсер создает дерево синтаксического анализа с заданной грамматикой, и если полное создание дерева не удается, текст считается ошибочным.

Системы, основанные на синтаксисе, , с другой стороны, используют синтаксис текста вместе с лексической базой данных, морфологическим анализатором и синтаксическим анализатором. Парсер создает дерево синтаксического анализа с заданной грамматикой, и если полное создание дерева не удается, текст считается ошибочным.Эти методы полезны при некоторых грамматических ошибках, но неэффективны, когда мы хотим исправить множество различных видов грамматических ошибок. Кроме того, поскольку они требуют много места для хранения и больших трудозатрат, были изучены другие подходы.

Подходы к машинному обучению включают в основном два вида методов, т. е. классификационные и статистические методы. Эти методы оказались очень успешными в задаче GEC, но требуют большого количества функций и, в свою очередь, требуют много времени и опыта.

Недавние работы показали, что результаты использования нейронных сетей и нейронного машинного перевода в задачах исправления грамматических ошибок и обнаружения являются чрезвычайно обнадеживающими.

Многие такие архитектуры NMT использовали модели перевода на уровне символов или модели перевода на уровне слов.

Многие такие архитектуры NMT использовали модели перевода на уровне символов или модели перевода на уровне слов.Зачем использовать нейронные сети?

— Нет необходимости разрабатывать функции, поскольку алгоритмы глубокого обучения самостоятельно изучают наиболее важные функции.0003

Немногие из общих наборов данных, используемых для GEC, — это CoNLL-13, CoNLL-14 (из соревнований CoNLL GEC), набор данных FCE и т. д. др. использовали модель нейронного машинного перевода

на уровне слов с использованием RNN для выполнения преобразования последовательности в последовательность от неправильных предложений к правильно сформированным, что дало F0,5 балл 53,49 на наборе данных FCE и 39,9 на тестовом наборе CoNLL-2014, что является довольно хорошим показателем. - Dahlmeier et. др. представляет декодер поиска луча , который итеративно генерирует новые исправления гипотез из текущих гипотез и оценивает их на основе признаков грамматической правильности и беглости .

- Аликаниотис и др. представляет современных языковых модели Transformer, обученных на больших лингвистических корпусах, и их эффективность оценивается в задаче GEC без какого-либо контролируемого обучения . Основная идея использования языковой модели для задачи GEC заключается в том, что грамматически неправильное предложение должно иметь низкую вероятность. Нам нужно научиться преобразовывать эту последовательность с низкой вероятностью в последовательность с высокой вероятностью или грамматически правильную последовательность.

- Raheja et. др. представляет использование подхода состязательного обучения в задаче GEC с использованием архитектуры дискриминатора генератора .

Генератор представляет собой модель-трансформер, обученную производить грамматически правильное предложение при наличии грамматически неправильных предложений. Дискриминатор представляет собой модель классификации пар предложений, обученную оценивать пару грамматически. Обе модели предварительно обучаются на параллельных текстах, а затем дополнительно настраиваются с использованием метода градиента политик, который присваивает высокие награды предложениям, которые могут быть истинными исправлениями грамматически неправильного текста.

Генератор представляет собой модель-трансформер, обученную производить грамматически правильное предложение при наличии грамматически неправильных предложений. Дискриминатор представляет собой модель классификации пар предложений, обученную оценивать пару грамматически. Обе модели предварительно обучаются на параллельных текстах, а затем дополнительно настраиваются с использованием метода градиента политик, который присваивает высокие награды предложениям, которые могут быть истинными исправлениями грамматически неправильного текста. - Система должна иметь высокую точность, и предпочтение должно отдаваться системе с более высокой точностью, а не отзыву.

- Всегда предпочтительнее низкая задержка.

- Кроме того, поскольку проблема связана с приемом грамматически неправильного текста в качестве входных данных, при развертывании на сервере нам нужны оптимизированные конвейеры для обработки объема входных данных.

- Naghnejat 4 4 4 4 4 4 4

Их модель заменила нечастые слова символом UNK и применила неконтролируемые модели выравнивания, такие как GIZA++ и METEOR, к выходным данным модели NMT, чтобы найти источники неизвестных слов, которые они затем перевели, используя модель перевода на уровне слов, обученную на параллельных предложениях.

Ограничение этого подхода заключалось в том, что модель не учитывала слова Out Of Vocabulary или OOV в контексте для принятия правильных решений и не могла хорошо обобщать, чтобы исправлять слова, невидимые в данных параллельного обучения.

С другой стороны, Xie et.al. использовала модель перевода уровня

из символов вместо модели уровня слов, чтобы избежать проблемы слов OOV, которая набрала 40,56 баллов F0,5 на тестовом наборе CoNLL 14.Ограничение этого подхода заключалось в том, что модель не могла использовать информацию на уровне слов, даже если она использовалась с языковой моделью на основе слов.

Использование CNN Kim et. др. представляет модель, которая представляет собой комбинацию трех моделей кодировщика-декодера на основе символов, одной модели кодера-декодера на основе слов и уровня предложения CNN , которая показала самые высокие результаты в общей задаче бинарного прогнозирования AESW 2016 (определение наличия ошибки в предложении или нет).

Мы моделируем задачу GEC как последовательность задач обучения с использованием NMT, где текст или вектор из исходного языка сопоставляются с вектором на целевом языке, что является только оценкой максимального правдоподобия вывода, учитывая входы.

Для этой задачи можно использовать несколько наборов данных, таких как CoNLL-13, CoNLL-14, Lang-8, FCE, JFLEG и т. д., каждый из которых посвящен различным видам ошибок и целям.

Для этой задачи я использовал набор данных Lang-8.

На приведенном выше графике показаны гистограммы длины предложений для ввода, т. е. грамматически неправильного предложения, и вывода, т. е. грамматически правильного предложения. Распределение длины предложений в каждом корпусе похоже.

Облака слов для грамматически правильных (слева) и грамматически неправильных предложений (справа)На приведенном выше графике показаны облака слов, чтобы определить наиболее распространенные слова в грамматически правильных и грамматически неправильных предложениях, которые несколько похожи (думаю, сегодня, друг и т. д.).

Мы также можем создать собственный набор данных, добавив ошибки в текст, полученный из любого источника. Простой код, использующий Spacy для этого, выглядит следующим образом.

В качестве функции потерь мы используем замаскированных разреженных категориальных кроссэнтропийных потерь.

Показатели:Оценка Fbeta (с бета = 0,5) используется в качестве обучающей метрики, а BLEU оценивает для оценки окончательной производительности.

Для базовой модели я внимательно обучил ванильную модель кодировщика-декодера и модель кодировщика-декодера.

Кодер-декодер и модель AttentionПредставленная Sutskever et.al. модель

-декодера-кодировщика , широко используемая для отображения последовательности на последовательность, в основном состоит из двух блоков, кодера и декодера, где 9Кодер 0032 кодирует входной вектор в вектор контекста , а декодер декодирует этот вектор контекста в выходной сигнал . Ожидается, что контекстный вектор захватит сущность ввода , который в основном является выходом кодера. RNN широко используются в качестве кодировщика и декодера, поскольку они очень хорошо фиксируют последовательную информацию.

RNN широко используются в качестве кодировщика и декодера, поскольку они очень хорошо фиксируют последовательную информацию.Модель кодер-декодер работает очень хорошо, но возникают проблемы с захватом сути, когда входной вектор начинает становиться длиннее. Для решения этой проблемы механизм внимания был введен Bahdanau et. др. улучшить модель кодировщик-декодер, чтобы обеспечить успешный перевод более длинных входных предложений.

Интуитивно понятно, что механизм внимания принимает вектор контекста, и выходные данные кодера для каждого отдельного временного шага и вычисляют весовой коэффициент внимания для каждого из временных шагов кодировщика . Этот вес сообщает нам , какое значение следует придавать каждому выходному сигналу энкодера , и умножается на выходной сигнал энкодера для каждого временного шага и подается в декодер на каждом временном шаге. Таким образом, декодер знает, какому входному слову уделить максимальное внимание при определении вывода декодера на каждом временном шаге . Следующее изображение объясняет сеть внимания.

Следующее изображение объясняет сеть внимания.

Синие блоки в левом нижнем углу, обозначенные полосой hs, представляют собой выходные данные кодировщика для всех временных шагов. Мы можем представить, что пять синих блоков представляют собой ввод кодировщика или, другими словами, пять слов (при условии перевода на уровне слов), которые подавались в блок кодировщика на каждом временном шаге, давая нам выходные данные кодировщика на каждом временном шаге.

Бордовые блоки справа внизу, обозначенные ht, представляют декодер скрыт в состоянии на каждом временном шаге, поэтому для простоты предположим, что последний блок декодирует второе слово входного предложения.

Как показано на левом изображении, при декодировании для каждого шага из выходных данных кодировщика создается контекстный вектор , ct . Если используется глобальное внимание , то для создания этого вектора используются все выходные данные энкодера (т. е. на всех временных шагах). Этот вектор на самом деле просто сумма умножения каждого из выходных данных на вес внимания . at обозначает вектор, содержащий все веса внимания для каждого временного шага.

е. на всех временных шагах). Этот вектор на самом деле просто сумма умножения каждого из выходных данных на вес внимания . at обозначает вектор, содержащий все веса внимания для каждого временного шага.

Чтобы получить этот вес внимания, мы используем функции оценки и применяем их к выходным данным кодировщика и скрытым состояниям декодера. Например, если мы используем функцию оценки скалярного произведения, мы просто берем скалярное произведение состояний кодировщика и скрытого состояния декодера, чтобы получить вес внимания. Этот вес говорит нам, какое значение или контекст дает нам каждое состояние кодировщика для текущего состояния декодера.

Для локального внимания , как показано справа, мы используем только состояния кодировщика вблизи временного шага, на котором находится декодер.

Наконец, мы объединяем текущее скрытое состояние декодера ht с контекстным вектором ct и передаем его декодеру, чтобы получить следующее скрытое состояние декодера ht~.

Мы также не разрешаем использовать наборы общих тестов CoNLL 2013/2014 в этом треке.

Мы также не разрешаем использовать наборы общих тестов CoNLL 2013/2014 в этом треке. 2017. Автоматическая аннотация и оценка типов ошибок для исправления грамматических ошибок. В материалах 55-го ежегодного собрания Ассоциации компьютерной лингвистики (Том 1: Длинные статьи). Ванкувер, Канада.

2017. Автоматическая аннотация и оценка типов ошибок для исправления грамматических ошибок. В материалах 55-го ежегодного собрания Ассоциации компьютерной лингвистики (Том 1: Длинные статьи). Ванкувер, Канада. Системы, основанные на синтаксисе, , с другой стороны, используют синтаксис текста вместе с лексической базой данных, морфологическим анализатором и синтаксическим анализатором. Парсер создает дерево синтаксического анализа с заданной грамматикой, и если полное создание дерева не удается, текст считается ошибочным.

Системы, основанные на синтаксисе, , с другой стороны, используют синтаксис текста вместе с лексической базой данных, морфологическим анализатором и синтаксическим анализатором. Парсер создает дерево синтаксического анализа с заданной грамматикой, и если полное создание дерева не удается, текст считается ошибочным. Многие такие архитектуры NMT использовали модели перевода на уровне символов или модели перевода на уровне слов.

Многие такие архитектуры NMT использовали модели перевода на уровне символов или модели перевода на уровне слов. Генератор представляет собой модель-трансформер, обученную производить грамматически правильное предложение при наличии грамматически неправильных предложений. Дискриминатор представляет собой модель классификации пар предложений, обученную оценивать пару грамматически. Обе модели предварительно обучаются на параллельных текстах, а затем дополнительно настраиваются с использованием метода градиента политик, который присваивает высокие награды предложениям, которые могут быть истинными исправлениями грамматически неправильного текста.

Генератор представляет собой модель-трансформер, обученную производить грамматически правильное предложение при наличии грамматически неправильных предложений. Дискриминатор представляет собой модель классификации пар предложений, обученную оценивать пару грамматически. Обе модели предварительно обучаются на параллельных текстах, а затем дополнительно настраиваются с использованием метода градиента политик, который присваивает высокие награды предложениям, которые могут быть истинными исправлениями грамматически неправильного текста.