что это, как настроить и ускорить индексирование в поисковых системах

Как только вы создадите сайт для своего бизнеса, однозначно столкнетесь с понятием «индексация в поисковых системах». В статье постараемся как можно проще рассказать, что это такое, зачем нужно и как сделать, чтобы индексация проходила быстро и успешно.

Что такое индексация в поисковых системах

Под индексацией понимают добавление информации о сайте или странице в базу данных поисковой системы. Фактически поисковую базу можно сравнить с библиотечным каталогом, куда внесены данные о книгах. Только вместо книг здесь веб-страницы.

Если совсем просто, индексация — процесс сбора данных о сайте. Пока информация о новой странице не окажется в базе, ее не будут показывать по запросам пользователей. Это означает, что ваш сайт никто не увидит.

Индексация сайта — базовая часть работы по продвижению ресурса. Только потом уже добавляются все остальные элементы по оптимизации сайта. Если у веб-страницы будут проблемы с индексированием, ваш бизнес не получит клиентов с сайта и понесет убытки.

Если у веб-страницы будут проблемы с индексированием, ваш бизнес не получит клиентов с сайта и понесет убытки.

Как проходит процесс индексации

Давайте посмотрим, как происходит индексирование страниц сайта.

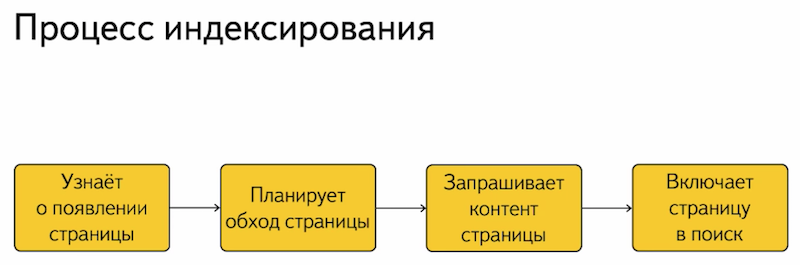

- Поисковый робот (краулер) обходит ресурсы и находит новую страницу.

- Данные анализируются: происходит очистка контента от ненужной информации, заодно формируется список лексем. Лексема — совокупность всех значений и грамматических форм слова в русском языке.

- Вся собранная информация упорядочивается, лексемы расставляются по алфавиту. Заодно происходит обработка данных, поисковая машина относит информацию к определенным тематикам.

- Формируется индексная запись.

Это стандартный процесс индексации документов для поисковых систем. При этом у «Яндекса» и Google существуют небольшие отличия в технических моментах, про это мы расскажем дальше.

Читайте также:

Отличия SEO под Яндекс и Google

Технологии и алгоритмы индексации

Сразу стоит оговориться, что точные алгоритмы индексирования — закрытая коммерческая информация. Поисковые системы тщательно охраняют эти данные. Поэтому в этом разделе расскажем про алгоритмы только в общих чертах

Вначале нужно отметить: «Яндекс» при индексации ориентируется в основном на файл robots.txt, а Google на файл sitemap.xml.

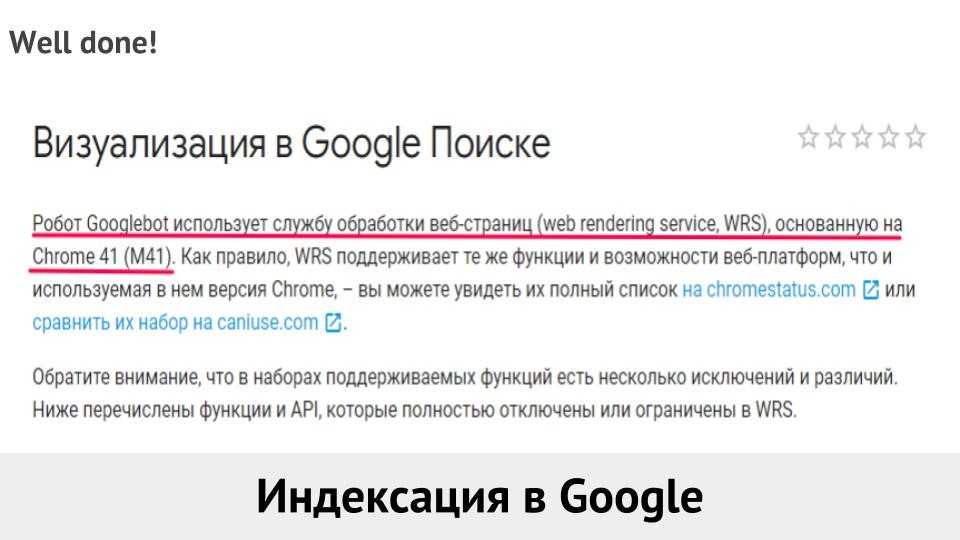

Основным отличием является использование технологии Mobile-first. Она подразумевает первоочередное сканирование и индексацию мобильной версии сайта. В индексе сохраняется именно мобильная версия. Получается, что если ваша страница при показе на мобильных устройствах будет содержать недостаточно нужной информации или в целом проигрывать основной версии сайта по качеству.

Также Google подтверждает наличие «краулингового бюджета» — регулярности и объема посещения сайта роботом. Чем больше краулинговый бюджет, тем быстрее новые страницы будут попадать в индекс. К сожалению, точных данных о способах расчета этого показателя представители компании не раскрывают. По наблюдениям специалистов, тут оказывают сильное влияние возраст сайта и частота обновлений.

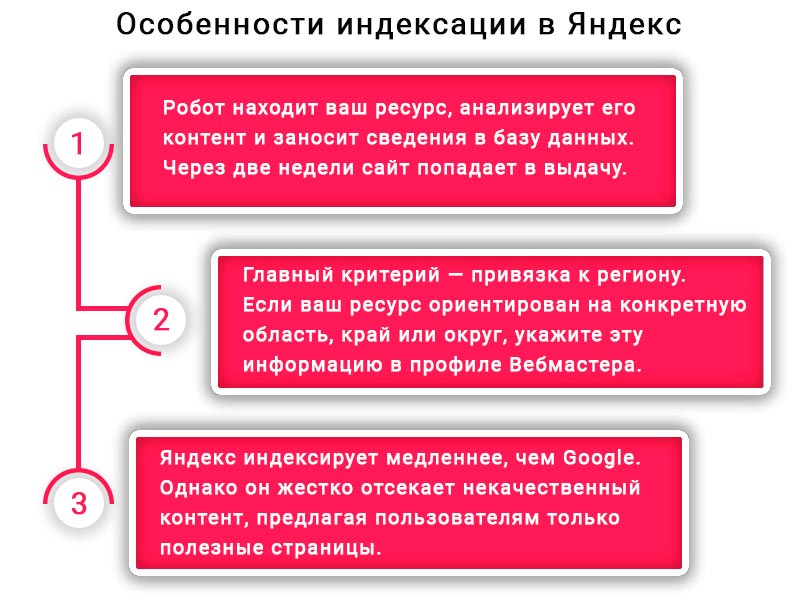

«Яндекс»

В «Яндексе» основной версией считается десктопная версия сайта, поэтому в первую очередь сканируется именно она. Официально краулингового бюджета здесь нет, поэтому индексирование происходит вне зависимости от траста и других показателей вашего ресурса. Еще может влиять количество выложенных в сеть на данный момент страниц. Речь про страницы, которые конкуренты и другие пользователи выкладывают одновременно с вами.

Приоритет при индексации имеют сайты с большой посещаемостью. Чем выше посещаемость, тем быстрее новая страница окажется в поисковой выдаче.

Также Яндекс не индексирует документы с весом более 10 Мб. Учитывайте это при создании страниц сайта. Советуем также почитать кейс: Продвижение сайта REG.RU за процент от продаж.

Заказать продвижение сейчас

Сайт

Телефон

Как настроить индексацию сайта

В целом сайт должен индексироваться самостоятельно, даже если вы не будете ничего предпринимать для этого. Но если вы разберетесь с настройкой, то получите быструю и надежную индексацию и в случае возникновения проблем с сайтом будете понимать, в чем причина.

Первое, что стоит сделать, — создать файл robots.txt. У большей части систем управления сайтом (CMS) есть автоматизированные решения для его генерации. Но нужно как минимум понимать, какие директивы используются в этом файле. На скриншоте показан стандартный документ для сайта на WordPress:

Типовой файл robots.

Обратите внимание, что здесь нет директивы host: она не используется «Яндексом» с 2018 года, а Google никогда ее и не замечал. Но при этом до сих пор встречаются рекомендации по использованию этой директивы, и многие по инерции вставляют ее в файл.

В таблице ниже указаны основные параметры, используемые в robots.txt:

| Директива | Зачем используется |

|

User-agent:

|

Показывает поискового робота, для которого установлены правила |

| Disallow: | Запрещает индексацию страниц |

| sitemap: | Показывает путь к файлу sitemap.xml |

| Clean-param: | Указывает на страницы, где часть ссылок не нужно учитывать, например UTM-метки |

| Allow: | Разрешает индексацию документа |

| Crawl-delay: | Указывает поисковому роботу минимальное время ожидания между посещением предыдущей и следующей страницы сайта |

Рассмотрим более подробно код на следующем скриншоте. User-agent показывает, что директивы предназначены для «Яндекса». А директива Disallow показывает, какие страницы не должны попасть в индекс. Это технические документы, в частности админ-панель сайта и плагины.

User-agent показывает, что директивы предназначены для «Яндекса». А директива Disallow показывает, какие страницы не должны попасть в индекс. Это технические документы, в частности админ-панель сайта и плагины.

Фрагмент кода robots.txt

Более подробно о том, каким должен быть robots.txt для сайта, можно прочитать в справке сервиса «Яндекс.Вебмастер».

Далее делаем файл sitemap.xml: фактически это карта сайта, созданная в формате xml. Сделано это для упрощения считывания данных поисковыми роботами. В файл вносятся все страницы, которые должны быть проиндексированы.

Для правильной индексации файл не должен превышать 50 Мб или 50000 записей. Если нужно проиндексировать больше адресов, делают несколько файлов, которые в свою очередь перечисляются в файле с индексом sitemap.

На практике сайты, работающие с бизнесом, редко имеют потребность в подобном решении — просто имейте в виду такую особенность.

На скриншоте показан фрагмент кода sitemap. xml, сгенерированный одним из плагинов WordPress:

xml, сгенерированный одним из плагинов WordPress:

Так выглядит файл sitemap.xml «изнутри»

Остается разобраться, как создать файл sitemap.xml. Решение зависит от CMS вашего сайта. Если он сделан не на популярном «движке», придется делать все руками. Можно воспользоваться онлайн-генератором: например, mySitemapgenerator. Вводим адрес сайта и через короткое время получаем готовый файл.

Для сайтов на CMS WordPress сделать такую карту сайта еще проще. У вас все равно уже установлен один из плагинов для SEO-оптимизации ресурса. Заходим в настройки плагина и включаем генерацию sitemap.xml. На скриншоте показан пример включения карты сайта через плагин AIOSEO:

Плагин для настройки sitemap.xml в WP

Чтобы сайт максимально быстро индексировался, следует обеспечить перелинковку. Тогда поисковый робот без проблем будет переходить по страницам и своевременно найдет новый документ.

Далее необходимо выполнить настройку индексирования в «Яндекс. Вебмастер» и Google Search Console.

Вебмастер» и Google Search Console.

Подробный гайд по оптимизации сайта на WordPress

Как ускорить индексацию сайта

В начале статьи мы рассказывали, как настроить индексирование. Теперь поговорим о том, как ускорить это процесс. В целом современные поисковые роботы довольно быстро собирают информацию о ресурсе: по моим наблюдениям, новые страницы появляются в индексе уже через 20–40 минут. Но так бывает не всегда, потому что может произойти сбой или еще какая-то нештатная ситуация, и страница будет индексироваться очень долго.

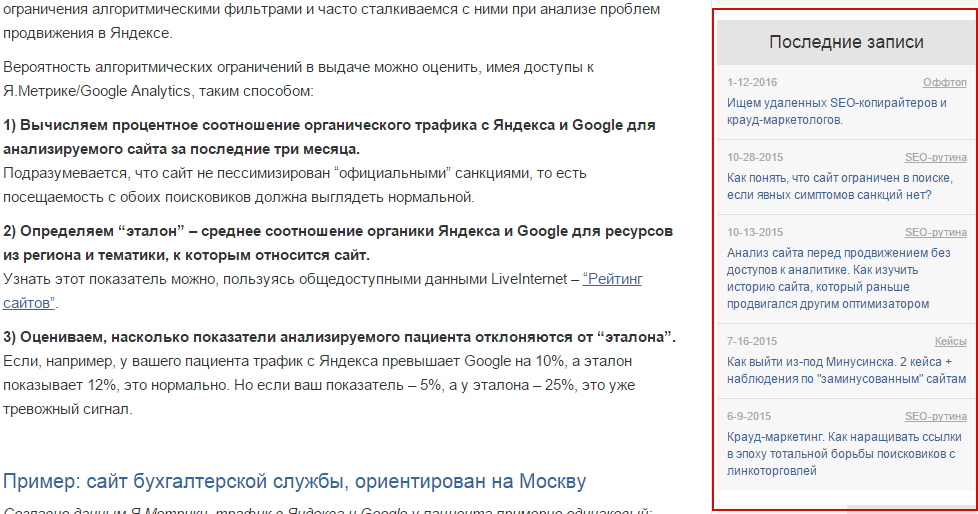

Появление адреса в списке проиндексированных страниц «Яндекс.Вебмастера» не совпадает с моментом индексации. На практике URL оказывается в индексе намного раньше, а в кабинете только при очередном апдейте.

При этом есть ситуации, когда индексирование нужно ускорить:

-

Сайт выходит из-под фильтров.

- Молодой ресурс обладает небольшим краулинговым бюджетом.

В обоих случаях рекомендуется подтолкнуть поисковых роботов. Отметим, что для «Яндекса» и Google подход будет разным.

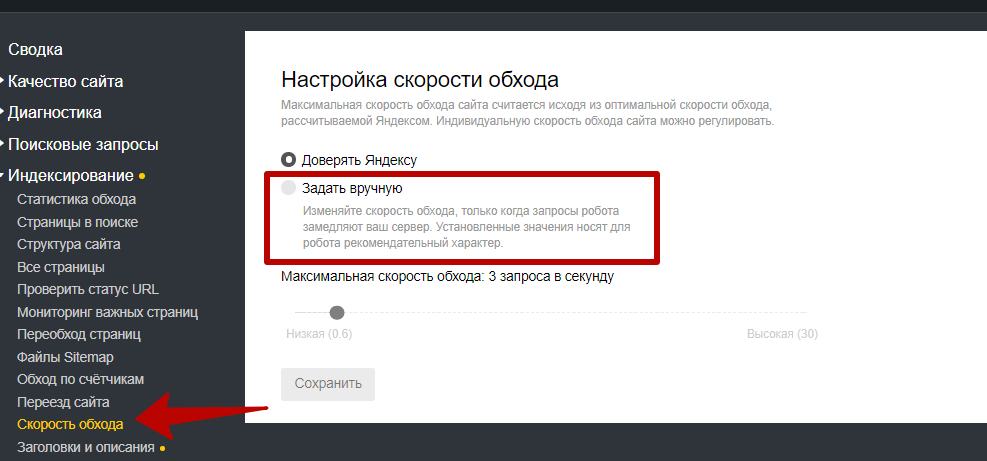

Начнем с отечественной поисковой системы. Заходим в «Яндекс.Вебмастер» и в меню слева, во вкладке «Индексирование», находим ссылку «Переобход страниц». Переходим по ней:

Яндекс.Вебмастер — подраздел «Переобход страниц» в меню «Индексирование»

На следующей вкладке вводим URL новой страницы, после чего жмем кнопку «Отправить». Отследить статус заявки можно в расположенном ниже списке:

Процесс отправки страниц сайта на переобход

Так можно поступать не только с новыми страницами, но и в случае изменения уже имеющихся на сайте. Только помните, что количество отправок в сутки ограничено, причем все зависит от возраста и траста сайта.

В самом «Вебмастере» предлагается для ускорения индексирования подключать переобход по счетчику «Яндекс. Метрики». Это не самое лучшее решение. Дело в том, что поисковый робот может ходить по всем страницам — даже тем, которые не нужно индексировать, причем в приоритете будут наиболее посещаемые документы. Может получиться ситуация, когда старые страницы робот обошел, а новые не заметил. Или вообще в поиск попадут технические страницы: например, страница авторизации или корзина интернет-магазина.

Метрики». Это не самое лучшее решение. Дело в том, что поисковый робот может ходить по всем страницам — даже тем, которые не нужно индексировать, причем в приоритете будут наиболее посещаемые документы. Может получиться ситуация, когда старые страницы робот обошел, а новые не заметил. Или вообще в поиск попадут технические страницы: например, страница авторизации или корзина интернет-магазина.

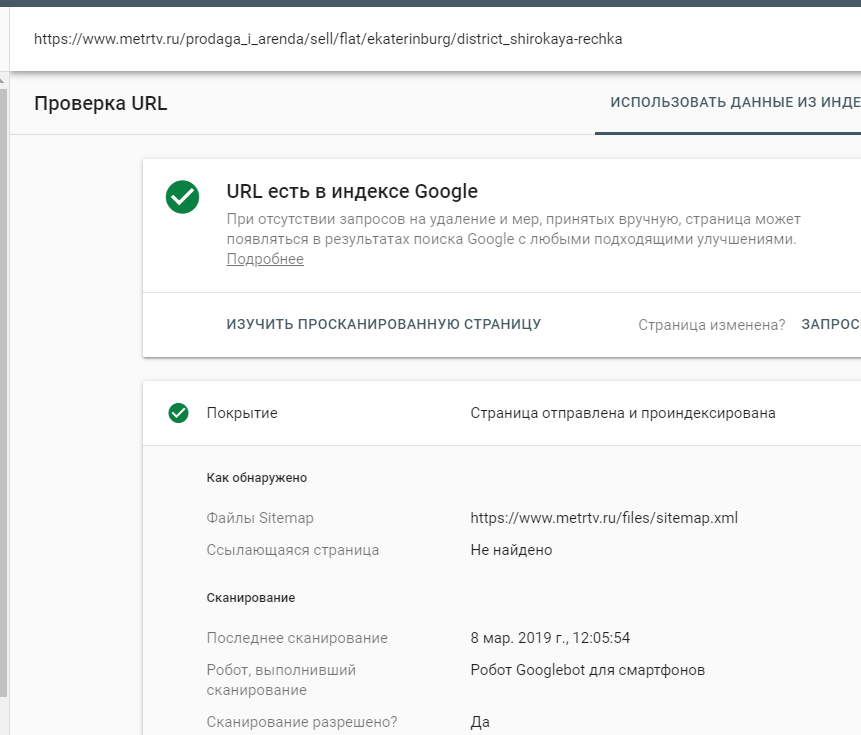

У Google ускорение индексации состоит из двух этапов. Сначала идем в Search Console, где на главной странице вверху находится поле «Проверка всех URL». В него вставляем адрес страницы, которую нужно проиндексировать. Далее нажимаем на клавиатуре «Enter».

Поле для ввода URL страницы, которую мы хотим добавить для индексирования

Ждем около минуты. Сервис нам будет показывать вот такое окно:

Всплывающее окно в Search Console о получении данных из индекса

Следующая страница выглядит вот так:

Как видите написано, что URL отсутствует в индексе, поэтому нажимаем на кнопку «Запросить индексирование»

Некоторое время поисковая машина будет проверять, есть ли возможность проиндексировать адрес:

Техническое окно с сообщением о проверке

Если все прошло успешно, Google сообщает, что страница отправлена на индексирование. Остается только дождаться результатов.

Остается только дождаться результатов.

Сообщение об отправке запроса. Обратите внимание, что не стоит повторно отправлять на индексацию один и тот же URL

При отправке на индексирование страниц сайта, следует помнить, что Google до сих пор очень ценит ссылки. Поэтому, существует альтернативный способ ускорения индексации — Twitter.

Сразу после публикации страницы идем в Twitter и делаем твит с нужным адресом. Буквально через полчаса URL будет уже в индексе Google.

Лучше всего использовать эти обе способа совместно. Так будет надежнее.

Читайте также:

Внешняя оптимизация сайта: как продвигать сайт с помощью сторонних ресурсов

Как запретить индексацию страниц

В некоторых случаях может потребоваться не проиндексировать, а наоборот запретить индексацию. К примеру, вы только создаете страницу и на ней нет нужной информации, или вообще сайт в разработке и все страницы — тестовые и недоработанные.

К примеру, вы только создаете страницу и на ней нет нужной информации, или вообще сайт в разработке и все страницы — тестовые и недоработанные.

Существует несколько способов, чтобы «спрятать» страницу от поисковых роботов. Рассмотрим наиболее удобные варианты.

Способ первый

Если вам нужно скрыть всего один документ, можно добавить в код страницы метатег Noindex. Эта команда дает поисковому роботу команду не индексировать документ. Размещают его между тегами <head>. Вот код, который нужно разместить:

<meta name=»robots» content=»noindex» />

Большая часть CMS позволяют использовать этот метод в один клик, предлагая готовые решения. У WordPress, например, для этого имеется отдельная строчка в настройках редактора, а в «1С-Битрикс» путем настроек раздела и конкретной страницы.

Способ второй

Заключается в редактировании файла robots.txt. Разберем несколько примеров закрытия страниц от индексирования.

Начнем с полного закрытия сайта от индексирования. На скриншоте код, который выполняет эту задачу: звездочка говорит, что правило работает для всех поисковых роботов. Косая черта (слеш) показывает, что директива Disallow относится ко всему сайту.

Полное закрытие сайта от индексирования

Если нам нужно закрыть ресурс от индексирования в конкретной поисковой системе, указываем название ее краулера. На скриншоте показано закрытие от робота «Яндекса».

Закрываем сайт от индексации «Яндексом»

Когда нужно избежать индексирования конкретной страницы, после слеша указываем параметры пути к документу. Пример показан на скриншоте:

Закрытие одной страницы в Robots.txt

Для Google все перечисленные способы работают аналогично. С разницей лишь в том, что если страницу или целый сайт нужно скрыть конкретно от этой поисковой системы, в User-agent указывают атрибут Googlebot.

Закрытие страниц от индексации используется довольно часто. В процессе развития своего веб-ресурса вам часто придется делать новые страницы, или переделывать имеющиеся. Чтобы избежать попадания в поисковую выдачу не готовых к показу страниц, имеет смысл закрывать их от индексации.

В процессе развития своего веб-ресурса вам часто придется делать новые страницы, или переделывать имеющиеся. Чтобы избежать попадания в поисковую выдачу не готовых к показу страниц, имеет смысл закрывать их от индексации.

Присоединяйтесь к нашему Telegram-каналу!

- Теперь Вы можете читать последние новости из мира интернет-маркетинга в мессенджере Telegram на своём мобильном телефоне.

- Для этого вам необходимо подписаться на наш канал.

Распространенные ошибки индексации

Чаще всего проблемы возникают из-за случайного закрытия сайта от индексирования. У меня был случай, когда клиент при самостоятельном обновлении плагинов как-то внес изменения в файл robots.txt, и сайт исчез из поисковой выдачи. Поэтому при всех действиях, которые связаны с этим файлом, обязательно проверяйте, нет ли изменений в директивах.

Для проверки можно использовать инструмент Яндекс.Вебмастер «Анализ robots.txt».

Анализатор robots.txt — бесплатный и полезный инструмент проверки файла на корректность записанных директив

В некоторых случаях могут индексироваться технические страницы. К примеру, на WordPress при размещении изображений в виде медиафайла поисковый робот может индексировать каждую картинку в качестве отдельной страницы. В таком случае делаем редирект с этой страницы на тот документ, где изображение будет выводиться.

Читайте также:

Как сделать редирект — подробное руководство по настройке и использованию

Иногда встречаются проблемы с индексированием из-за неполадок на сервере или хостинге, но это уже нужно решать с администратором сервера, что выходит за рамки этой статьи.

Медленное индексирование может быть следствием наложения фильтров со стороны поисковых систем. Посмотрите, нет ли предупреждений в сервисах для вебмастеров: если они есть, устраните проблемы.

Посмотрите, нет ли предупреждений в сервисах для вебмастеров: если они есть, устраните проблемы.

Как проверить индексацию сайта

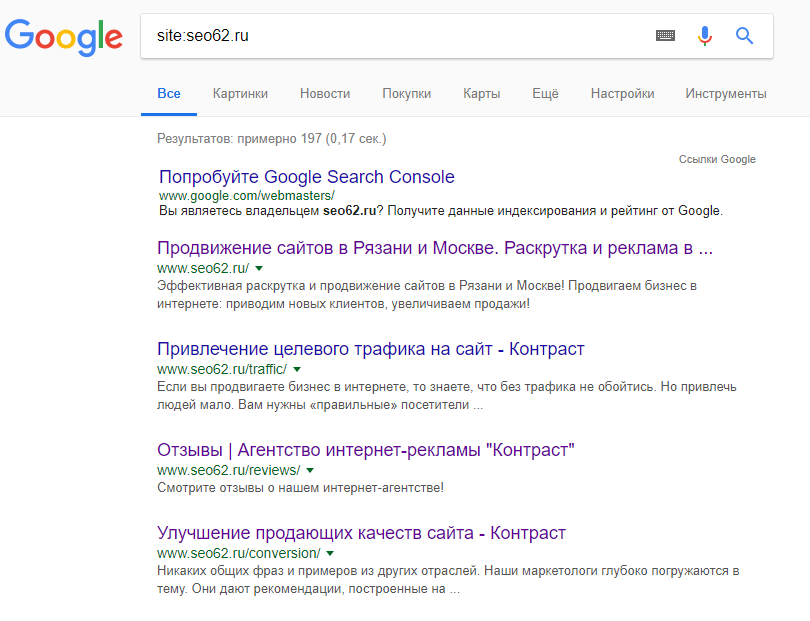

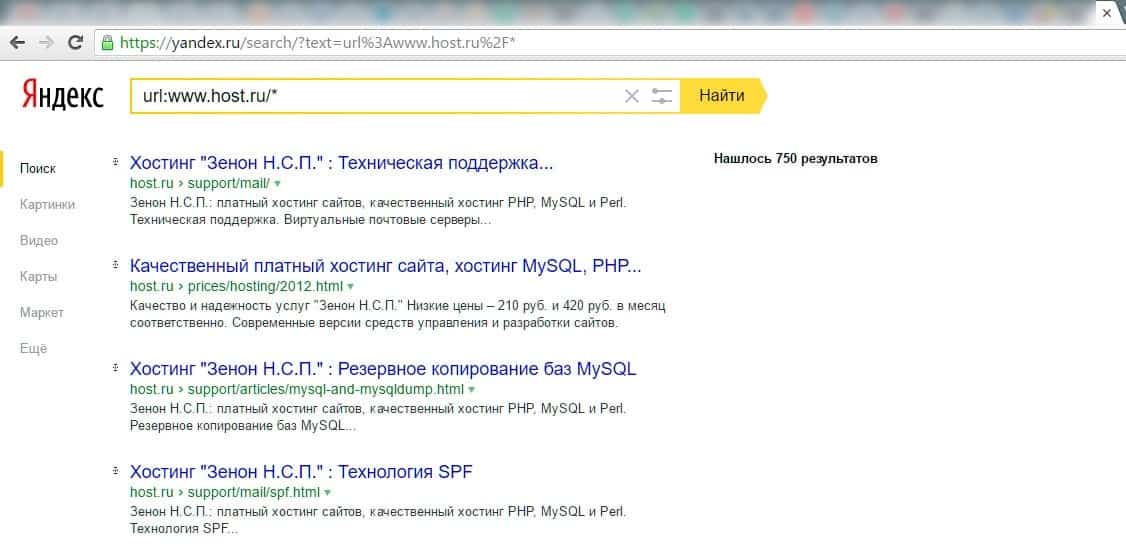

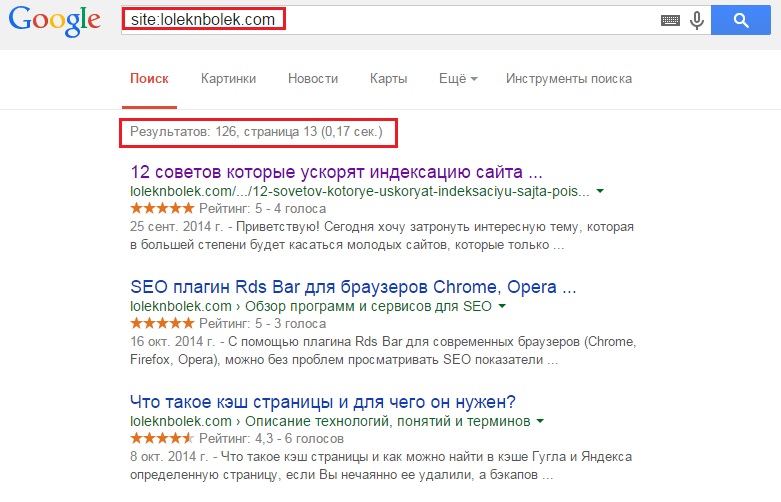

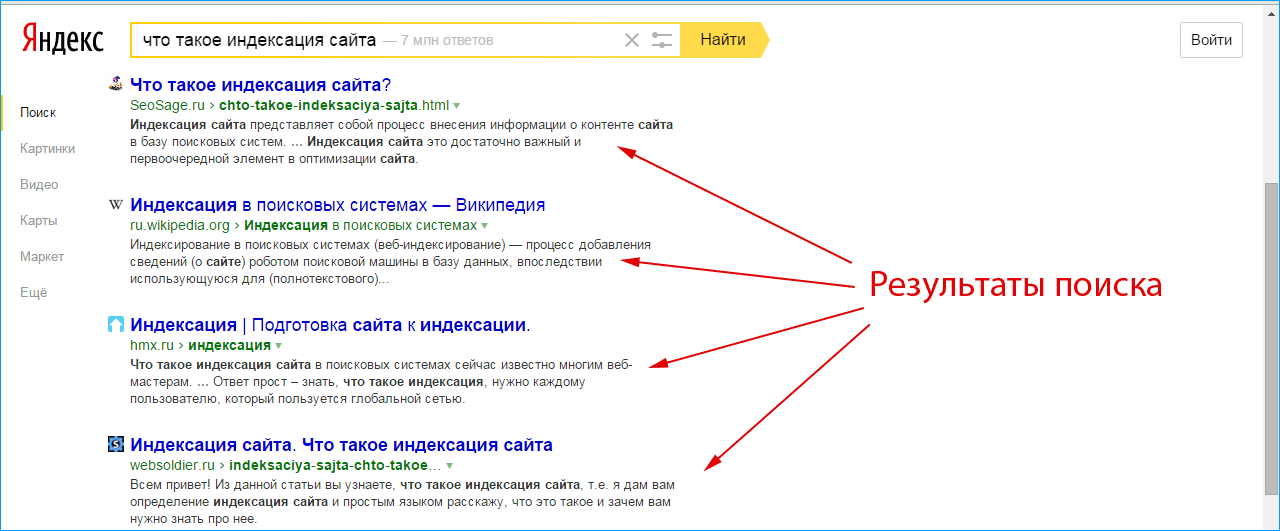

Проверить индексацию сайта можно несколькими способами. Самым простой — в поисковой строке браузера набрать адрес сайта с оператором «site» или «url». Выглядит это вот так: «site: kokoc.com». На скриншоте показан запрос с проиндексированной страницей.

Проверка индексирования в поисковой системе

Если страница еще не вошла в индекс, вы увидите вот такую картину. Проверка в Google производится аналогично.

Страница не проиндексирована

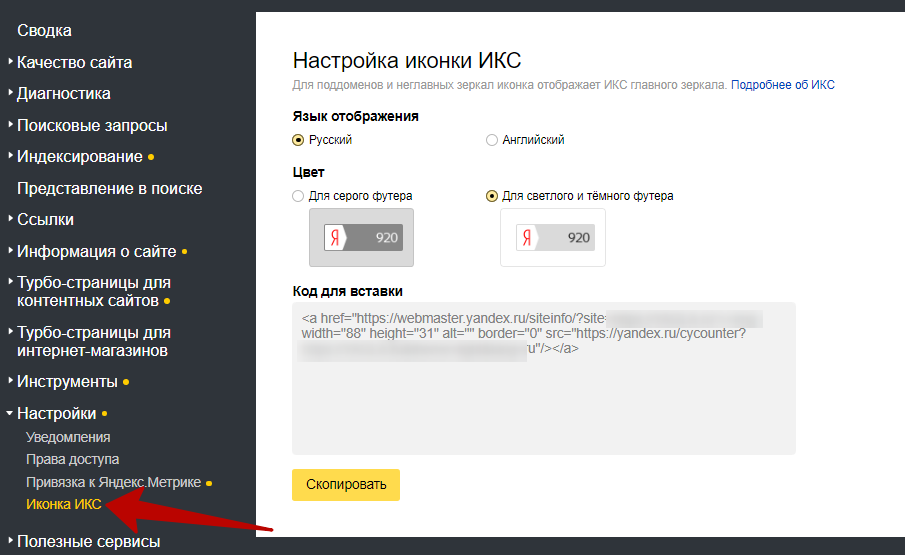

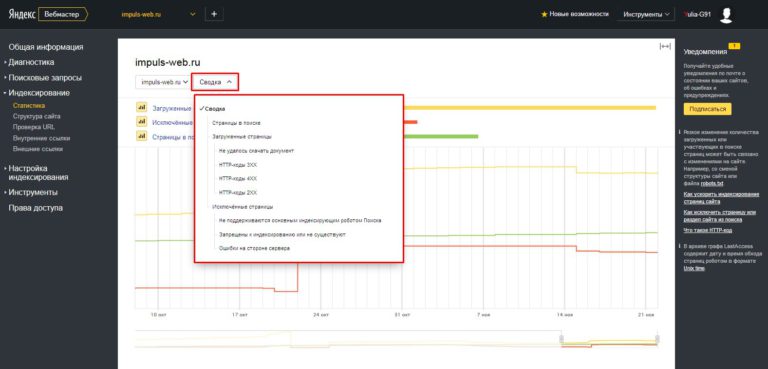

Также можно посмотреть статус документа в «Яндекс.Вебмастер». Для этого находим в меню «Индексирование» и переходим на «Страницы в поиске».

Меню «Яндекс.Вебмастер»

Внизу страницы будут три вкладки. Нас интересуют «Все страницы», там можно увидеть статус документа, последнее посещение и заголовок.

Проиндексированные страницы

Обязательно посмотрите вкладку «Исключенные страницы». Тут вы увидите, какие документы оказались вне поискового индекса. Также указана причина исключения.

Тут вы увидите, какие документы оказались вне поискового индекса. Также указана причина исключения.

Исключенные страницы

При любых сложностях с индексированием в первую очередь следует смотреть конфигурационные файлы robots.txt и sitemap.xml. Если там все в порядке, проверяем, нет ли фильтров, и в последнюю очередь обращаемся к администратору хостинга.

Выводы

Индексация страниц сайта сейчас происходит в самые короткие сроки. При правильной настройке документы могут попадать в индекс поиска уже через полчаса после размещения.

Настройка сводится к созданию правильных конфигурационных файлов и созданию удобных условий для поискового робота для перехода по страницам сайта. Вот какие шаги нужно сделать для правильной индексации:

- Создаем и настраиваем файл robots.txt.

- Генерируем файл sitemap.xml.

-

Регистрируем сайт в сервисах Google Search Console и «Яндекс.

Вебмастер».

Вебмастер».

- Каждый раз после размещения статьи или новой страницы отправляем URL на проверку.

- Используем дополнительные инструменты: размещение ссылок в Twitter и на других трастовых ресурсах.

После этого вероятность возникновения каких-либо проблем с индексированием будет стремиться к нулю. Теперь нужно наращивать позиции в топе — но это уже совсем другая история…

Продвижение сайта в ТОП-10

- Оплата по дням нахождения в ТОП

- Подбираем запросы, которые приводят реальных покупателей!

Что такое индексация сайта и как её проверить — SEO на vc.ru

Чем бы вы ни занимались, интернет-магазином, корпоративным порталом или лендингом, сделать сайт — лишь полдела. Дальше начинается самое интересное — продвижение. Индексация в этом деле — первый шаг на пути к топу поисковой выдачи. Рассказываем о том, как она происходит, как её проверить и ускорить.

Дальше начинается самое интересное — продвижение. Индексация в этом деле — первый шаг на пути к топу поисковой выдачи. Рассказываем о том, как она происходит, как её проверить и ускорить.

28 386 просмотров

Как работает индексация

Продвижение начинается с попадания страниц сайта в индекс поисковых систем (ПС). В эти базы данных Яндекс, Google и другие сервисы заносят информацию о содержимом страниц: использованных на них ключевых словах, размещённом на них контенте и другую информацию. Затем, когда пользователь обращается к ПС с запросом, сервис анализирует собранные данные и подбирает наиболее подходящие варианты ответа из списка проиндексированных страниц.

Как попасть в индекс поисковых систем

Чтобы ваш сайт проиндексировали, о нём нужно сообщить поисковикам. Это можно сделать несколькими способами.

1. С помощью инструментов поисковых систем. Почти у всех поисковиков есть собственные сервисы для веб-мастеров. У самых популярных из них на территории СНГ — Google и Яндекс — это Search Console и Яндекс.Вебмастер. В последнем даже есть специальный инструмент, позволяющий отправлять от 20 ссылок в день на страницы, которые нужно проиндексировать в приоритетном порядке.

У самых популярных из них на территории СНГ — Google и Яндекс — это Search Console и Яндекс.Вебмастер. В последнем даже есть специальный инструмент, позволяющий отправлять от 20 ссылок в день на страницы, которые нужно проиндексировать в приоритетном порядке.

Однако когда речь заходит не о нескольких десятках страниц, а об индексации сайта в целом, более эффективным решением будет добавить его в Яндекс и Google, а затем указать ссылку на карту сайта (файл Sitemap) в Search Console и Яндекс.Вебмастер. Тогда поисковики начнут самостоятельно и регулярно посещать ваш сайт и его новые страницы, чтобы затем добавить их в индекс. О том, как составить карту сайта вы можете узнать в руководстве Google. Что касается скорости попадания в выдачу, она зависит от многих факторов, но в среднем занимает одну—две недели.

2. С помощью ссылок с других сайтов. Быстро обратить внимание поисковых систем на вашу новую страницу можно, разместив ссылки на неё на других порталах. Если один из них будет новостным, скорее всего, страница быстро попадёт в выдачу, так как поисковики часто проверяют такие сайты и ссылки на них считают полезными. В некоторых случаях индексирование может занять меньше суток.

В некоторых случаях индексирование может занять меньше суток.

Попадёт ли страница в поисковую выдачу, зависит от её содержимого. Если с ней всё в порядке, робот проиндексирует её и в скором времени она появится в поисковой выдаче.

Как проверить индексацию сайта

Есть несколько способов узнать были ли проиндексированы нужные вам страницы.

1. С помощью Яндекс.Вебмастера и Search Console. В первом для этого есть специальный инструмент — «Проверить статус URL». Достаточно добавить в него ссылку на нужную страницу, и в течение двух минут (иногда — нескольких часов) вы узнаете о статусе страницы в ПС.

Чтобы проверить статус страницы в Search Console, нужно ввести ссылку на неё в поисковой строке, которая отображается в верхней части экрана. На открывшейся форме вы узнаете, была ли страница проиндексирована поисковиком.

2. С помощью команды «site». Если вы не хотите добавлять сайт в сервисы для веб-мастеров, вы можете проверить сразу все попавшие в индекс поисковиков страницы с помощью специальной команды. Для этого введите в поиск Яндекс или Google запрос вида «site:mysite.ru» (без кавычек), и вы увидите все страницы, попавшие в выдачу.

Для этого введите в поиск Яндекс или Google запрос вида «site:mysite.ru» (без кавычек), и вы увидите все страницы, попавшие в выдачу.

3. С помощью сервисов. Самый простой способ проверить индексацию определённых страниц — воспользоваться для этого сторонними сервисами. Например, Серпхант позволяет проверить индексацию сразу 50 страниц в Яндекс и Google. Введите ссылки на них в специальную форму (не забудьте про http:// или https://) и нажмите «Начать проверку». Иногда инструмент долго выдаёт результаты проверки по одной—двум позициям, но существенно на функциональность это не влияет.

Ещё один сервис — плагин RDS Bar для Chrome, Firefox и Opera — позволяет получить подробную информацию о любой открытой в браузере странице, в том числе и о том, проиндексирована ли она.

Как ускорить индексацию

Чем быстрее поисковые системы внесут страницу в индекс, тем быстрее на неё попадут посетители. Чтобы сократить время ожидания, следуйте следующим рекомендациям:

- Обязательно добавьте сайт в ПС через сервисы для веб-мастеров.

- В Search Console и Яндекс.Вебмастере укажите ссылки на файлы Sitemap и robots.txt.

- Регулярно добавляйте на сайт новый уникальный контент.

- Не забывайте перелинковывать страницы между собой.

- Добавляйте ссылки на новые страницы в социальные сети и на другие сайты.

Как закрыть сайт от индексации

Не все страницы нравятся поисковым системам. Некоторым из них — например, служебным страницам и тем, которые пока что находятся в разработке, — не только нечего делать в выдаче, но и лучше вообще не попадаться на глаза поисковым роботам. Чтобы предотвратить попадание таких страниц в выдачу, лучше сразу запретить их индексацию. Сделать это также можно несколькими способами:

1. Использовать команду Disallow в файле robots.txt. В этом файле указываются правила для поисковых роботов: какие-то страницы в нём можно разрешить индексировать определённым ПС, а какие-то — запретить. Чтобы страница не попала в выдачу, используйте команду Disallow. Подробнее о работе с файлом robots.txt читайте в руководстве Яндекса.

Чтобы страница не попала в выдачу, используйте команду Disallow. Подробнее о работе с файлом robots.txt читайте в руководстве Яндекса.

2. Добавить тег noindex в HTML-код страницы. Наверное, самый простой способ, когда нужно запретить роботу индексацию конкретной страницы или страниц определённого типа. Чтобы воспользоваться им, достаточно добавить в раздел HTML-кода страницы директиву .

3. Использовать авторизацию. Некоторые страницы — например, личный кабинет и «черновики», находящиеся в разработке, — можно закрыть от роботов формой авторизации. Это самый надёжный способ, так как даже те страницы, индексация которых запрещена в robots.txt или директивой noindex, могут попасть в поисковую выдачу, если на них ведут ссылки с других страниц.

Почему индексация веб-сайтов необходима маркетологам

Что вы знаете об индексации веб-сайтов?

Если это почти ничего, вы не одиноки.

Индексация веб-сайта — это не то, что вы делаете как маркетолог, а процесс, который поисковая система выполняет, когда вы публикуете новый контент в Интернете. Что нужно знать маркетологам, так это как убедиться, что вы правильно настроили индексацию для .

Что нужно знать маркетологам, так это как убедиться, что вы правильно настроили индексацию для .

Проиндексированный веб-сайт помогает сайту или странице действительно появляться в результатах поиска — что обычно является первым шагом к ранжированию и созданию трафика.

Теперь, когда мы рассмотрели, почему проиндексированный веб-сайт важен для SEO, давайте рассмотрим, как вы можете подготовиться к индексации своего собственного сайта.

Что значит индексировать ваш сайт?

В двух словах, индексирование веб-сайтов — это процесс, который поисковые системы используют для понимания функций вашего веб-сайта и каждой страницы на этом веб-сайте. Это помогает Google найти ваш веб-сайт, добавить его в свой индекс, связать каждую страницу с искомыми темами, вернуть этот сайт на страницы результатов поисковой системы (SERP) и, в конечном итоге, привлечь нужных людей к вашему контенту.

Подумайте о том, как работает индекс в книгах: это запись полезных слов и информации, которая дает больше контекста по теме. Это именно то, что индексация веб-сайта делает в контексте страниц результатов поисковой системы (SERP).

Это именно то, что индексация веб-сайта делает в контексте страниц результатов поисковой системы (SERP).

То, что вы видите в поисковой системе, — это не Интернет. Это индекс поисковой системы в Интернете. Это важно, потому что не каждая страница, которую вы публикуете в Интернете, гарантированно привлечет внимание поисковой системы. Как владелец веб-сайта, вам нужно сделать несколько вещей, чтобы добавить его в этот индекс.

Google индексирует веб-сайты, содержащие несколько ключевых компонентов. Взгляните на них ниже:

- Соответствует популярным запросам.

- Легкая навигация для создания домашней страницы веб-сайта.

- Ссылки на другие страницы в домене вашего сайта и за его пределами.

- Не быть «заблокированным» от индексации из-за использования определенных метатегов (подробнее об этом позже).

Это потому, что ключевые слова подобны пингу для поисковой системы: они сообщают Google, о чем ваш контент, в нескольких словах, которые могут быть переданы обратно в поисковые запросы.

Наличие ключевых слов — это лишь один из факторов, который Google принимает во внимание перед индексацией веб-сайтов. Другие требования включают в себя отсутствие «битых» страниц или ссылок или сложный веб-дизайн, который мешает пользователю легко найти страницу или понять вопрос, на который отвечает эта страница.

В следующем разделе мы рассмотрим, почему Google учитывает определенные факторы при индексировании веб-сайтов и как проиндексировать ваш веб-сайт.

Индексация веб-сайтов

Индексация веб-сайтов — это процесс, посредством которого поисковая система добавляет веб-контент в свой индекс. Это делается путем «сканирования» веб-страниц по ключевым словам, метаданным и связанным с ними сигналам, которые сообщают поисковым системам, следует ли и где ранжировать контент. Проиндексированные веб-сайты должны иметь удобную для навигации, легко находимую и понятную контент-стратегию.

Наличие проиндексированного веб-сайта гарантирует, что ваш сайт сможет отображаться в результатах поиска. Например, если ваш веб-сайт посвящен сети B2B, наличие таких ключевых слов, как «бизнес для бизнеса» и «сетевое взаимодействие» на вашем сайте, может помочь Google понять, как ваш контент связан с этими поисковыми запросами. Однако имейте в виду, что свежесть контента (насколько недавно он был опубликован), а также то, какие другие страницы ссылаются на него, также играют ключевую роль в способности Google найти и проиндексировать ваш сайт.

Например, если ваш веб-сайт посвящен сети B2B, наличие таких ключевых слов, как «бизнес для бизнеса» и «сетевое взаимодействие» на вашем сайте, может помочь Google понять, как ваш контент связан с этими поисковыми запросами. Однако имейте в виду, что свежесть контента (насколько недавно он был опубликован), а также то, какие другие страницы ссылаются на него, также играют ключевую роль в способности Google найти и проиндексировать ваш сайт.

Теперь, когда вы лучше понимаете, что такое индексация веб-сайтов, давайте обсудим, сколько времени занимает этот процесс и как заставить Google проиндексировать ваш сайт.

Сколько времени требуется Google для индексации веб-сайта?

Google не очень избирательно индексирует веб-сайты. Фактически, он проиндексирует любой сайт, соответствующий критериям.

Хотя это может варьироваться, поиск веб-сайта Google может занять от нескольких дней до нескольких недель. Есть несколько факторов, которые незначительно влияют на скорость индексации веб-сайта Google, например популярность веб-сайта, правильная оптимизация и общая структура веб-сайта.

Распространенные ошибки могут повлиять на индексацию сайта Google.

Для подготовки наберитесь терпения, проверьте дизайн своего веб-сайта и обновите его, если считаете это необходимым.

Рекомендации по индексации веб-сайтов

Ну, во-первых, было бы упущением, если бы мы не предложили вам провести аудит вашего сайта с помощью бесплатного средства оценки веб-сайтов HubSpot. Используйте этот инструмент, чтобы определить основные проблемы SEO вашего сайта и то, как эти проблемы могут повлиять на индексируемость вашего домена.

Далее ознакомьтесь с приведенными ниже советами.

Отслеживание страниц после их публикации.

Как правило, наиболее распространенная причина того, что веб-сайт не индексируется, заключается в том, что он новый. Это может иметь место для вас, особенно если вы рассмотрели свои основы, убедились, что страница не содержит тега «noindex», имеет четкую стратегию ссылок и легко связана с другими страницами на вашем сайте.

Убедитесь, что вы не блокируете индексацию с помощью «noindex».

Сайт с тегом «noindex» заблокирует возможность Google индексировать веб-страницу. Одна из причин, по которой веб-страница может иметь этот тег, заключается в том, что она предназначена для просмотра только определенными подписчиками, поэтому Google не найдет ее и не представит широкой публике в качестве результата поиска.

Создание сканируемых страниц.

Затем убедитесь, что ваш веб-сайт доступен для сканирования. Проверьте, не блокирует ли структура вашего сайта способность индексации поисковой системы. У Google есть контрольный список того, как это сделать, на их веб-сайте поддержки здесь, но несколько общих правил включают создание карты сайта, сообщение Google о дублирующемся контенте и использование специальных тегов, понятных Google.

Настройте перенаправления и отслеживайте трафик после переноса сайта.

Наконец, если вы недавно перенесли свой сайт, это может быть причиной того, что Google не сканирует новый домен. Если ваш сайт был временно недоступен в течение определенного периода времени, возможно, Google обнаружил ошибки сканирования при индексировании вашего сайта и не смог завершить процесс. Вы также должны убедиться, что переадресация 301 настроена для перенаправления трафика со старого домена на новый.

Если ваш сайт был временно недоступен в течение определенного периода времени, возможно, Google обнаружил ошибки сканирования при индексировании вашего сайта и не смог завершить процесс. Вы также должны убедиться, что переадресация 301 настроена для перенаправления трафика со старого домена на новый.

Когда ваш веб-сайт будет готов к индексации Google, вот что вам нужно сделать со своей стороны:

Как проиндексировать ваш веб-сайт в Google

Во-первых, вам необходимо подтвердить свой веб-сайт в консоли поиска Google. Это означает, что вы подтвердите для Google, что вы являетесь владельцем веб-сайта. Затем вам нужно будет запросить у Google сканирование URL-адресов вашего веб-сайта.

Чтобы избежать проблем с миграцией/индексацией, убедитесь, что, если ваш сайт недавно был перемещен, вы соблюдаете рекомендации Google по перемещению сайта, чтобы вы могли убедиться, что ваш новый адрес правильно проиндексирован в поисковой системе.

Помните, что веб-страницы, которые повреждены (очевидно в коде ошибки «404») или трудны для чтения Google, вероятно, не будут проиндексированы.

Кроме того, оптимизация веб-сайта включает добавление ключевых слов на веб-страницы, сообщения в блогах и URL-адреса, а также архивирование содержимого. Наше руководство по SEO — это глубокое погружение в оптимизацию контента веб-сайта, а также освежение знаний для проверки вашей работы перед запросом на индексацию.

Индексация веб-сайта требует немного времени и терпения. Выполнив работу по максимально возможной оптимизации контента веб-сайта перед отправкой запроса в Google, процесс пройдет более гладко.

Темы: SEO

Не забудьте поделиться этим постом!

Как работает индексирование веб-сайтов (и как сделать так, чтобы оно работало лучше)

Дэвид Хантер, генеральный директор Epic Web Studios и ASAPmaps в Эри, штат Пенсильвания. Он также стал соучредителем dbaPlatform, местного программного обеспечения для SEO.

getty

Предположим, вы только что создали самый объективно полезный, увлекательный и блестящий веб-контент. Теперь предположим, что контент остался невидимым и неслыханным, ни разу не появившись в результатах поиска. Хотя это может показаться недобросовестным, именно поэтому вы не можете игнорировать индексацию веб-сайтов.

Теперь предположим, что контент остался невидимым и неслыханным, ни разу не появившись в результатах поиска. Хотя это может показаться недобросовестным, именно поэтому вы не можете игнорировать индексацию веб-сайтов.

Поисковые системы, такие как Google, любят предоставлять хорошие материалы так же, как и вы любите открывать их, но они не могут предоставлять пользователям результаты, которые не были предварительно проиндексированы. Поисковые системы постоянно пополняют свои колоссальные библиотеки проиндексированных URL-адресов, запуская разведчиков, называемых «пауками» или «веб-сканерами», для поиска нового контента.

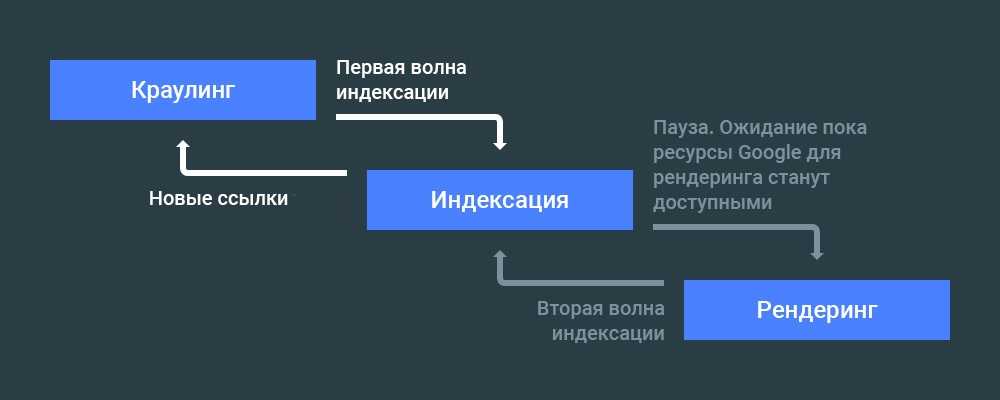

Как поисковые роботы индексируют содержимое

Даже для пауков в Интернете много возможностей для навигации, поэтому они полагаются на ссылки, указывающие им путь от страницы к странице. В частности, они обращают внимание на новые URL-адреса, измененные сайты и мертвые ссылки. Когда поисковые роботы находят новые или недавно измененные страницы, они отображают их так же, как веб-браузер, видя то, что видите вы.

Однако, если вы можете быстро просмотреть содержимое в поисках нужной информации, поисковые роботы работают гораздо тщательнее. Они масштабируют страницу вверх и вниз, создавая индексную запись для каждого уникального слова. Таким образом, на одну веб-страницу могут ссылаться сотни (если не тысячи) записей указателя!

ДОПОЛНИТЕЛЬНО ДЛЯ ВАС

Знакомство с поисковыми роботами

В любой момент времени в Интернете могут сканировать сотни различных поисковых роботов, как хороших, так и плохих (например, тех, кто пытается очистить каталоги электронной почты или собрать личную информацию). для рассылки спама). Но есть несколько, о которых вы хотите знать особенно.

• Googlebot (Google)

• Bingbot (Bing)

• Slurp (Yahoo)

• Facebot (внешние ссылки Facebook)

• Искатель Alexa (также известный как ia_archiver, для Alexa Amazon)

2 Robots.txt и метадирективыМогут быть ситуации, когда вы не хотите индексировать определенные страницы, например:

отправка формы, страница с промокодом)

• Те, которые предназначены только для внутреннего использования (в целях тестирования или подготовки).

• Те, которые содержат личную или личную информацию.

Более того, Googlebot и другие известные поисковые роботы имеют встроенные бюджеты сканирования — они будут сканировать только определенное количество URL-адресов. на вашем сайте, прежде чем двигаться дальше (хотя следует отметить, что краулинговые бюджеты на 90 007 больше, чем на 90 008 по сравнению с тем, что было раньше).

Таким образом, как администратор сайта, вы хотите не только установить некоторые правила, но и установить некоторые приоритеты (оптимизация бюджета сканирования). Есть два основных способа сделать это: файлы robots.txt и метадирективы.

Robots.txt

Файл robots.txt сообщает поисковым роботам, где они должны и не идти на ваш сайт, хотя не все из них будут слушать. Чтобы получить к нему доступ, просто добавьте /robots.txt в конец вашего URL-адреса (если ничего не появляется, значит, у вас его нет). Базовый синтаксис инструкции robots. txt очень прост:

txt очень прост:

1. Пользовательский агент: [вставьте имя пользовательского агента (т. е. сканера/паука/бота, которому вы хотите из всех оставьте звездочку *)]

2. Запретить: [вставьте строку URL, которую вы не хотите, чтобы поисковый робот посещал — можно использовать отдельную обратную косую черту, чтобы указать определенным поисковым роботам вообще не сканировать ваш сайт ]

«Запретить» — наиболее распространенная инструкция. вы укажете в robots.txt, но вы также можете предложить «Crawl-Delay» (количество миллисекунд, которое сканер должен ждать перед загрузкой указанного URL-адреса), «Разрешить» исключение в строке запрещенного URL-адреса (только Googlebot ) или отправьте файл «Sitemap» в формате XML, содержащий наиболее важные URL-адреса вашего веб-сайта — ключ к оптимизации краулингового бюджета.

Мета-директивы

Мета-директивы роботов (также известные как метатеги) сообщают поисковым роботам, что они могут и не могут делать в отношении индексации, хотя, опять же, вредоносные боты могут их игнорировать. Поскольку это прописано в коде веб-страницы, это скорее требование, чем предложение. Используя различные параметры, администраторы веб-сайтов могут точно настроить, будет ли страница индексироваться (и как долго), будут ли переходить по ее ссылкам, может ли поисковая система извлекать фрагменты и многое другое.

Поскольку это прописано в коде веб-страницы, это скорее требование, чем предложение. Используя различные параметры, администраторы веб-сайтов могут точно настроить, будет ли страница индексироваться (и как долго), будут ли переходить по ее ссылкам, может ли поисковая система извлекать фрагменты и многое другое.

Индексируется ли ваш сайт?

Вот наиболее распространенные причины, по которым ваш сайт может не индексироваться:

• Ваш файл robots.txt или метатеги блокируют поисковые роботы.

• Это совершенно новый сайт — например, Googlebot может индексировать новый сайт от нескольких недель до месяцев, в зависимости от его размера.

• На него нет ссылок из других источников в Интернете.

• Навигация по сайту затруднена.

• Ваш сайт был помечен как черный метод SEO.

Как сделать ваш сайт более доступным для сканирования

Вот несколько способов улучшить индексирование вашего сайта.

Будьте организованы.

Поскольку ссылки являются основным способом перемещения сканера, убедитесь, что на вашем сайте есть четкие пути навигации. Если вы хотите, чтобы что-то было проиндексировано, ссылка на него обязательно должна быть где-то еще на сайте — как минимум из главного навигационного меню, но в идеале — с других релевантных связанных страниц по всему сайту.

Уменьшение препятствий.

Старайтесь не прятать важный контент за логинами, формами и опросами. Сканеры не могут читать текст внутри изображений, видео и GIF-файлов, поэтому обязательно применяйте замещающий текст к медиафайлам. Навигационные меню, написанные не на HTML (например, на JavaScript), также не видны паукам.

Отправить карту сайта.

Свяжите свою карту сайта с файлом robots.txt и отправьте через Google Search Console. В панели управления Search Console владельцы сайтов могут указать, как они хотят, чтобы робот Googlebot сканировал их страницы.