Тошнота текста — что это и какие должны быть нормы?

Привет всем начинающим авторам! Сегодня я познакомлю вас с ещё одним интересным понятием из мира копирайтинга и продвижения – заспамленностью (переспамом). Если вы хотите заниматься SEO-оптимизацией сайтов или писать крутые статьи, то садитесь поудобнее и готовьтесь узнать, что такое тошнота текста.

Никто из нас не рождается опытным копирайтером. Когда я впервые увидела в ТЗ “тошнота не более …%” — испугалась. А что это? Вдруг получится больше, чем надо? Как уменьшить? — эти страхи сильно тормозили выполнение работы.

Сейчас я без проблем набиваю текст без переспама. Проверяю только в конце, результатом остаюсь довольна без серьёзных правок. Годы за печатным станком не прошли даром.

Термин “тошнотность” ввели в 2006 году. Тогда начал меняться подход поисковых систем к контенту. Раньше можно было напичкать текст ключевыми словами через каждое предложение и он попадал на вершину топа поисковиков. Теперь же нужно писать для людей — кратко, понятно, полностью отвечать на вопрос.

Тошнота — это количество употреблений слов относительно всей статьи. Считается в процентах. Например, если слово “пластик” встречается 35 раз в работе объёмом 3 000 символов, уровень переспама по слову будет 11 %.

Здесь я научу вас работать с показателем, доводить его до нормы.

В комментариях вы можете поделиться своим опытом работы с заспамленностью.

Виды

Некоторые сервисы проверяют тексты на несколько видов тошнотности.

На практике есть 2 типа заспамленности:

- Классическая тошнота — корень квадратный от общего количества употреблений слова в статье. Допустим, “поезд” вы написали 25 раз в статье, какой будет показатель? Правильно, 5. Заказчики редко требуют соблюдать её.

- Академическая тошнота — отношение часто употреблённых слов к объёму работы. Помните, как в школе мы узнавали пропорционально количество процентов или предметов с одной неизвестной? Здесь всё так же. Если “кондитер” встречается 7 раз в 5 000 символах, то тошнотность будет равна 7*100/5 000 = 14 %.

Соблюдение этих показателей помогает сайту быстрее выйти в ТОП поисковой выдачи и избежать фильтра Баден-Баден в Яндексе.

Норма заспамленности

Никто не знает на 100 %, какой должна быть тошнотность, чтобы сайт не попал в чёрные списки поисковиков. Примерная норма вычислялась методом тыка. Оптимизаторы анализировали контент самых успешных сайтов, копирайтеры вычитывали и предлагали разные варианты.

Какая должна быть тошнота в идеале:

- Академическая — в пределах 7 — 9 % по Адвего, до 45 % по Текст.ру и не более 7 % на Миратексте.

- Классическая — не более 7 %. Менее 2,7 % у вас не получится, даже если слово употреблялось 6 раз, корень будет извлекаться из 7.

Для проверки качества текста на глаз можно анализировать страницы конкурентов.

Перечитывайте свою работу. Если она слишком объёмная, делайте перерывы. Чем дольше вы сидите над статьей, тем больше тавтологии получится.

Как понизить академическую тошноту?

Во время чтения статьи поняли, что с ней что-то не так? Проверили на заспамленность и получился высокий показатель? Нужно срочно избавляться от слов-повторюшек.

Чтобы академическая тошнота была допустимой, можно:

- Заменить или убрать высокочастотные слова/фразы

Воспользуйтесь сервисами подбора синонимов, например, Орфограммкой или синонимайзером. Следите, чтобы они не выходили из контекста. Если много стоп-слов, их лучше убрать, перестроив предложение. Удалив их, вы понизите водность. Как проверить воду в тексте — узнаете в следующей статье.

- Увеличить размер текста

Не всегда уместно. Если вас попросили написать описание товара для интернет-магазина до 1 000 символов, вы не сможете растянуть его до 5 000. Посмотрите, сколько ключей попросил вписать заказчик. Не более 5? Нормально. В других случаях снизить заспамленность и соблюсти ТЗ — невозможно.

Тошнотность не бывает нулевой.

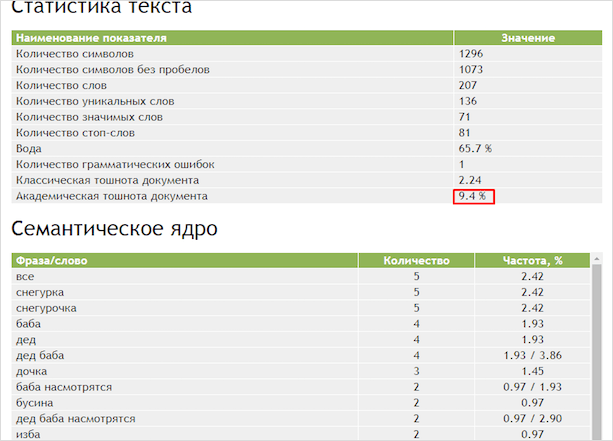

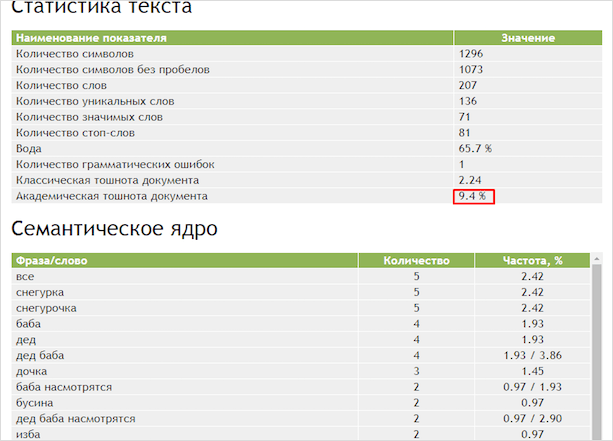

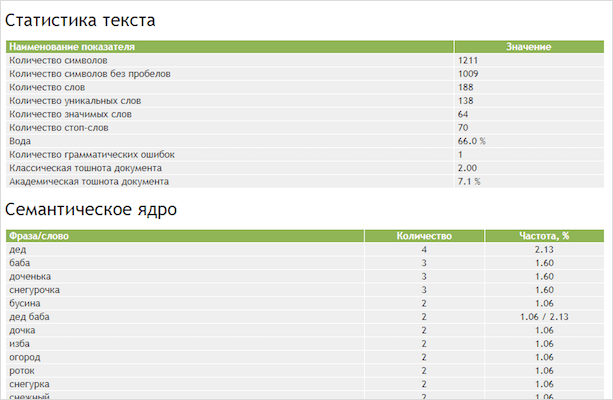

Теперь хочу на практике показать, что методы работают. Для примера возьму отрывок из народной сказки “Снегурочка”. Анализ буду делать через Адвего. Что поделать, привыкла к нему.

Результат для SEO ужасен — 9,4 %. Попробуем с помощью замены, перестройки предложений уложиться в 8 %, сохранив смысл.

Из таблицы семантического ядра узнаём, что переспам вызван частым употреблением слов “все”, “снегурка”, “баба”, “в”, “и”, “а”.

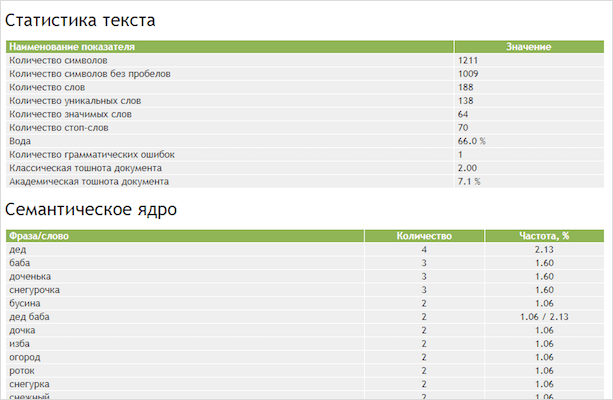

Мне удалось понизить тошнотность до 7,1 %. А по слову она теперь не превышает 2,5 %.

Что я сделала? Удалила слова, изменила предложения.

Оптимизация сказкам не нужна. Мы любим их не за это. В народных сказках одни и те же слова встречаются часто, вот и взяла для примера.

Как уменьшить классическую тошноту?

Она измеряется по самому популярному слову в статье. Нельзя употреблять одно и то же слово более 15 раз.

Как снизить классическую тошноту:

- Сократить количество повторяющихся слов

Посмотрите на таблицу семантического ядра. То слово, которое видите на первом месте, нужно убрать. Сервис для проверки на тошноту подскажет, как сделать лучше.

- Уберите стоп-слова

Тошнотность может подлетать до небес из-за союзов — “по”, “для”, вводных конструкций — “конечно”, “к примеру”, “однако”. Они не красят текст, их уменьшают для читабельности.

Чем больше статья, тем выше классическая тошнота получается.

Как бы не хотелось написать одно и то же слово снова, старайтесь останавливать себя. Иначе конечная проверка разочарует.

Что делать, если тошнотность слишком маленькая?

Думали, что только переспам заставляет опуститься страницы на дно поисковиков? Нет. Если тематических слов будет недостаточно, поисковый робот подумает, что статья не отвечает запросу. А ключи и вовсе попали туда случайно.

Как повысить тошноту? Единственный способ — добавить еще 2 — 5 вхождений, в зависимости от размера статьи.

Где проверить на заспамленность — подборка лучших сервисов

Можно проверить текст на тошноту самостоятельно. При вычитке лишние слова портят впечатление о статье, создают впечатление лишнего.

Но перечитав 4 — 5 работ, вы начнёте пропускать ошибки. Почему? Снижается внимание, вы привыкаете к переизбытку одних и тех же слов.

Если вы усидчивый человек, любящий математику, то можно рассчитать заспамленность по формуле:

ЧС/ЧЗ*100 = Т%, где

ЧС — частота слов,

ЧЗ — общее число знаков,

Т% — тошнота в процентах.

У копирайтера не так много времени, чтобы тратить по 3 — 5 часов на проверку одной работы. Легче воспользоваться онлайн-сервисами, программами.

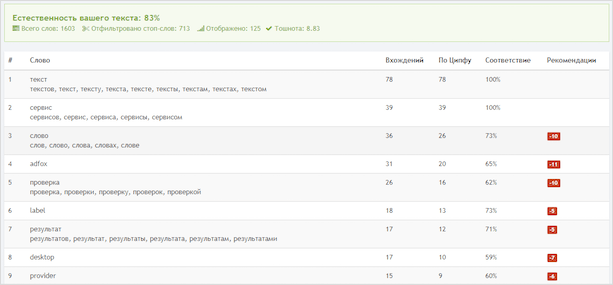

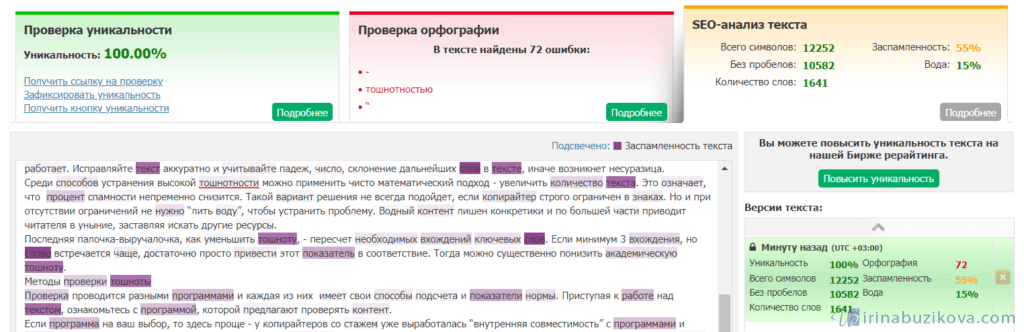

Для наглядности я буду делать анализ одного и того же текста, страницы сайта.

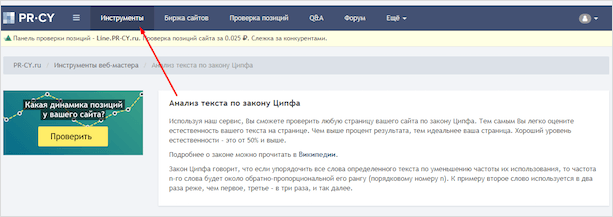

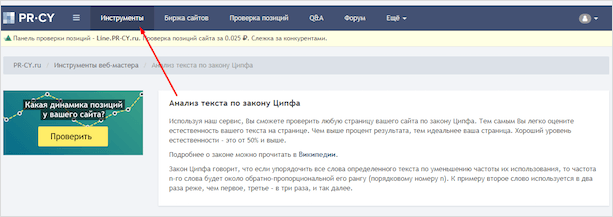

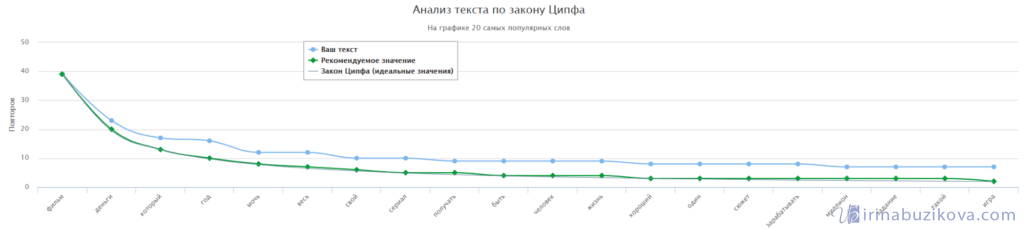

PR-CY

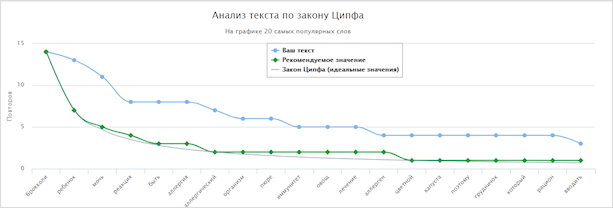

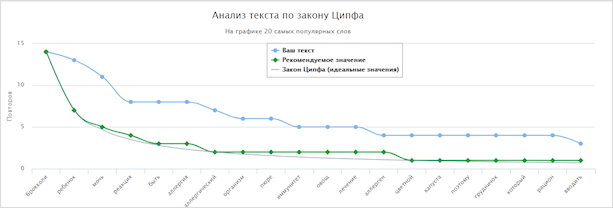

Документ анализируется по закону Ципфа. Согласно ему положение слова пропорционально его месту в тексте. Например, “компот” будет стоять на 2 месте, если оно встречается в два раза реже.

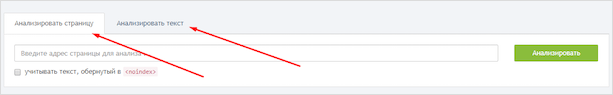

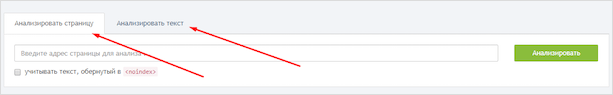

Чтобы перейти в раздел проверки, нужно на главной странице на панели кликнуть “Инструменты”. Там выбираем “Анализ Ципфа”.

Вы можете отправить на проверку готовую страницу сайта или документа. Просто вставьте статью в пустое поле. Максимальное количество знаков — 15 000, минимальное — 100.

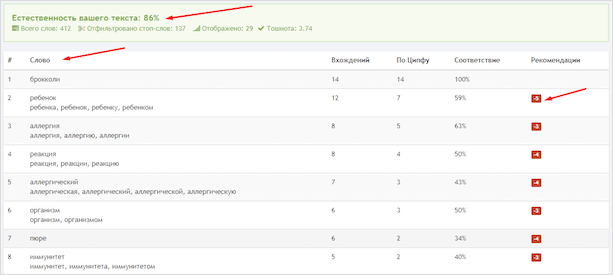

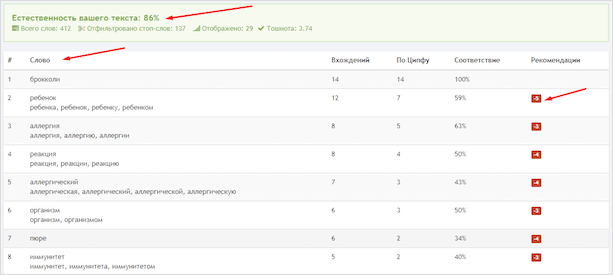

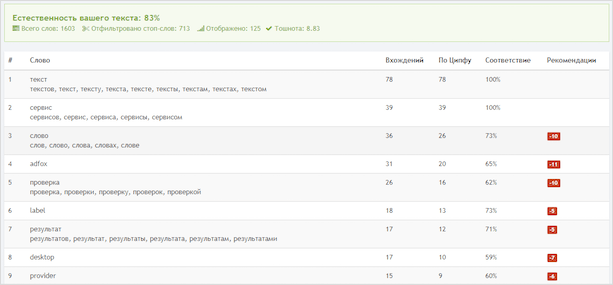

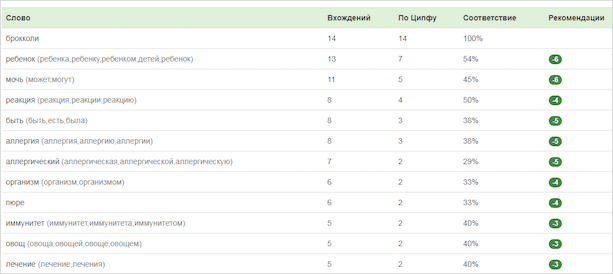

Я получила такой результат. Тошнота до 7 % — отлично. Естественность для поисковиков хорошая. Квадратики показывают рекомендации. Красные — уменьшите количество указанного слова, зелёные — добавьте.

Я решила не останавливаться на достигнутом и проверила готовую страничку сайта.

Заспамленность зашкаливает. На первых позициях какие-то непонятные словечки из меню.

Показатели по Ципфу страницы и статьи — разные. Когда анализируется сайт, учитываются не только слова из вашей работы, но и всё, что видимо для пользователя — “Контакты”, “О компании” и др. Добиться нужных результатов сложней.

Я некоторое время работала в офисе копирайтером. Меня гоняли по этому показателю. Мне казалось нереальным выбить в первую десятку необходимые слова по странице. Уходило по 3 — 4 часа на работу в 2 000 — 2 500 символов. Но с опытом стало проще.

Удобная навигация, подробная статистика — хороший сервис, которому можно доверить текст.

Text

Оказывается, уровень переспама оценивают и по Текст.ру. Во время работы в компании я отталкивалась от этих показателей.

До 50 % норма, но требовательные заказчики просят не более 40 %.

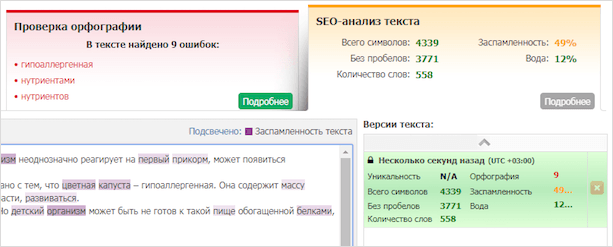

Чтобы проанализировать документ, переходим по вкладке “SEO анализ”, вставляем его в рабочую область, нажимаем “Проверить SEO-данные”.

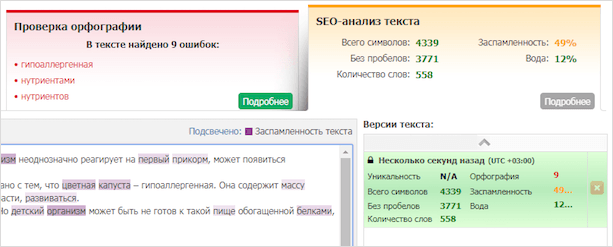

Тошнотность 49 % — не очень. Тёмно-фиолетовым выделены слова с высокой частотностью: “ребёнок”, “брокколи”. Бледные — низкочастотные: “белок”, “развиваться”.

Подробная статистика помогает быстро очистить статью от тавтологии. Правда, ждать ответа от сервиса приходится долго. Адвего, PR-CY работают шустрее.

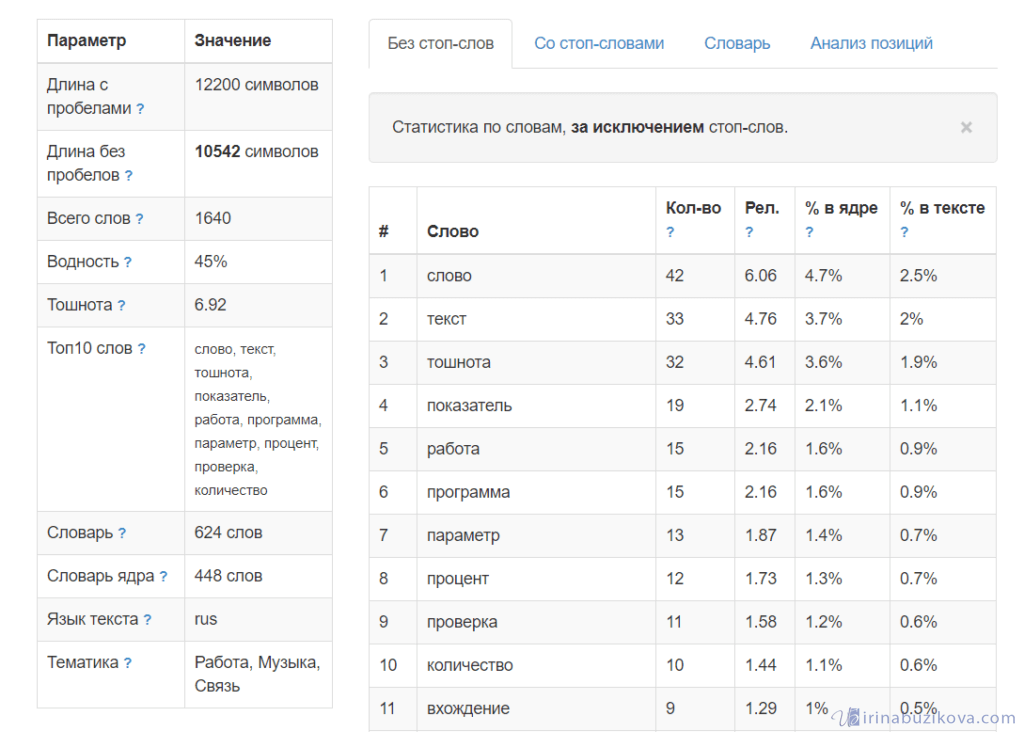

Адвего

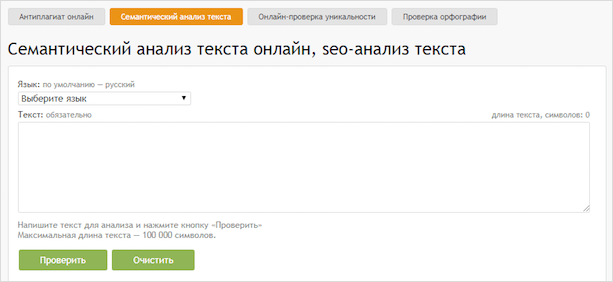

Адвего — ветеран по проверке семантического ядра. Большинство заказчиков просят равняться по его показателям. Анализ не требует установки ПО, результаты выдаёт за несколько секунд.

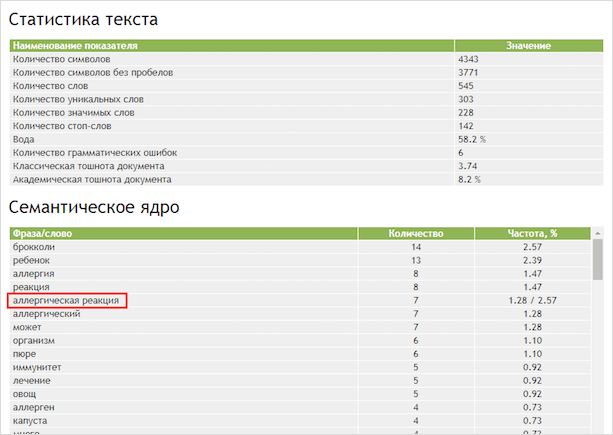

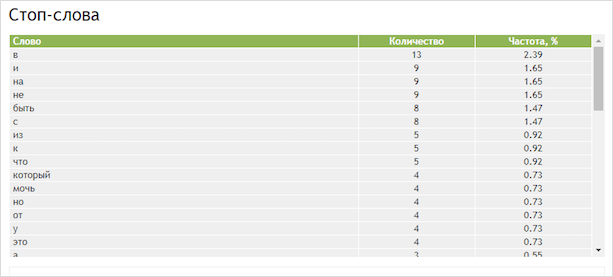

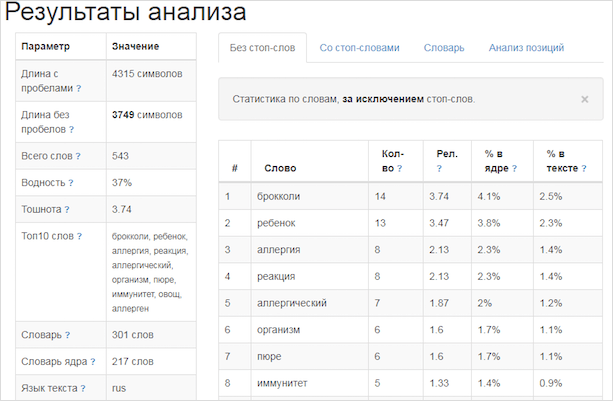

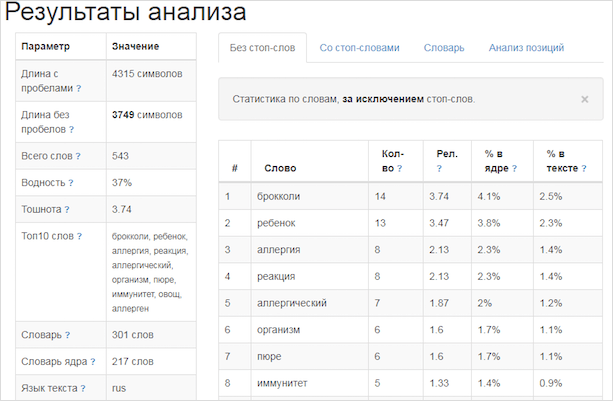

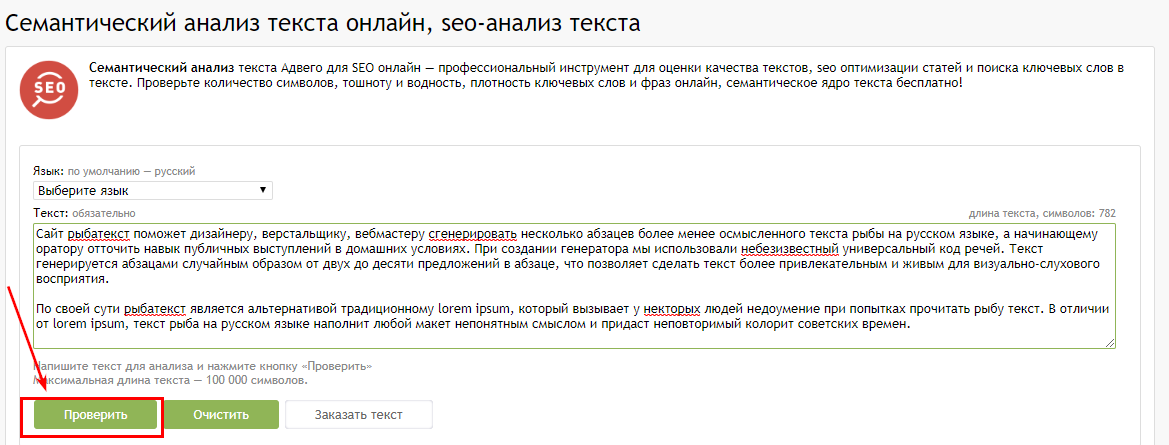

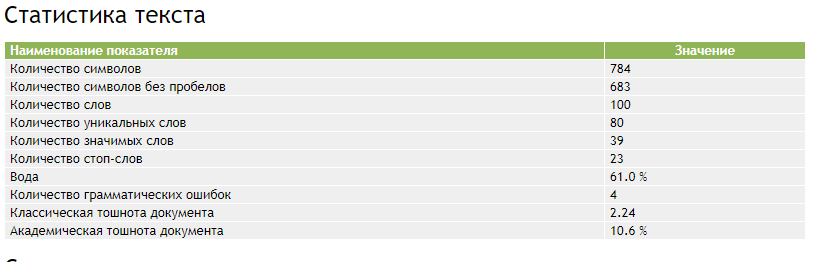

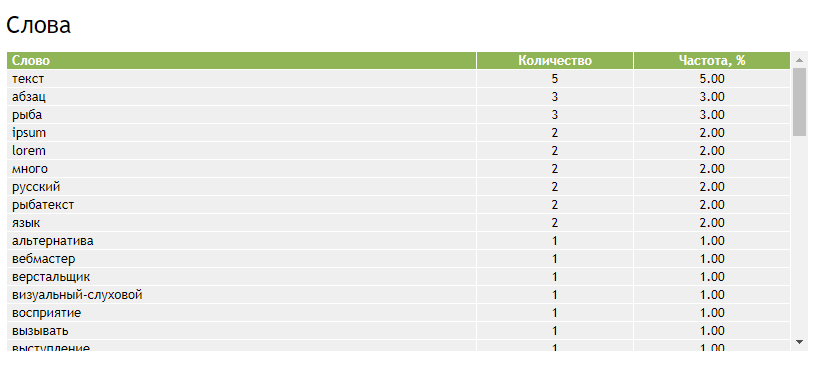

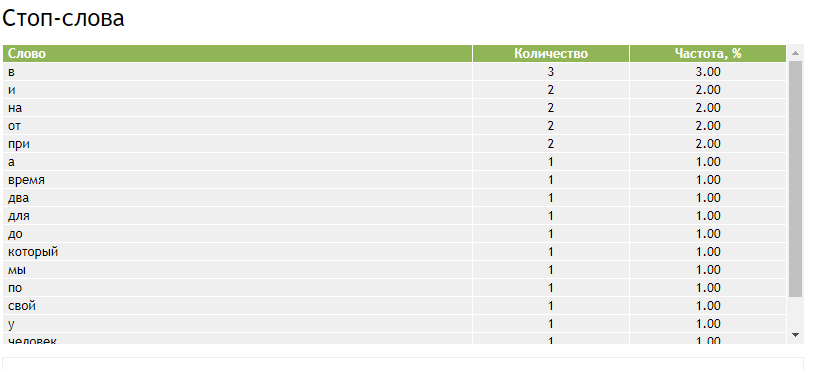

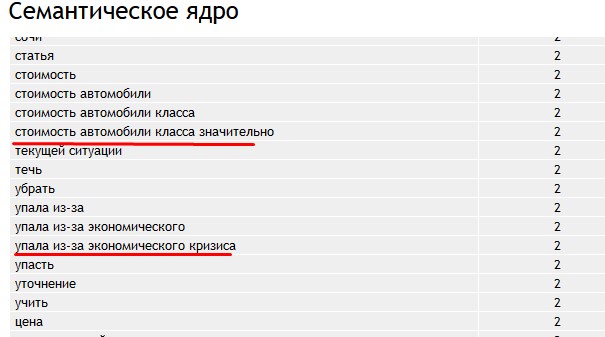

Как узнать заспамленность? Сейчас разберёмся. Заходим сразу в семантический анализ текста Advego, чтобы долго не блуждать по сайту. Вставляем текст, запускаем проверку нажатием кнопки внизу.

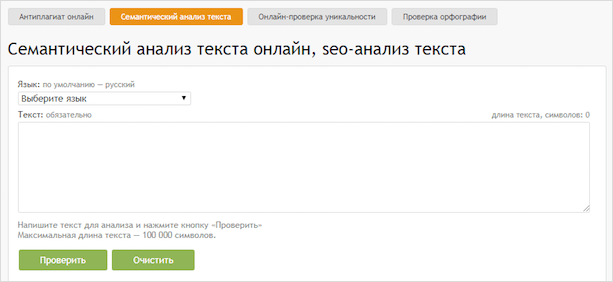

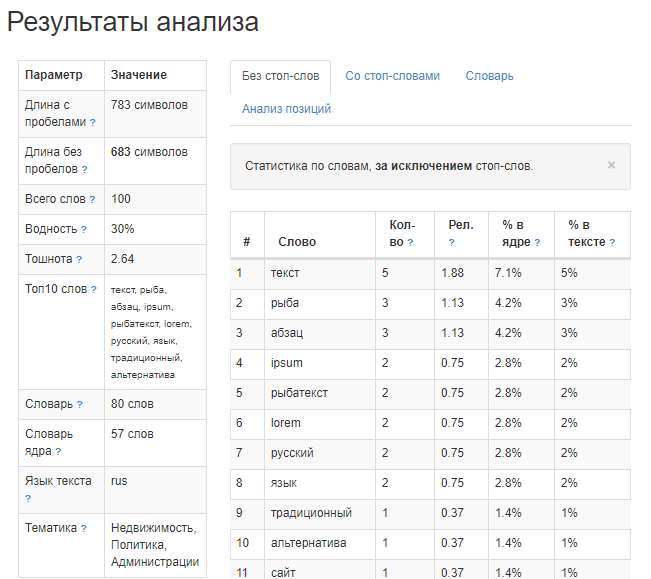

Академическая тошнота 8.2 %, классическая — 3.74. Приемлемо, но могло быть лучше.

Если фраза повторяется 3 — 4 раза, она отражается в семантическом анализе целиком.

Ниже мы видим количество стоп-слов.

Это текстовый мусор, по возможности удаляем лишнее.

Люблю Advego, полагаюсь на него. Никогда не подводил.

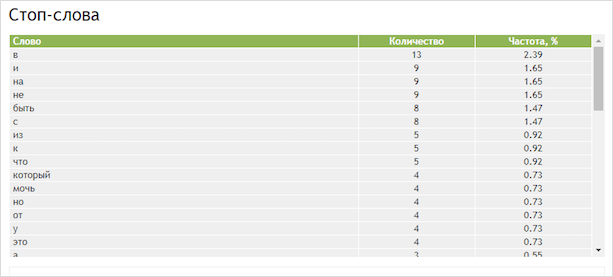

Istio

Istio не хуже Адвего, просто не популярен. Даже разница в показателях на сотые.

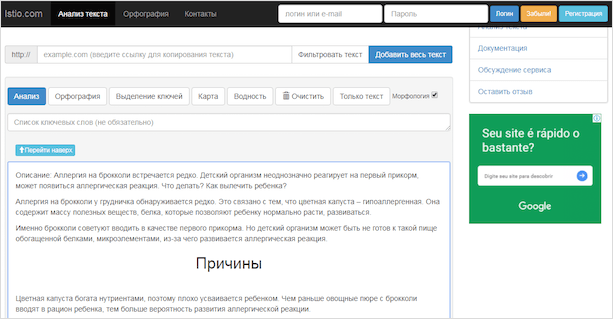

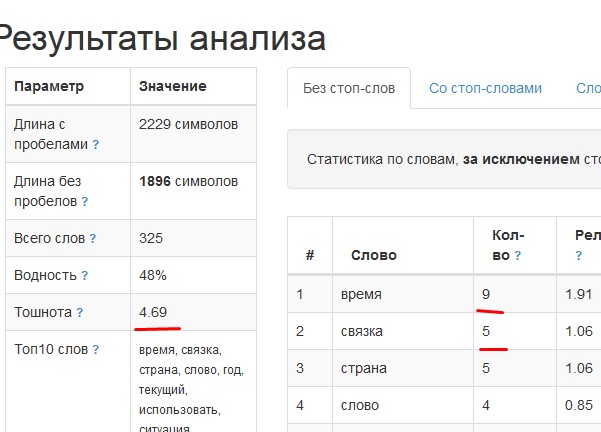

Выбираем вкладку “Анализ текста”, вставляем текст в рабочую область, запускаем проверку, нажав на синюю кнопку “Анализ”.

Хотите знать число вхождений ключевых слов, их расположение? Вводите ключи через запятую в строку над кнопками.

Мне показало тошнотность без предлогов, вводных конструкций. Если вы хотите узнать полную статистику, выбираете вкладку “Со стоп-словами”.

Сервис работает быстрее Advego. Есть все необходимые инструменты для копирайтеров и заказчиков.

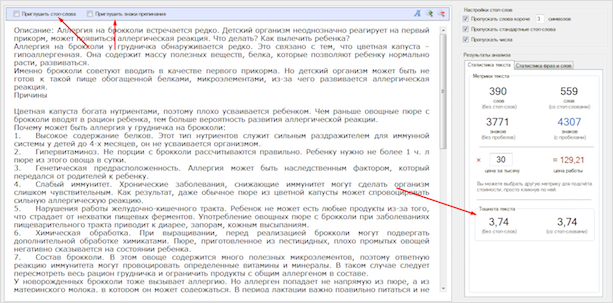

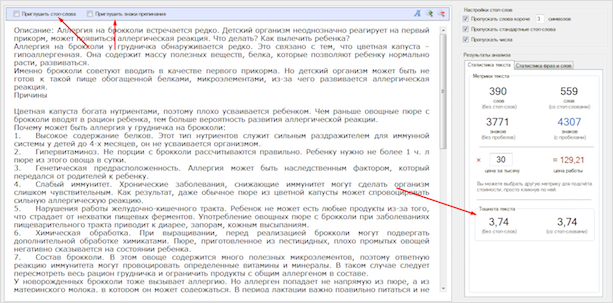

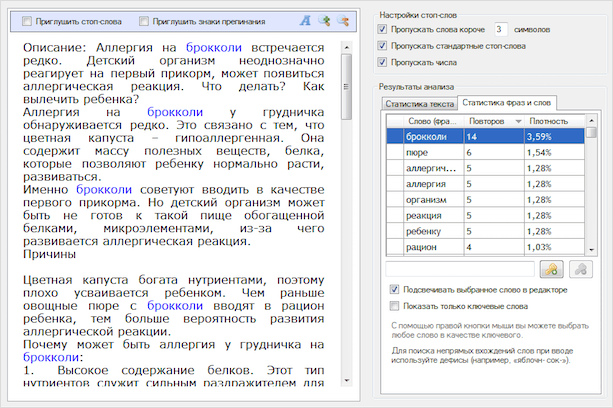

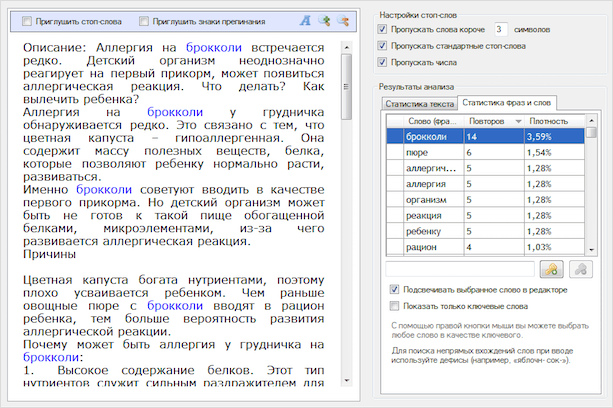

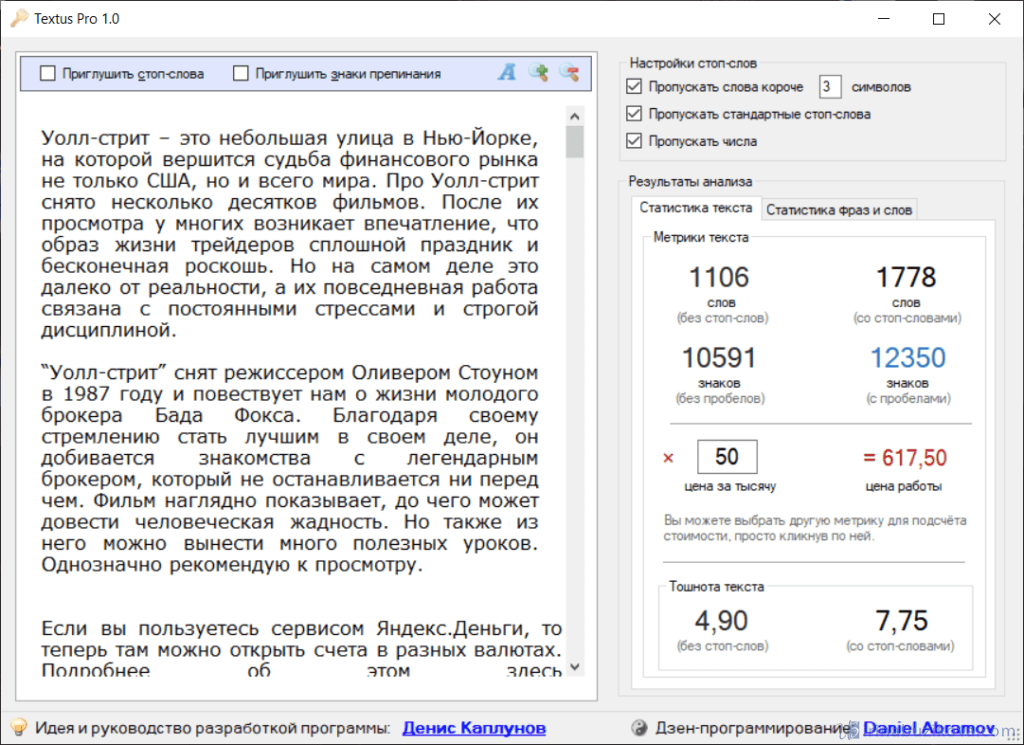

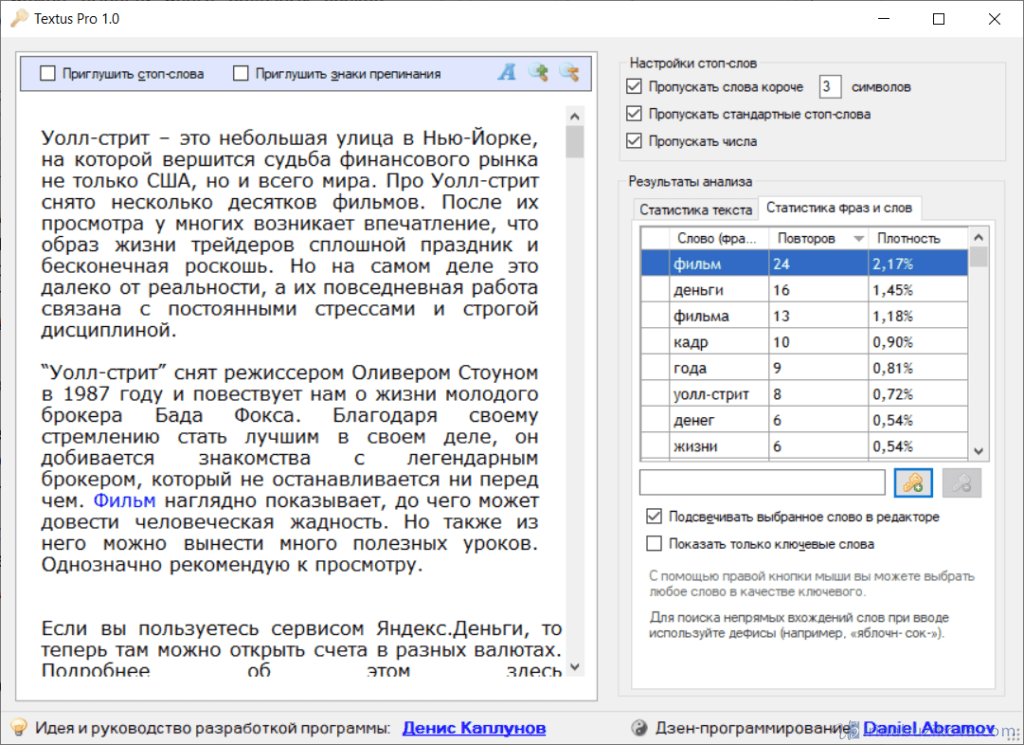

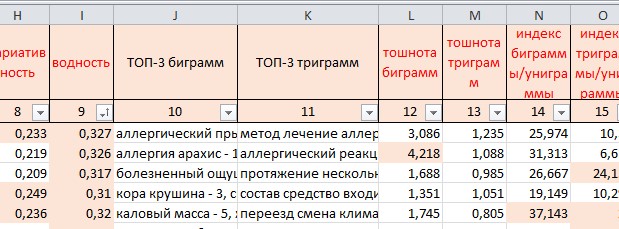

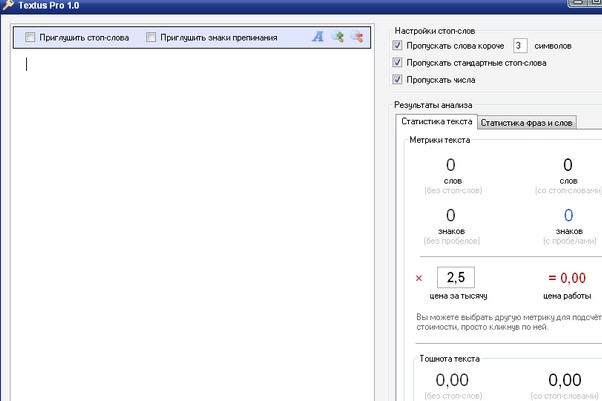

Textus PRO

Хотите иметь SEO-помощника под рукой? Надоело постоянно открывать онлайн-сервисы? Тогда ПО Textus PRO — ваш вариант. Скачиваете установочный файл. Он весит 600 Кб, ставите на ПК за 2 минуты.

Активируете после установки, кликнув на ярлык рабочего стола. Интерфейс программы прост. Вставляете текст, сразу получаете готовый результат.

Высокая заспамленность? Будете редактировать? Для удобства можно поставить галочки вверху. Они замажут стоп-слова, знаки препинания, которые отвлекают вас.

Справа находится подробная статистика. Показана классическая тошнота. Проверка настраивается. Есть возможность отключить подсчёт чисел, стоп-слов.

Можно заранее рассчитать стоимость работы. В строке “цена за тысячу” указываете расценку, программа сама всё умножает.

Статистика фраз и слов помогает узнать количество точных вхождений — видны в таблице. Они подсвечиваются синим. Если показатели не соответствуют ТЗ, с лёгкостью заменяйте их на синонимы, убирайте.

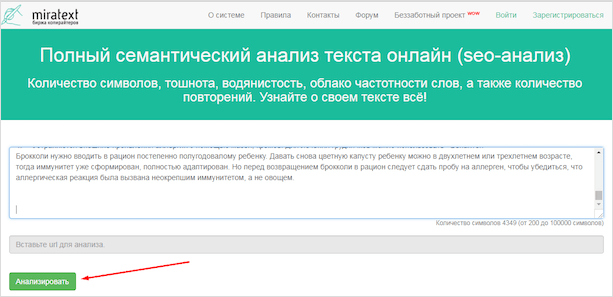

Miratext

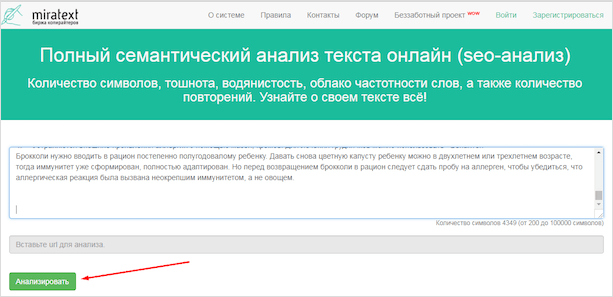

Долгое время не догадывалась, что у Миратекст есть собственный сервис проверки. Так хорошо его спрятали. Искала в поисковиках. Чтобы вы не накручивали круги в поисках этого инструмента, даю ссылочку на семантический анализ текста от Миратекст.

Мы можем проанализировать документ, целую страницу сайта. Миратекст ведёт статистику по закону Ципфа, более сложной версии проверки на заспамленность.

Вводим текст, нажимаем на кнопку.

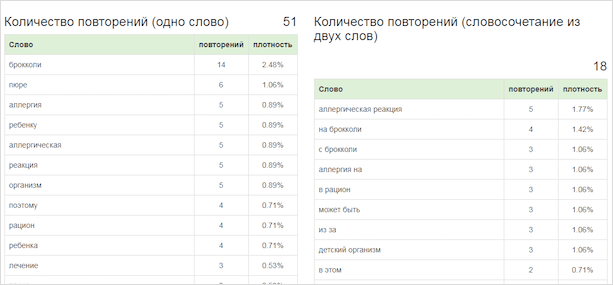

Получаем подробный результат.

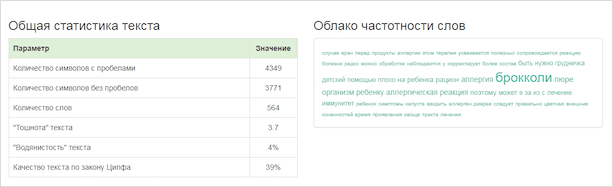

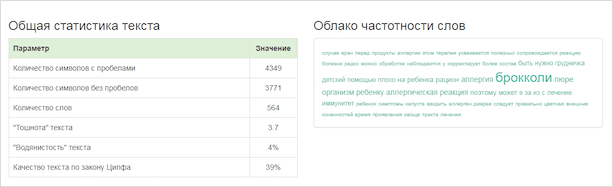

Вверху простенькие, обобщённые данные — тошнота, число знаков, естественность текста по Ципфу для поисковых систем.

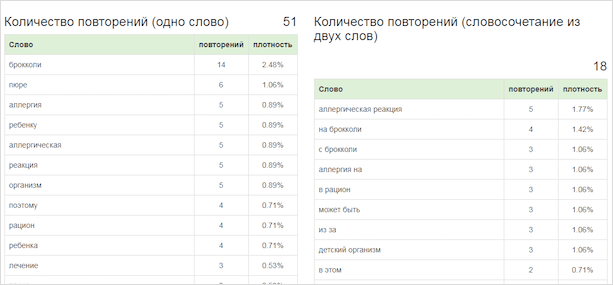

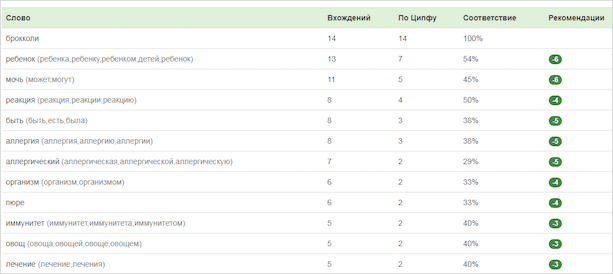

Далее идёт подробная статистика по словам и фразам. Смотрим всё ли нормально? Удаляем высокочастотные, поднимаем в списке низкочастотные.

Моё любимое — ТОП 20 самых употребимых слов. Для оптимизации сеошники просят копирайтеров, чтобы в десятку попали тематические ключи. Для сайта про двери нужно вывести в лидеры “двери”, “межкомнатные”, “входные”, “купить”, “цена”, “интернет-магазин”, “каталог” и т. п.

Ниже показаны рекомендации. Можем прислушаться к ним или нет, катастрофы не будет.

Как писать без переспама сразу?

Ох, эта тошнотность. Пишешь-пишешь, проверяешь онлайн, а потом ещё 2 часа правишь.

Чтобы не делать работу над ошибками, следите за потоком слов. После каждого 4 предложения задумайтесь — не повторяетесь ли вы.

Избежать заспамленности помогают перерывы, чтение книг. Читайте любую литературу — художественную, узкоспециализированную. Вы отвлечётесь от темы, в голове родятся новые фразы.

Чтобы не тратить драгоценные минуты своего времени на анализ текста, советую пройти обучение копирайтингу. Вы научитесь писать красивые, полезные статьи без переспама.

Заключение

Тошнота текста — важный показатель. Никогда не шутите с ним. Для копирайтеров переспам закончится доработками и отказами, а для вебмастеров, владельцев сайтов — выходом из поисковой выдачи.

Проверяйте статью по семантике в ходе работы, если чувствуете неестественность, или оставляйте это напоследок. Уменьшить, увеличить тошнотность можно всегда. Главное — вовремя на это обратить внимание.

Дорогие копирайтеры, на этой ноте я прощаюсь с вами. Пишите в комментариях своё мнение о переоптимизации текстов.

Если вам нравится изучать мир SEO и копирайтинга вместе с нами, подписывайтесь на блог. До встречи!

Тип текста: Любой Копирайтинг Рерайтинг без источника Перевод

Язык: Любой Russian — РусскийEnglishGermany — DeutschSpanish — EspañolFrench — FrançaisChinese — 中国Ukrainian — УкраїнськаJapanese — 日本のPortuguese — PortuguêsPolish — PolskiItalian — ItalianoTurkish — TürkArabic — العربيةVietnamese — tiếng ViệtKorean — 한국의Urdu — اردوPersian — فارسیHindi — हिन्दीDutch — HollandskFinnish — suomalainenAnother language — другой язык

Категория: Любая Без категорииIT, софтАвиация, военная техника, ГОАвто, мотоАзартные игры, казино, покерБытовая техникаДизайн и предметы интерьераДомашние животныеДомашние растения, цветы, растительный мирЗакон и ПравоИгрушки, товары для детейИнтернет-маркетинг, SEO, SMM, создание сайтовИстория, религия, традиции и обрядыКиноКомпьютерные игры, видеоигры и приставкиКрасота и здоровье, питание, диеты, фитнесКулинарияКультура и искусствоЛандшафтный дизайн и архитектураМатериалы 18+Мебель и аксессуарыМедицина, лечение и профилактика болезнейМобильные игры и приложенияМода и СтильМузыкаНаука, открытия, высокие технологииНедвижимостьНепознанное: фэн-шуй, астрология, гороскопыОбразование, учеба, тренингиОтдых, активные игры, охота и рыбалкаОтношения, знакомства, личная жизньПолиграфия, рекламная продукция, маркетингПолитика: аналитика и обзорыПраздники и торжества, свадьбаПрирода и экологияПромышленность и оборудованиеПсихологияРабота и карьера, фрилансРемонт и обустройствоРукоделие, хобби, handmadeСад и огород, сельское хозяйствоСемья, воспитание детей, беременность и родыСобственный бизнес, ForexСпорт и спортивный инвентарь, велотехникаСтихи и поздравленияСтроительный инструмент и материалы, садовая техникаСтроительство домов, дачное хозяйствоТуризм, достопримечательностиУслуги и сервисФинансы, банки и кредиты, экономикаФототехника, искусство фотографииЭлектроника: гаджеты, мобильные телефоны, компьютеры, телевизорыЮмор

Текст — главный инструмент коммуникации между бизнесом и покупателем в мире digital, самый простой и одновременно самый сложный путь общения. Он встречается в разных формах: надписи на кнопках, рекламные слоганы на баннерах, призывы к действиям, статьи на листингах, статьи на блоге.

Есть два традиционных варианта использования этого мощного инструмента:

1. «Чтобы было»

Грубо говоря, «захламить» сайт словами, надеясь, что пользователь сам разберется… Да и вообще, кто эти тексты читает? Как правило, копирайтеры выбираются по одному критерию: самая низкая стоимость за 1000 символов, а что он напишет — без разницы, лишь бы уникальность была 100%.

2. Качественный текстовый контент

Встречается крайне редко, я бы сказала, практически никогда. Но если встречается — дает отличные результаты. Давайте разбираться, что такое хороший текст для сайта и каким он должен быть.

Подготовка технического задания

Написание текста начинается с создания технического задания с параметрами будущего текста:

- ключевые слова — слова или словосочетания, задают вектор написания текста. Они описывают, о чем будет будущий текст;

- объем текста — как правило, заказчик дает диапазон символов, но идеальный объем текста — это полный ответ на вопрос пользователя;

- тезисы — краткие основные посылы текста, будущие подзаголовки;

- уникальность — процентный показатель отличия текста от существующих в интернете. Стремится к 100%;

- плотность ключевых слов — частота использования ключевых слов в тексте. Очень скользкий показатель, варьируется от текста к тексту.

Параметры текста подобрали, техническое задание составили, передали копирайтеру и он написал текст. Теперь нужно его проверить. Давайте рассмотрим, как это делать.

Шаг 1. Проверка тезисного плана

Берем готовый текст, читаем и сопоставляем с тезисами технического задания. Универсального рецепта по проверке не существует, но в тексте должен быть четкий «ответ» на тезис.

Например, даны тезисы:

- Что такое пасхальный декор?

- Виды пасхального декора.

- Как подготовить дом к Пасхе?

- Топ 3 идей для пасхального декора.

После прочтения вы должны узнать о каждом из тезисов. Если этого не случилось, дописывайте текст и добавлять информацию.

Шаг 2. Проверка уникальности

Уникальность — процентный показатель отличия текста от существующих в интернете.

Есть много программ для проверки уникальности текста. Чаще всего каждый текст проверяется отдельно — мы копируем готовый текст, вставляем в интерфейс программы и получаем показатель.

Существуют ситуации, когда на эти действия уйдет слишком много времени, например, нужно проверить весь сайт и определить страницы с неуникальным контентом или на проверке 1000 текстов и проверять каждый отдельно не представляется возможным. В таких ситуациях помогает «пакетная проверка уникальности» — загружаются все тексты оптом и автоматически проверяются. Рассмотрим самые популярные программы проверки уникальности.

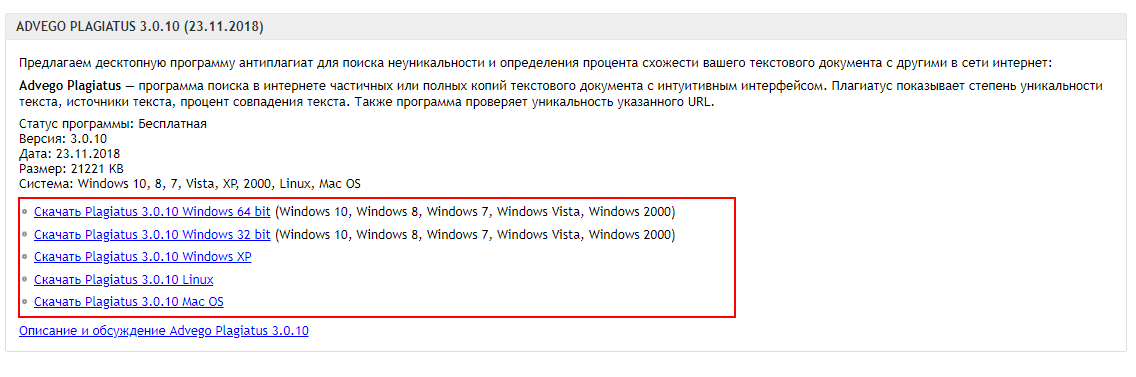

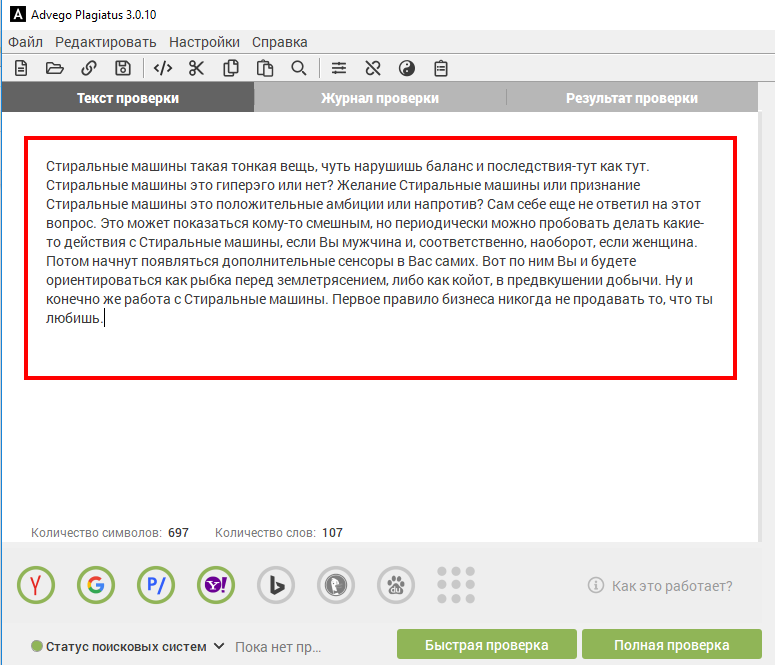

Advego Plagiatus

Одна из самых популярных программ по проверке уникальности текста.

Плюсы: удобный интерфейс, быстрая работа, глубокая проверка текста, можно добавить домены для исключения, гибкие параметры настройки.Недостатки: нужно устанавливать на ПК.

Скачиваем программу с официального сайта. Выбираем нужную версию операционной системы.

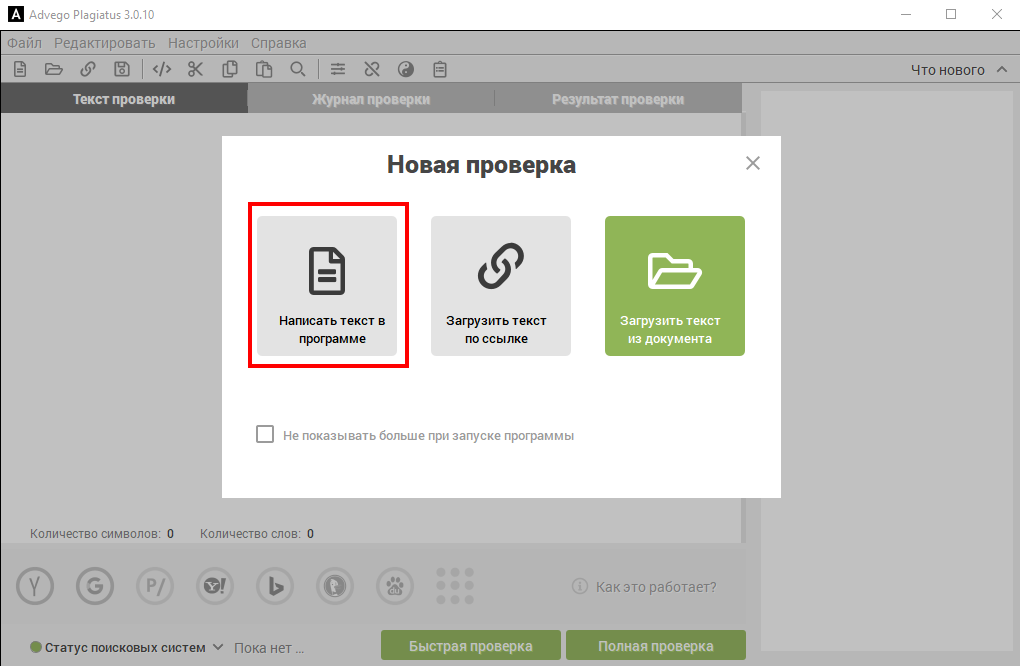

Устанавливаем тип проверки «Написать текст в программе».

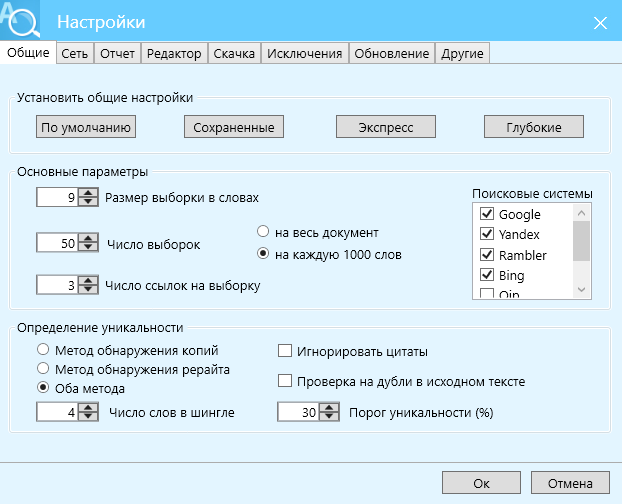

При первом запуске программы нужно выставить настройки. Для этого заходим в пункт «Настройки» — «Настройки проверки».

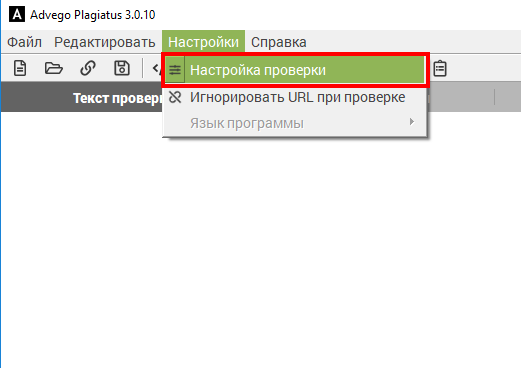

Вставляем список прокси, если мы хотим их использовать при проверке.

Прокси — это IP-адрес, посредник между вами и целевым сервером.

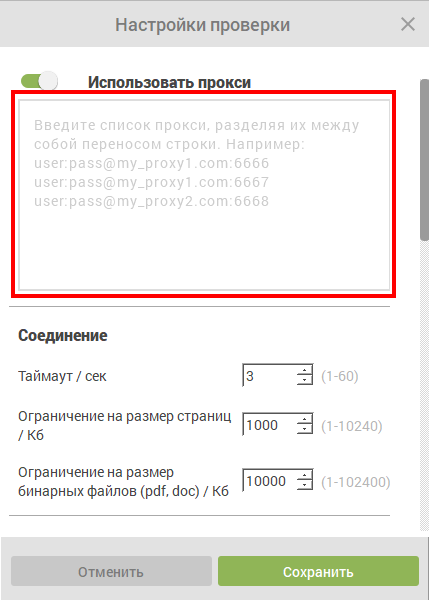

Настраиваем «Соединение» и «Поиск»:

- размер шингла — количество слов, по которым будут искаться совпадения. Здесь не учитываются знаки препинания и стоп-слова. Оптимально 4 слова;

- прерывать при совпадении более % — останавливает проверку, если найдено совпадение текста на %. Можно установить 30%, чтобы не тратить время на лишнюю проверку заведомо неуникального текста;

- ограничение на размер страниц — лучше установить на максимум. Все зависит от того, какие тексты планируете проверять;

- тайм-аут — задержка в секундах между запросами. Если не используете прокси, не нужно выставлять менее 3 секунд;

- ограничение на размер бинарных файлов — лучше установить на максимум;

- учитывать совпадения от % — минимальный процент совпадения с источником, который учитывать при проверке. Устанавливаем 0.5%;

- поисковая фраза — размер фразы в поиске. Ставим 4.

Если используете сервисы антикапчи — для них есть поля ниже. Все, настройка завершена. Сохраняем настройки:

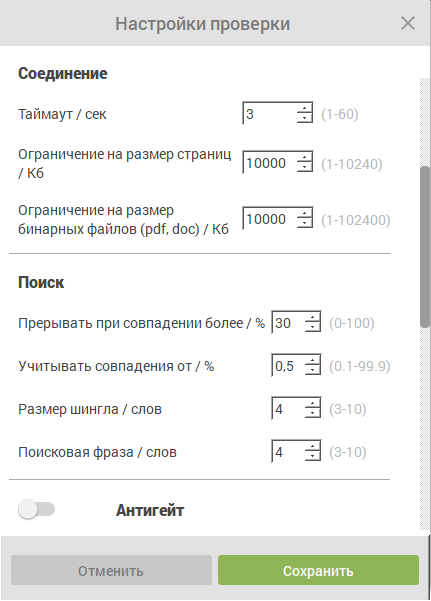

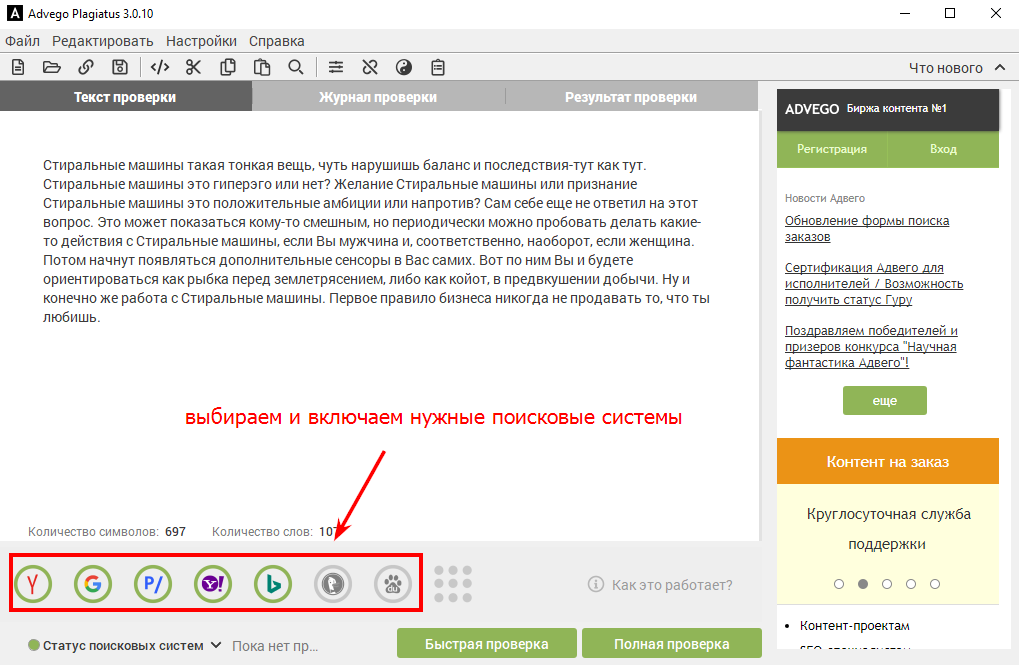

- в окно программы вставляем наш текст для проверки;

- отмечаем нужные поисковые системы, они отображаются значками на нижней панели;

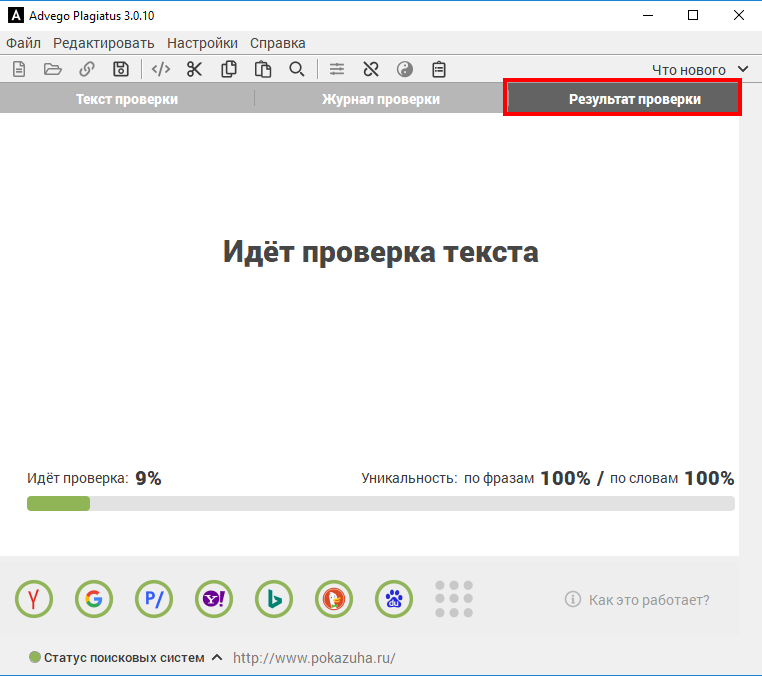

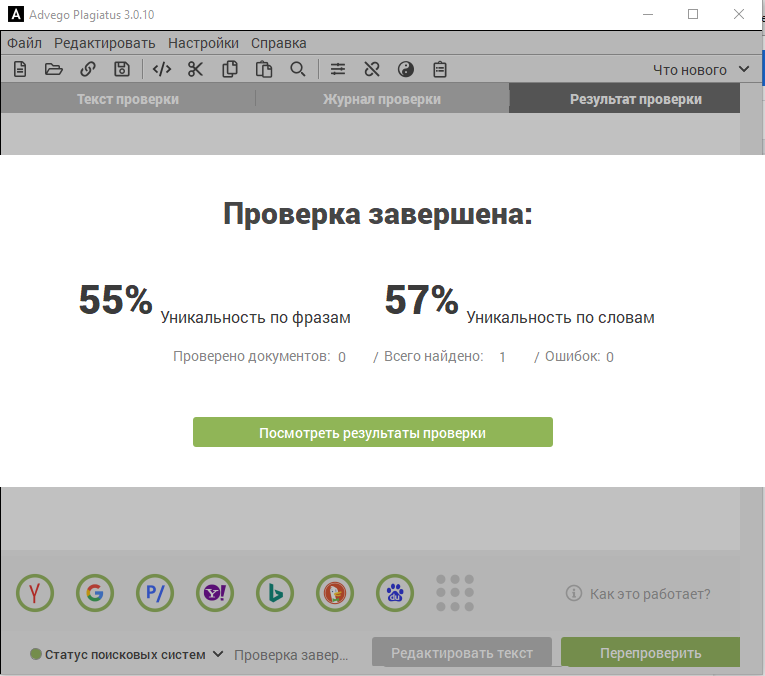

- в Advego есть 2 вида проверки: быстрая и полная. Быстрая поверхностно проверяет текст, а полная даст более исчерпывающие результаты, тщательно проверит текст на копипаст или рерайт. Выбираем «Полная проверка». Ждем результат на вкладке «Результат проверки»;

Результат, как видите, точный:

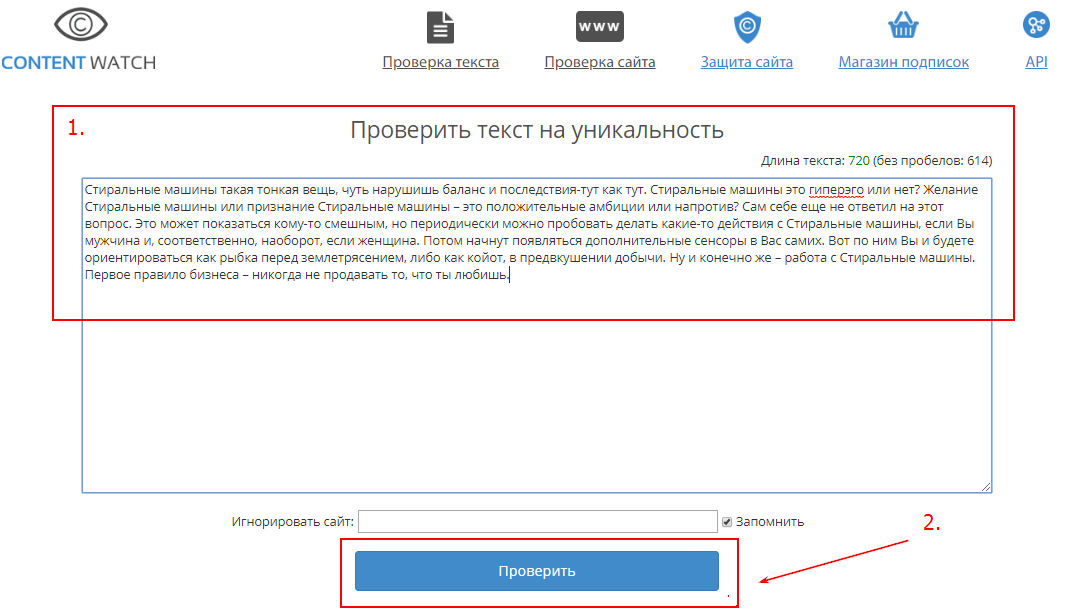

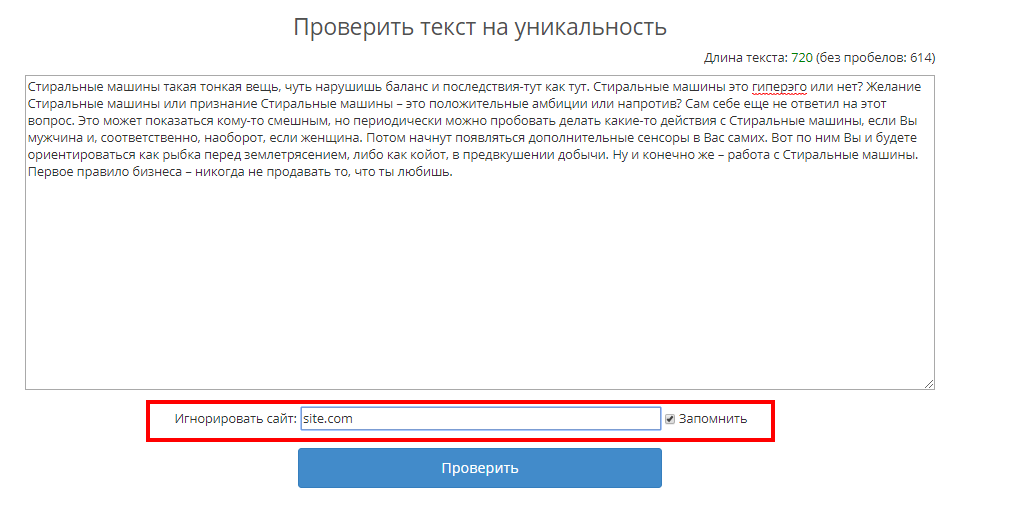

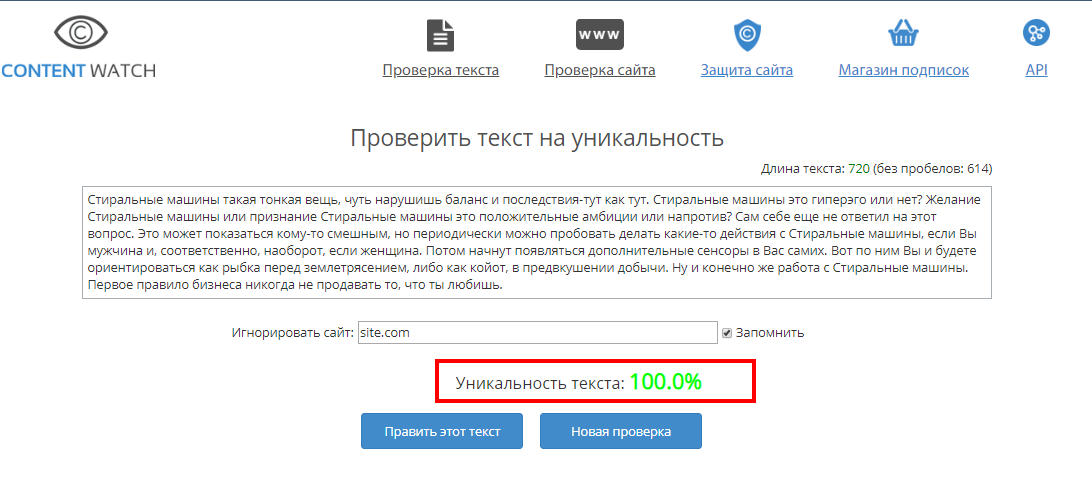

Content-Watch

Онлайн-сервис, часто используется специалистами.

Плюсы: простой, быстрый, есть доступ онлайн, можно добавить страницы на постоянный мониторинг уникальности.Заходим на сайт Content-Watch, вставляем текст и жмем «Проверить».

Если нужно проверить текст на сайте, нужно добавить домен в ячейку «Игнорировать сайт».

Ждем результат. Готово.

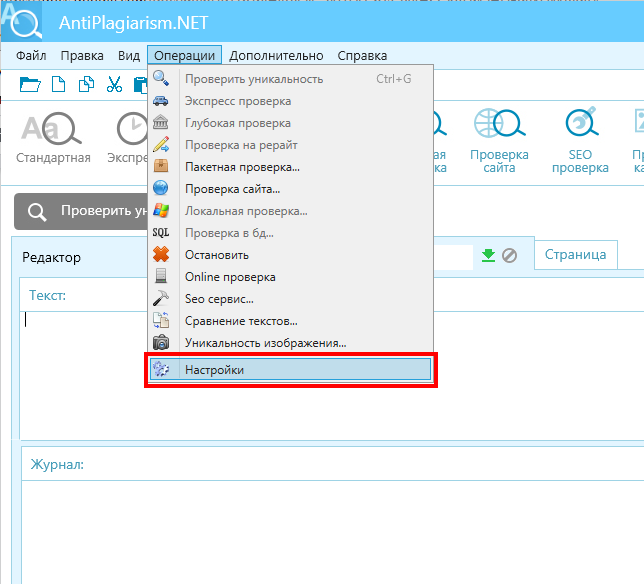

ETXT — программа для проверки уникальности

Еще одна отличная программа для проверки уникальности. Можно использовать наравне с предыдущими.

Плюсы: простой, быстрый, есть доступ онлайн, можно проверять картинки, есть пакетная проверка.Недостатки: нужно устанавливать.

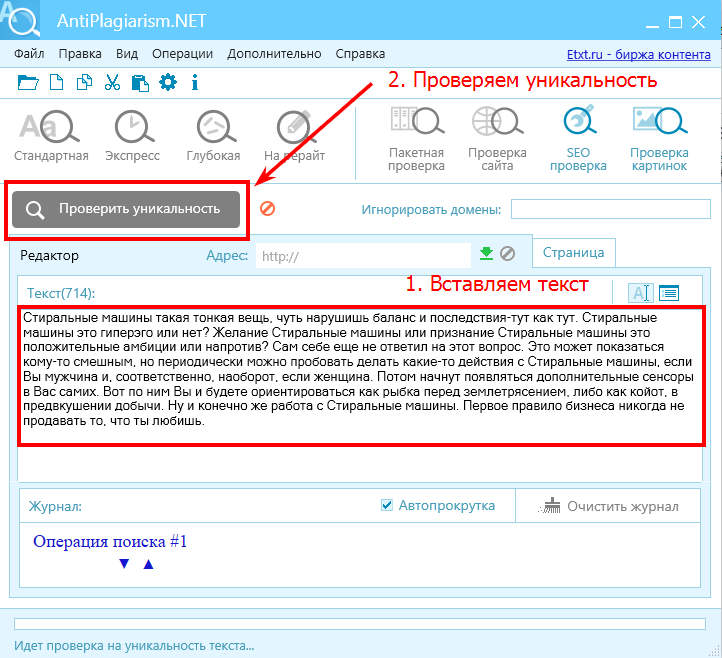

Скачиваем программу, устанавливаем ее и задаем настройки.

Выставляем настройки аналогичные Advego Plagiatus.

Вставляем текст и выбираем метод проверки уникальности. Тут их несколько: стандартная, экпресс, глубокая и на рейрайт. Выбираем нужный тип.

Вот такие результаты получили:

Пакетная проверка в ETXT

Есть ситуации, когда нужно проверить уникальность большего количества фрагментов сразу. Например, агентство прислало на проверку 50 текстов и, чтобы не тратить время даром, можно провести пакетную проверку и отсеять часть на доработку:

- Скачиваем ETXT и выставляем настройки, как описано выше.

- Выбираем «Пакетная проверка» на панели инструментов. Задаем настройки: директорию, откуда будут браться тексты, и две директории для сохранения проверенных текстов по заданному условию. Выбираем тип проверки и наслаждаемся процессом.

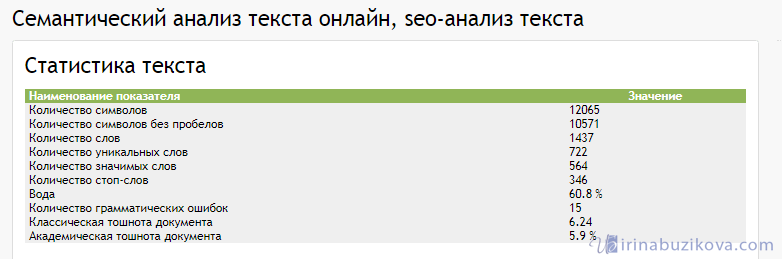

Шаг 3. Проверка использования ключевых слов в тексте

На этапе создания технического задания специалист подбирает ключевые слова и фразы для копирайтера. В зависимости от назначения текста требования к использованию ключей варьируются.

Чтобы быстро проверить ключевые слова в тексте можно использовать одну из программ:

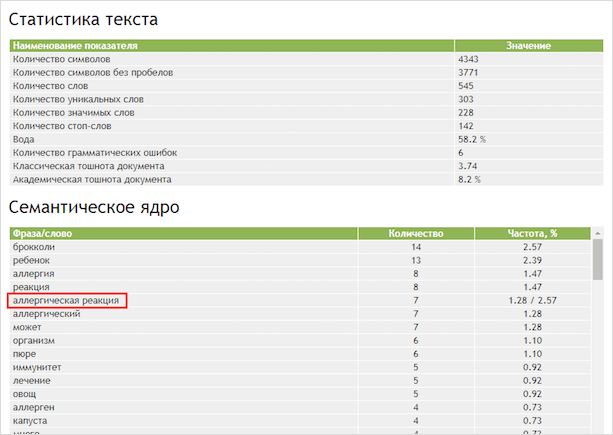

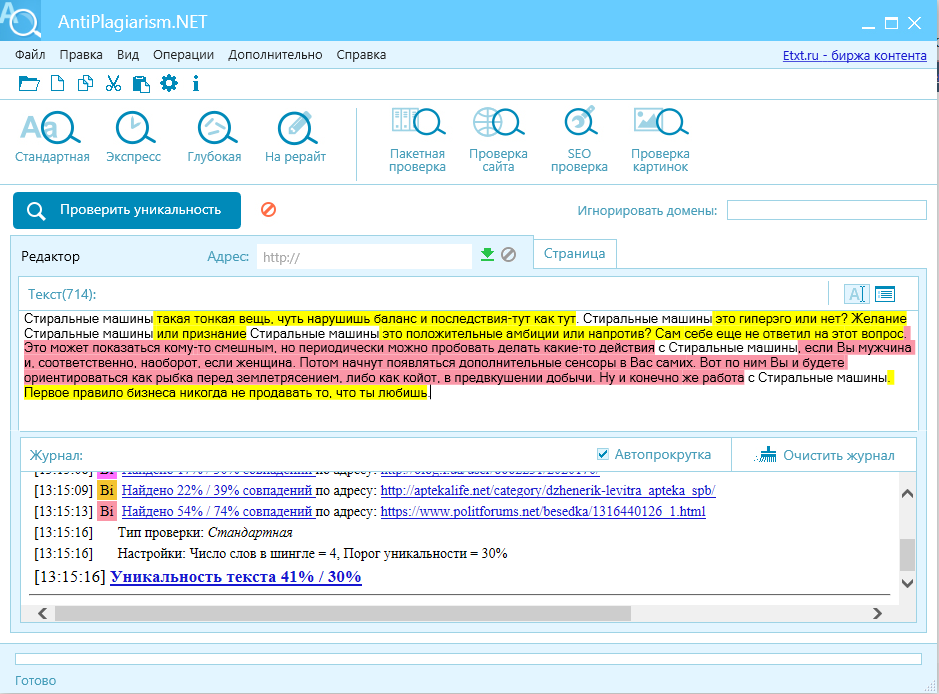

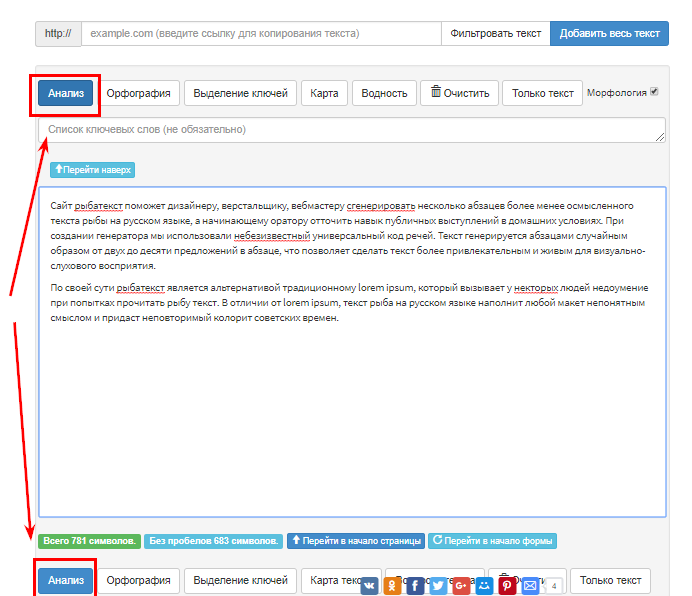

«Семантический анализ текста» — онлайн-инструмент от Advego.

Заходим на ресурс, вставляем в форму готовый текст и нажимаем на кнопку «Проверить».

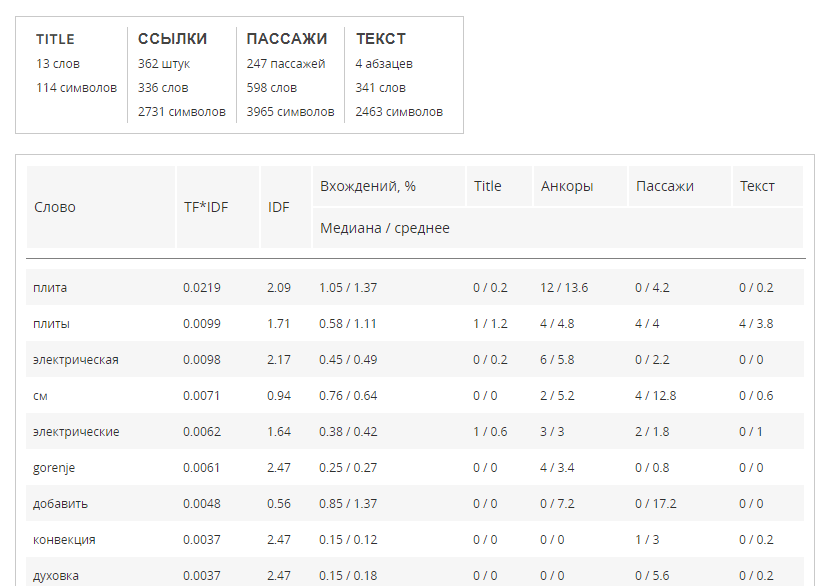

Практически мгновенно получаем статистику использования фраз в тексте с такими общими показателями:

Важно обратить внимание на показатели:

- «Семантическое ядро текста» — таблица показывает частоту использования всех слов в тексте, включая фразы. Оптимально ориентироваться на 3-3,5% (для ключевой фразы и/или слова). Естественно, если вы пишите текст о лодках, ключ «лодка» будет встречаться в тексте чаще всех остальных слов;

- «Вода» — примерное процентное количество слов без смысловой нагрузки. Если «воды» относительно много (более 70%) — тщательнее перечитайте текст. Сам показатель очень условный и ориентироваться на какой-либо числовой порог не стоит;

- «Классическая тошнота» — коэффициент, показывающий заспамленность текста самым повторяющимся словом. Нужно обращать внимание, но ориентироваться на числовой порог не нужно;

- «Академическая тошнота» — показатель характеризует «естественность текста». Если в статье много различных повторов слов —показатель академической тошноты будет большим;

Таблица «Слова» показывает частоту отдельных слов из текста (здесь фраз не будет). Используется аналогично «Семантическому ядру»; Блок «Стоп-слова» показывает статистику использования в тексте слов без самостоятельного значения (предлоги, например).

Блок «Стоп-слова» показывает статистику использования в тексте слов без самостоятельного значения (предлоги, например).

Семантический анализ текста онлайн — инструмент от istio.com

Заходим на ресурс, вставляем текст в поле и жмем кнопку «Анализ».

Результаты анализа показывают частоту использования ключевых слов в тексте. Общие показатели текста: количество символов, количество слов, водность, тошнота.

Значение параметров здесь немного отличается от Advego, но смысл тот же. Подробнее можно почитать на официальной странице справки сервиса.

Все показатели частотности ключевых фраз очень приблизительны — на них можно ориентироваться при беглом первичном анализе текста, но вывод о качестве текста может сделать только специалист после вычитки.

Использование ключей в тексте также можно проверить ручным методом через функцию «Поиск» любого текстового редактора.

Самый важный показатель качества при проверке текста на вхождение ключевых фраз (или слов) — его читабельность. Если в процессе вычитки текста, чтобы понять текст, вам пришлось перечитать фразу несколько раз — предложение нужно переписывать. Главное, помнить, что текст пишется для читателя.

Шаг 4. LSI-копирайтинг. Проверка использования LSI

LSI-копирайтинг ( latent semantic indexing — латентно-семантическое индексирование) — это слова, задающие тематику, за исключением ключевых фраз. Прочитав список этих слов, сразу становится понятно, о чем текст, хотя ни одного ключа в списке нет.

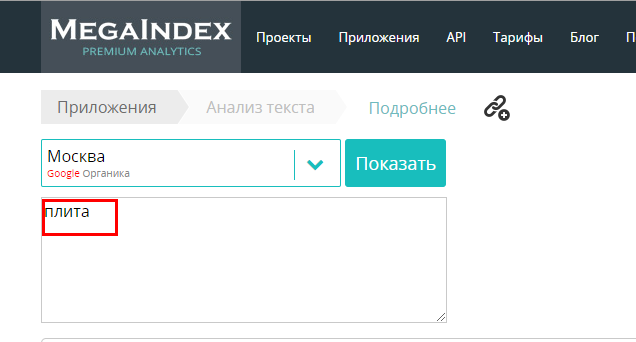

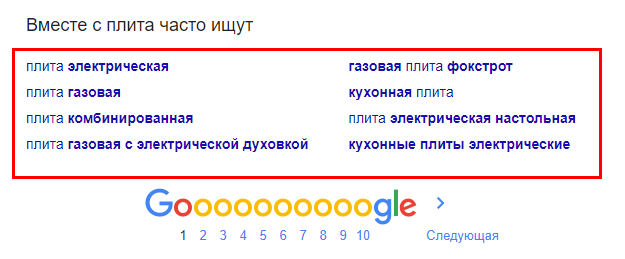

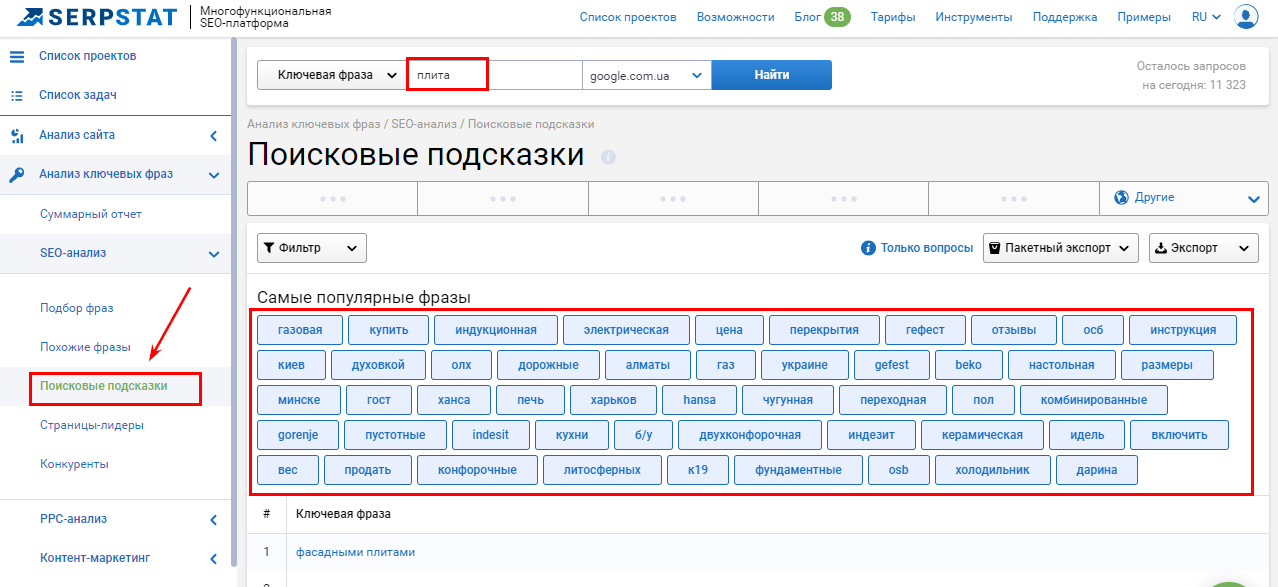

Например, в поиске вбивается слово «плита». Плита — слишком неоднозначный ключ, если рассматривать только его, но, подключив LSI «кухонная, газовая, конфорки, электрическая, техника, доставка», становится понятно, что речь идет о кухонной плите, а не, к примеру, о бетонной.

Существует несколько популярных бесплатных методов для подбора LSI-ключей.

Поисковые подсказки и рекомендации поисковиков

Их можно собирать непосредственно из выдачи.

А можно использовать автоматические сервисы, например, Serpstat.

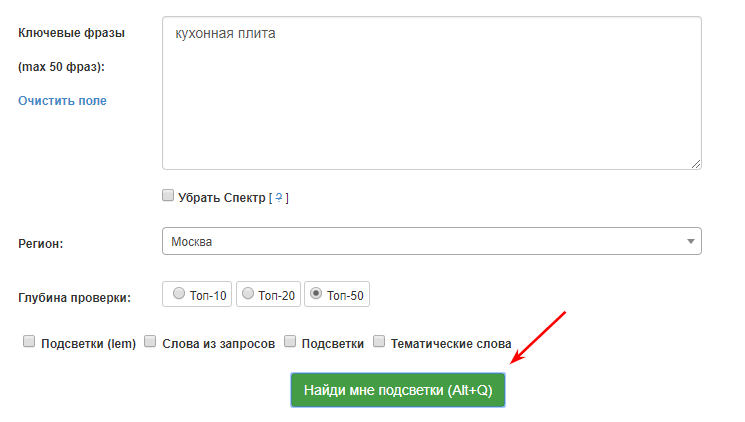

Парсинг подсветок из Инструментов Арсенкина

Парсинг подсветок из Инструментов Арсенкина

Сервис бесплатный, но нужна регистрация.

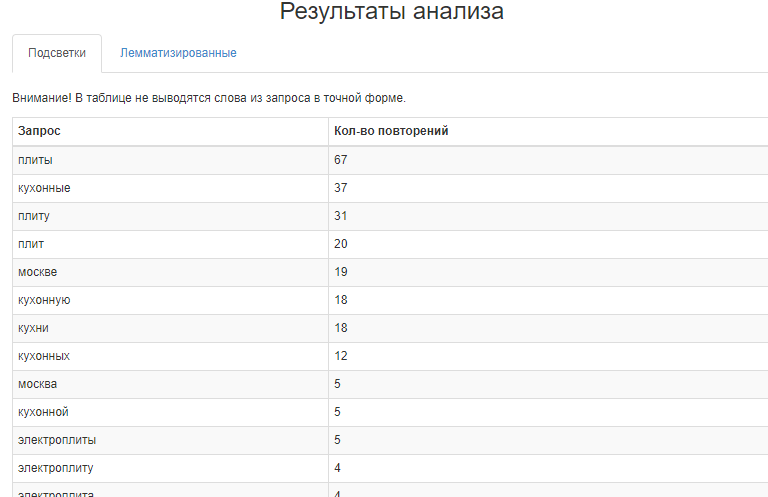

Загружаем список ключевых слов, выбираем регион (не всегда это важно, например, в Москве и Киеве термин «кухонная плита» означает одно и тоже), глубину проверки и жмем «Найди мне подсветки».

Результаты показывают самые частые слова в сниппетах. Убираем мусор и используем в нашем тексте.

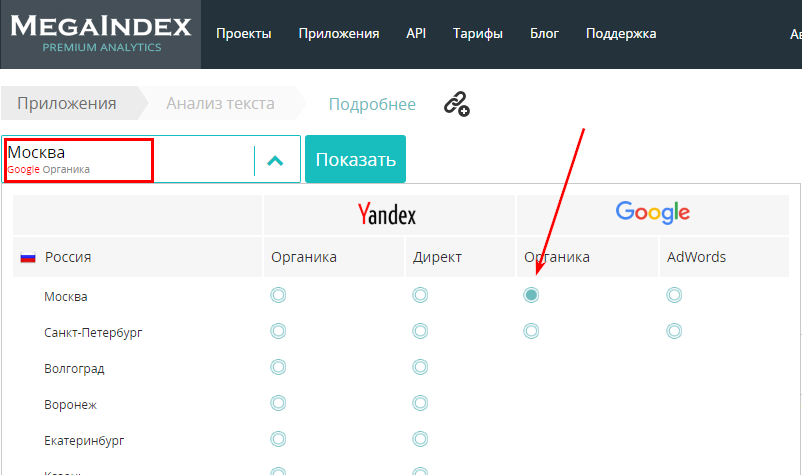

SEO-анализ текста от Megaindex

Этот сервис выдает не просто список слов, а автоматическое техническое задание на написание текста. Его лучше использовать в качестве вспомогательного инструмента.

- Выбираем поисковую систему и регион.

- Вводим ключ или ключевые фразы и жмем «Показать».

- Результаты чистим и убираем мусорные.

Шаг 5. Вычитка текста

Самый важный этап проверки текста. При вычитке обязательно нужно внимательно и вдумчиво перечитывать текст. Если вы несколько раз перечитываете фразы или предложения, — смело переписывайте их заново или выбрасывайте.

Всегда нужно учитывать целевую аудиторию сайта. Например, текст написанный для молодых мамочек и для мужчин-рокеров будет иметь абсолютно разную стилистическую окраску.

Плотность ключевых слов, соответствие тематике, водность и тошнота — все эти показатели не дают точную оценку, в отличие от вычитки.

Главное правило на этом этапе — текст должен легко восприниматься, фразы не должны «резать слух» и статья должна быть интересной.

Вывод

Проверка текстов — процесс творческий и для него не существует шаблонов и универсальных правил. Проверяйте основные параметры, но обязательно руководствуйтесь здравым смыслом.

Основные этапы проверки текстов:

- Проверка тезисного плана — после вычитки текста, все тезисы должны быть освещены в статье.

- Проверка уникальности — не тратьте время на неуникальный контент, пользы от него все равно не будет.

- Проверка ключевых слов — ключи должны использоваться в тексте, но без фанатизма.

- LSI — если пишите текст для своего читателя, используете их даже без списка от сеошника.

Если вы используете другие варианты проверки, делитесь ими в комментариях. Всем хороших читабельных текстов, недорого цена в Киеве и Украине с доставкой.

что это такое и как добиться нужных параметров

Здравствуйте, если вы новичок или продвинутый копирайтер, то знаете, как необходимо придерживаться определенных требований к контенту. Тошнота текста – один из важных показателей, говорящий о качестве работы. Определить числовое значение можно в различных программах, но этого мало. Самое главное знать, как создавать тексты с нужной тошнотностью. Я подскажу, как написать работу на “отлично”.

Продвижение сайта — это в первую очередь его выход в первые позиции поисковиков. Раньше статья, переполненная ключевыми словами, автоматически попадала в авангард. С 2006 года, после введения тошноты, заспамленные статьи не индексировались поисковиками, не говоря уже о потребителе контента. Знаете ли вы, как создать правильный контент?

Показатель тошноты в SEO появился не случайно, ведь именно этот параметр стал определять одни из ключевых позиций хорошего, грамотного сайта. Ключевым параметром качества стала тошнота.

Что такое тошнота текста

Тошнотой является процент употребления конкретных слов относительно всего объема печатных знаков. Ее еще называют заспамленность. Увидеть тошноту в поисковиках можно в процентах. Определить спамность очень просто, если взять за основу часто повторяющиеся слова и разделить количество вхождений на общий объем работы и умножить на сто процентов.

Копирайтер с опытом работы уже знает, что значит заспамленность текста. Взглянув на первые строки выдачи, понятно, какое слово превысило лимит и какой объем занимает. Более подробно подскажут программы для проверки, с их же помощью можно довести работу до идеальных требований.

Нормы тошноты

Понятия нормы тошноты размыты и даже копирайтер со стажем точно не может сказать, какой текст считается идеальным и самое главное – будет расценен поисковой системой на высшем уровне. Если сравнить работу нескольких проверочных программ, то там единства тоже не обнаружить – каждая из них выдает свои параметры.

Например, норма в процентах для Адвего от 7 до 9% академической тошноты, а Text.ru считает правильным показатель до 7%. Такой же стратегии придерживается и программа Miratex. И даже если слово употреблялось минимальное количество раз, то все равно можно лишь приблизиться к нижней границе, но не достичь ее.

Нормы тошноты текста

Нормы тошноты текстаЧтобы понять, как писать с низкой тошнотой, почитайте информацию о теме, по которой пишете работу. После ознакомления появятся идеи, какими аналогами заменить повторяющиеся слова без потери смысла. Это первый шаг к тому, чтобы не повторяться и создать живой, интересный контент не для поисковой машины, а для целевого контингента вашего сайта.

Классическая и академическая тошнота

Тошнота текста бывает академической и классической. Они отличаются по процентам и по методам подсчета результатов.

Академическая тошнота – отношение частотных слов к общему количеству символов. Что означает академическая тошнота – знает каждый копирайтер, гораздо труднее с классическим параметром.

Используется показатель для расчета плотности ключевых слов. Это влияет на очередность выдачи документа в поисковой системе. При наличии слишком большой плотности ключевых слов система посчитает его низкокачественным, “машинным”, поэтому понизить показатель страницы и она не попадет в первые страницы выдачи. Это повлечет снижение рейтинга ресурса. Поэтому не стоит размещать ключевые слова везде, где можно — это отнюдь не украсит статью и не поднимет позиции.

Классическая тошнота – еще один важный показатель, но рассчитывается он более сложно. Цифра, получившаяся при проверке, — это квадратный корень и общего количества слов, которые встречаются чаще всего. Здесь не важен объем, поскольку применяется другая методология расчета. Минимальный показатель классической тошноты – 2,64.

Как привести параметры в норму

При выполнении проверки каждый копирайтер хочет вздохнуть с облегчением, увидев нужные параметры тошнотности. Добиться этого получается не с первого раза, а в ряде случаев над статьей придется знатно попотеть. Чтобы исправить заспамленность, необходимо понимать механизм – как снизить или повысить параметр.

Обычно исправлений требует академическая тошнота, которая может просто зашкаливать при частом повторении слов. Обратите внимание на те слова, которые в выдаче стоят первыми. Их содержание в тексте очень велико, поэтому необходимо заменить синонимами. Если аналоги сразу не приходят на ум или текст узкопрофильный, то можно воспользоваться программами-синонимайзерами. Они не только предложат синоним, но и укажут, в каком контексте это слово станет равноценной заменой.

Не старайтесь вставлять в синонимайзер части работы – в этом случае велик риск погрешностей и выдачи текста со словами неподходящего значения. Всегда лучше заменить отдельные слова вручную.

Вторым вариантом является замена слов на местоимения. Этим не стоит увлекаться, но как метод снижения заспамленности этот способ работает. Исправляйте текст аккуратно и учитывайте падеж, число, склонение дальнейших слов в тексте, иначе возникнет несуразица.

Как привести параметры в норму

Как привести параметры в нормуСреди способов устранения высокой тошнотности можно применить чисто математический подход – увеличить количество текста. Это означает, что процент спамности непременно снизится. Такой вариант решения не всегда подойдет, если копирайтер строго ограничен в знаках. Но и при отсутствии ограничений не нужно “лить воду”, чтобы устранить проблему. Водный контент лишен конкретики и по большей части приводит читателя в уныние, заставляя искать другие ресурсы.

Последняя палочка-выручалочка, как уменьшить тошноту, – пересчет необходимых вхождений ключевых слов. Если минимум 3 вхождения, но слово встречается чаще, достаточно просто привести этот показатель в соответствие. Тогда можно существенно понизить академическую тошноту.

Методы проверки тошноты

Проверка проводится разными программами, и каждая из них имеет свои способы подсчета и показатели нормы. Приступая к работе над текстом, ознакомьтесь с программой, которой предлагают проверять контент.

Если программа на ваш выбор, то здесь проще – у копирайтеров со стажем уже выработалась “внутренняя совместимость” с программами и статьи обычно входят в указанные рамки. Для примера приведем несколько распространенных проверочных сервисов, помогающих определить тошноту.

Text.ru

Программа Text.ru наиболее требовательна к словам, поэтому работать в текст.ру не просто. Уже в антиплагиате выдается, что это за сео-параметры и означают ли они норму. Методика подсчета такова, что даже при глобальной замене повторяющихся слов процент удастся снизить всего на 1-2 единицы.

Показатель заспамленности программой воспринимается таким образом:

- текст до 30% считается не содержащим ключевых слов либо написанным в естественном изложении;

- показатель от 30 до 60% допускается, это “оранжевая зона” текста, в которую попадает большинство работ с правильно вставленными ключевиками, поэтому такой текст считается релевантным;

- процент свыше 60 – плохой показатель, заспамленность сразу становится красного цвета, показывая копирайтеру о недопустимости количества вхождений определенных слов.

Итоги заспамленности по Text.ru

Итоги заспамленности по Text.ruДля борьбы с заспамленностью посмотрите наиболее часто встречающиеся слова и подсветите их в тексте. Они выделены фиолетовым цветом различной интенсивности. В первую очередь нужно бороться с самыми ярко окрашенными вхождениями – именно они наиболее проблематичны и уводят текст все дальше от идеала.

Istio

Сервис Истио очень удобен для проверки, он выдает много параметров, в том числе и тошнотность. Для пользователя анализ указывает, какие 10 слов повторяются чаще всего – уже с них можно начать, если бороться со спамностью.

По этому сервису можно увидеть количество вхождений слова, проценты релевантности, соотношение в ядре и к общему количеству знаков. Для удобства выделите ключи – они подсвечиваются красным и подскажут как избавиться от тошнотности. Воспользуйтесь опцией “Карта” – здесь наиболее частотные слова выделены крупнее остальных. Широкие возможности программы делают ее удобной в использовании. Здесь можно выбирать наиболее значимые параметры, наглядно видеть слова, замена которых необходима.

качественный сервис проверки тошноты” width=”700″ height=”500″ data-mce-src=”https://irinabuzikova.com/wp-content/uploads/2020/03/istio-kachestvennyj-servis-proverki-toshnoty-1024×732.png”> Istio – качественный сервис проверки тошноты

качественный сервис проверки тошноты” width=”700″ height=”500″ data-mce-src=”https://irinabuzikova.com/wp-content/uploads/2020/03/istio-kachestvennyj-servis-proverki-toshnoty-1024×732.png”> Istio – качественный сервис проверки тошнотыАдвего

Одним из популярных сервисов проверки является Адвего. Программа работает давно и полюбилась многим копирайтерам за свой функционал. Здесь очень удобная и быстрая проверка тошноты. Нормой для академической тошноты по Адвего являются параметры от 5 до 15%. После проверки результат можно увидеть в разделе “Статистика текста”, где отображены основные показатели.

В разделе “Семантическое ядро” отображены слова по мере их частотности. Чтобы уменьшить тошноту, начинайте заменять слова, стоящие в ТОПе ядра. Это поможет быстро привести в порядок параметры.

Показатели тошноты текста по Адвего – одни из самых точных

Показатели тошноты текста по Адвего – одни из самых точныхTextus PRO

В программе Textus PRO документы анализируются по особому подходу. Позиция слова будет пропорциональна его месту в работе. Редкие слова опускаются вниз, а наиболее частотные, как и в других поисковиках, появляются вверху. Для анализа текста достаточно ста знаков, а максимум – 15 тысяч. Если тошнота до 7%, то такой показатель считается отличным, поисковик посчитает контент естественным и выдаст его в верхних позициях.

Показатели тошноты текста в программе Textus PRO

Показатели тошноты текста в программе Textus PROОчень удобной подсказкой, как убрать заспамленность текста, является указание в правой стороне сервиса количества слов, которые нужно убрать или добавить. У сервиса отличная навигация, понятный интерфейс и подробно расписанная статистика.

Статистика фраз и слов в программе Textus PRO

Статистика фраз и слов в программе Textus PROПривыкнуть к запросам Textus PRO сложно, но потом работа с платформой дает плодотворный результат.

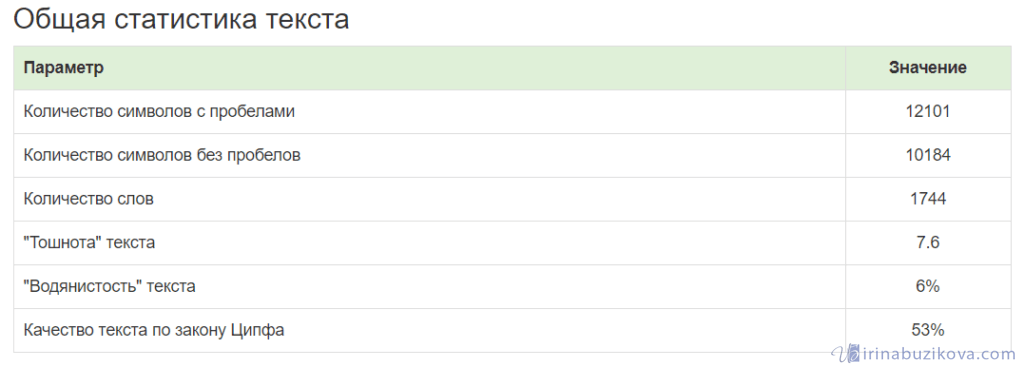

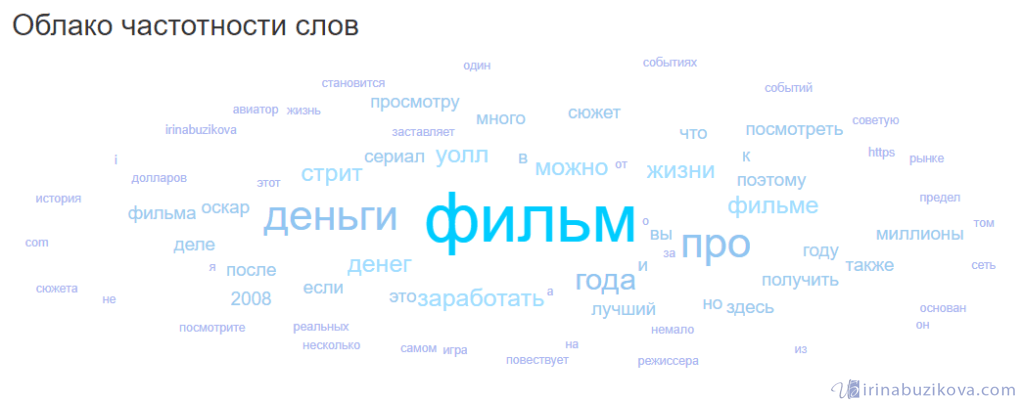

Miratext

Собственный сервис проверки Miratext – отличный способ проверить тошноту текста. Здесь очень удобный функционал, программа быстро анализирует текст на воду и тошнотность и выдает общие показатели в таблице.

Общая статистика текста в сервисе Miratext

Общая статистика текста в сервисе MiratextОчень ценным является отдельная выборка по “водным” словам. Они часто остаются незамеченными, примелькались, как слова-паразиты, и не несут смысловой нагрузки. Безжалостно удаляйте “водность”, чтобы улучшить качество текста.

Облако частотности слов для наглядности имеет вхождения, выделенные разным шрифтом. Наибольший шрифт соответствует самым встречаемым словам.

Облако частотности – удачный способ визуализации тошноты текста в Miratext

Облако частотности – удачный способ визуализации тошноты текста в MiratextДля удобства частотность показана как для одного слова, так и для словосочетаний из двух и трех слов. Для наглядности можно воспользоваться графиком, который покажет 20 самых частотных вхождений, с которыми и придется поработать, если текст не соответствует нужным параметрам. Как и Textus PRO, сервис Miratext предлагает слова, количество которых необходимо отрегулировать.

Еще один вариант градации вхождений в Miratext

Еще один вариант градации вхождений в MiratextКак создать идеальный текст

При написании статей важно не только ставить задачу, как повысить показатели, а и сочетать их со здравым смыслом. Оптимальной является тошнота до 10%. Уложиться в нее просто, если писать живым языком, с применением синонимов, местоимений и других приемов по замене слова.

При заспамленности выше 10 учитывайте направленность текста. Если это медицинская или техническая статья, то здесь трудно подобрать синонимы ко всем частым словам. Во многих случаях понижение заспамленности ведет к ухудшение смысловой нагрузки, появлению существенных ошибок, о которых автор работы может и не подозревать. Стоит ли рисковать ради нескольких процентов качеством контента и своей репутацией?

Учтите, что современные поисковики учитывают не только цифровые параметры, но и тематику контента. Поэтому узкоспециальный текст при повышенном проценте спамности вполне может занять ТОПовую позицию.

Вывод

Начинающим авторам трудно уследить за показателем тошнотности, особенно не зная, что такое заспамленность текста и вода. Много времени уходит на то, чтобы писать не спамные работы, а еще больше – на переработку “брака”. Для этого на первом этапе нужно четко разобраться, что означает каждый показатель.

Чтобы не стать заложником процентов проверяющих программ, расширяйте свой словарный запас, читайте специальную литературу перед тем, как начать работу с узкоспециальной, малознакомой темой. Статьи станут естественными, ориентированными на запросы читателей. Добиться этого несложно, если чаще практиковаться в написании контента, изучать программы-проверки и осваивать просторы профессии копирайтера.

Не забывайте проверять свои работы на уникальность, об этом параметре я уже рассказала.

А как вы боретесь с тошнотой в тексте? Поделитесь своими наработками с коллегами и оставляйте комментарии для новичков.

Если вы нашли ошибку, пожалуйста, выделите фрагмент текста и нажмите Ctrl+Enter.

Как сделать нужную тошнотность для статьи

Если вы хотите продвинуть свой сайт или блог, мало наполнить его интересным контентом. Чтобы поисковые роботы присваивали материалам высокий рейтинг и размещали в его ТОПе выдачи, нужно не только писать статьи, но еще и правильно оптимизировать их. Одним из инструментов такой оптимизации является тошнота текста, варьируя процент которой, вы сделаете контент более или, наоборот, менее привлекательным для поисковиков.

О том, что означает этот параметр, как он высчитывается, а также каким способом изменить показатель тошноты, мы расскажем далее.

Что такое тошнотность текста

Для начала разберемся, что же такое тошнота текста. Этот показатель влияет на SEO, поэтому важен для продвижения сайтов — с ним в работе постоянно сталкиваются сео-оптимизаторы и копирайтеры, создающие контент для страниц сайтов. Начинающим авторам нужно знать об этом параметре, чтобы не удивляться, встречая его в заказах, а также не задавать заказчику лишних вопросов.

Тошнота — выраженное в процентном соотношении частотности ключевых слов к общему объему текста. Поисковые роботы высоко оценивают только те статьи, в которых ключевые слова содержатся в оптимальном количестве — не больше и не меньше, чем должно быть.

Стоит упомянуть и о том, зачем вообще нужен такой параметр в работе поисковиков. Каким бы парадоксом это не выглядело, но он, в конечном итоге, нужен для людей.

К примеру, до 2006 года он не оказывал влияния на результаты поисковой выдачи, поэтому в ТОПе по любому запросу оказывались те статьи, в которых встречалось наибольшее количество ключевиков.

Можно только вообразить, как перенасыщены этими «повторами» были наиболее «выигрышные» статьи, и как тяжело было читать их обычным пользователям, ищущим ответ на свой вопрос. Ключ мог быть вставлен буквально в каждом предложении — и это лишь повышало рейтинг такого контента. Согласитесь, не слишком удобно пользоваться поисковой системой, работающей по такому принципу.

За прошедший с тех пор десяток лет многое изменилось, в том числе и принцип работы поисковых роботов. Они стали «умнее» и качественнее анализировать статьи, а также «угадывать», действительно ли контент отвечает на запрос пользователя. Теперь роботы «предугадывают», сможет ли та или иная статья решить проблему пользователя, и даже больше — насколько контент удобоварим и легок для восприятия его обычным человеком.

Разумеется, поисковики не умеют «думать» — они лишь анализируют общие данные, сверяя их со статистическими. Параметр тошноты играет в этом анализе не последнюю роль. Так, если ее процент очень высок, значит, какое-то слово или несколько повторяются очень часто.

Зависимость этого показателя от общего объема текста также обоснована. К примеру, если в статье размером 8-10 тысяч символов, одно слово повторяется 15 раз, это будет вполне уместно и не бросится в глаза читателю. Но если оно встретится те же 15 раз при объеме в 2-3 тысячи символов — его будет слишком много.

Если такой перенасыщенный ключевыми словами контент встретится поисковому роботу, тот «сделает вывод», что читать статью пользователю будет трудно, а значит, она должна находиться как можно дальше в строке поисковой выдачи.

При этом если в статье будет слишком мало ключевых слов, поисковик «сделает вывод», что она, вероятно, не содержит нужной пользователю информации, и также не поместит ее в ТОП.

Таким образом, рейтинг статьи напрямую зависит от показателей тошнотности, наравне с уникальностью и стилистическим оформлением, также влияющими на сео-оптимизацию.

Виды тошноты

При оптимизации для лучшего ранжирования поисковиками анализируется классическая и академическая тошнота текста. Эти два показателя – важные, однако при написании текстов, как правило, копирайтеры и оптимизаторы больше внимания уделяют категории академической тошнотности. О том, что они означают и как редактируются, мы расскажем далее.

Классическая тошнота

Словом классическая тошнота обозначают количество повторов одних и те же слов, предлогов и союзов. То есть, по данному параметров можно сделать вывод, насколько бедна или, наоборот, разнообразна речь автора. Также этот параметр дает оценку и количеству «мусора» в статье: это так называемые «стоп-слова», состоящие из союзов или «слов-сорняков», перегружающие статью, но не несущие какого-либо смысла.

Значение классической тошноты вычисляется путем извлечения квадратного корня из числа повторений одного и того же слова. Так, если слово «автомобиль» вы употребили 25 раз, показатель по нему будет равняться 5.

Академическая тошнота текста

Несмотря на ту пользу, которую привносит оптимальный уровень классической тошноты для простоты восприятия контента читателем, для оптимизации под поисковые системы важнее другой его параметр — академическая тошнотность.

Она представляет собой частоту употребления самых распространенных слов в статье — ключевиков. Так, если контент перенасыщен ключевыми словами, он будет иметь высокие показатели этого параметра, и не попадет в ТОП выдачи.

Однако если ключей в тексте будет слишком мало, поисковики также не покажут пользователю такую статью, так как она, судя по семантическим данным, не будет соответствовать его запросу.

Уровень академической тошноты — именно в этом преимущество или недостаток текстового контента с точки зрения поисковых роботов, присваивающих рейтинг. Важнее данного показателя, пожалуй, только уникальность статьи.

Академическая тошнота тесно связана с тошнотой по отдельным словам. Этот показатель дает понять, какие слова чаще всего встречаются в статье и, таким образом, составляют ее семантическое ядро — по мнению поисковых роботов, ее «суть».

Сервис Адвего позволяет увидеть, какие слова являются самыми часто употребимыми.

При оптимизации статьи стоит убедиться:

- Что тошнота по слову не превышает рекомендуемый уровень.

- Что самыми «частыми» являются именно ключевые слова, а не другие, особенно «слова-паразиты».

Какая должны быть тошнота текста

Тошнота текста — это показатель, который должен быть на определенном уровне, чтобы статья «понравилась» поисковикам. И главное для правильной оптимизации — не убавлять количество ключей в тексте ниже определенной границы, но и не превышать их содержание.

Однозначного ответа на вопрос, каким должен быть «идеальный» показатель этого параметра, нет. Алгоритмы поисковых сервисов подчиняются своим системам, и работа их не является «прозрачной».

Однако мастера, которые занимаются оптимизацией, методом проб и ошибок вычислили «правильные» показатели, соблюдение которых чаще приводит ту или иную статью в ТОП выдачи:

- Так, показатели классической тошноты документа должны варьироваться от 3 до 5%. Не рекомендуется превышать отметку в 7%.

- Академическая должна находиться в промежутке от 7 до 9%. Рекомендуется придерживаться 8%, а вот отметку в 9% превышать не стоит.

- Частотность ключевых слов не должна превышать 2,6%.

Как измеряется частотность слова

Теперь уделим внимание тому, как именно считается тот или иной показатель тошнотности. Так:

- Классическая высчитывается по самому частотному слову статьи. Именно квадратный корень из количества этих повторяющихся слов и будет показателем классической тошноты.

- Академическая документа высчитывается на основе показателей самых частотных слов статьи при использовании специальной формулы: X = 100*Y/Z, где Y — количество вхождений, а Z — объем текста.

- Тошнота по слову определяется отношением количества вхождений того или иного слова к общему объему статьи.

Определяем уровень тошноты по Адвего

Как видно из формул расчета, проверка текста на тошноту — несложный процесс, но он может быть достаточно трудоемким, если не использовать специальные сервисы, часто предоставляемые биржами контента.

Самая быстрая и точная оценка определения тошноты текста — онлайн-сервис биржи Адвего, полезный не только оптимизаторам, но и копирайтерам, создающим контент для сайтов.

О том, как с помощью него проверить тошноту текста, а также какие еще параметры он дает возможность определить, и как внести правки после того, как будете знать, какая должна быть тошнота текста — расскажем далее.

Первое и весомое преимущество сервиса семантического анализа текста онлайн от Адвего — текст можно проверить, не регистрируясь на самой бирже. Кроме того, большинство пользователей ценят Адвего за оперативность — проверка документа даже большого объема занимает всего несколько секунд.

Помимо классической и академической тошноты сервис позволяет проверить контент на:

- Количество символов

- Количество символов без учета пробелов

- Количество слов

- Количество уникальных слов

- Количество значимых слов

- Количество стоп-слов

- Содержание воды

- Наличие грамматических ошибок

Также Адвего позволяет определить тошноту по слову. Иногда повторяемой может быть и целая фраза, в том случае, если такое словосочетание встречается очень часто.

Пример: если слов «аллергическая» и «реакция» будет много, и они будут во всех случаях стоять в таком порядке, сервис будет показывать их совместную тошноту — «аллергическая реакция».

Чтобы определить уровень тошноты по Адвего, нужно всего лишь зайти на сайт в раздел «Инструменты мастера» — «Семантический анализ» и скопировать текст в указанную графу.

Семантический анализ текста (Рис-1)

После того как вы нажмете «Проверить», сервис откроет страницу с семантическим анализом.

Семантический анализ текста (Рис-2)

Тошнота — классическая и академическая — будет указана в первой же таблице «Статистика». Тошнота по слову — во второй, «Семантическое ядро».

Как убрать лишнюю тошноту текста

После того, как анализ выполнен, переходите к следующему этапу работы — снижать или повышать показатель; как снизить тошноту по Адвего — расскажем далее.

Если вы заметили, что уровень тошноты получился высокий или низкий, это будет оказывать влияние на SEO. При этом опытным путем было установлено, что распространенная причина понижения рейтинга контента — академическая, а не классическая тошнота. По этой причине большинство оптимизаторов уделяют ей основное внимание.

Как правило, пользователи программы задают следующий вопрос по использованию Адвего: можно ли исправлять показатели прямо на сайте после проверки? К сожалению, такой возможности не предусмотрено. Вам придется редактировать текст, а затем, когда вы это сделали, проверять его снова.

Как уменьшить классическую и академическую тошноту

Теперь рассмотрим, как уменьшить академическую тошноту. Поскольку ее показатель — это отношение количества вхождений ключевых слов к объему всего текста, пути для редактирования очевидны: либо уменьшать содержание «ключей», либо увеличивать объем статьи.

Второй способ, по многим причинам, является менее приоритетным. Во-первых, объем — тоже важный параметр для SEO-оптимизации, и его увеличение может негативно отразиться на рейтинге статьи. Во-вторых, это более трудоемкий процесс, нежели простое избавление текста от нескольких «лишних» слов.

Таким образом, чтобы показатель тошноты был низким, понижают именно количество вхождений, так как понизить его проще всего.

Для этого посмотрите, какие слова и фразы – самые повторяемые, и удалите их из текста. Также можно заменить их синонимами, или перестроить предложения таким образом, чтобы они «выпадали» из них.

Теперь о том, как поднять, или увеличить этот показатель; чтобы повысить академическую тошноту, добавьте ключевые слова в статью таким образом, чтобы количество их вхождений возросло.

Что касается классической, то поднимать ее специально не требуется для оптимизации. А вот понизить ее можно, удалив несколько вхождений самого популярного слова, а также очистив статью от «стоп-слов», которые при анализе сервисом Адвего будут приведены в специальной таблице.

Как уменьшить количество воды в тексте

Подводя итоги, стоит отметить и некоторые другие моменты по оформлению текста, которые также влияют на оптимизацию страницы и учитываются поисковиками. Например, содержание воды.

Иногда заказчику важна «водность» текста, что может вызывать вопросы по заказам и отнимать много времени у неопытных копирайтеров.

Содержание воды устанавливается как по сервису Адвего, так и по онлайн-сервису бирже Текст.ру.

Во втором случае, выбрав нужную категорию проверки, вы увидите не только показатель воды, но и рекомендации по его снижению — «водные» слова в тексте будут подсвечены голубым цветом. Удалите их или замените синонимами, и контент станет легче для восприятия читателями.

Рекомендуемый процент воды — 45-55% по Адвего и 15-20% по Текст.ру. А так же,определить и слить лишнюю воду поможет сервис Главред.

Тошнота текста академическая и классическая

SEO копирайтинг

23.06.2020

7 комментариев

С тех пор как поисковые алгоритмы модернизировались — продвигать сайты стали иначе. Но про SEO тексты не забывают, учитывают академическую и классическую тошноту страницы.

Тошнота текста – показатель, дающий представление о том, сколько раз в текст автор вставил одно слово, неважно в каком падеже. Тошнота важна для продвижения SEO-статей и для привлечения органического трафика.

Считаются все склонения слова по падежам. В каждой статье нужно следить за повторениями, это не особая прихоть оптимизаторов, а необходимость для внутренней оптимизации страницы.

Как появилась тошнота текста?

Для понимания термин «тошнота» ввели, чтобы представлять в цифровом выражении сколько раз допускается использовать ключевой запрос в статье. Если их будет много, этот документ будет не сильно ценным и направлен на привлечение поисковика. Читать его невозможно, нужно грамотно проводить внутреннюю оптимизацию.

Тошнота текста стала важна, когда поисковики стали оценивать качество на страницах и формальные признаки документов перешли на второй план. Вполне понятно, что тексты, созданные не для людей (машинные) с помощью программ по размножению, не будут проходить ни по уникальности, ни по другим параметрам.

В этот период в SEO стали вводиться ограничения, позволяющие отслеживать уровень академической и классической тошноты. Параллельно стали вводить переспам слов в тексте.

Для академической рекомендуемый показатель — 7-8% по Адвего (это по всему документу).

Для классической — 3%, когда в тексте объемом от 5 000-10 000 символов повторений слова будет не более 9-11 раз. Чем длиннее статья — тем больше повторений, за этим необходимо следить.

Виды тошноты статьи

Всего выделяют 2 вида тошноты текста и каждый выполняет свою роль, поэтому учитывают два показателя. Хотя, если автору специально в ТЗ не указывать на них, то этот показатель останется без внимания. Разбираемся, что такое академическая тошнота и чем она отличается от классической. И влияют ли такие показатели на ритм текста, насколько это ухудшает или улучшает подачу информации?

Академическая тошнота

Для нее вывели формулу, которая в результате показывает в процентах, сколько раз использовалось слово относительно других слов в статье.

Академическая тошнота подразумевает процентное выражение отношения ключевых фраз ко всем словам в статье. Частота употребления слова на конкретной странице.

Формула выглядит вот так:

16 раз слово — X %

599 слов в статье — 100 %

X= 16*100/ 599 = 2,86% — именно такие цифры будут в сервисах.

Классическая тошнота

Классическую тошноту документа показывает сервис Адвего. Она определяется по формуле: это значение корня квадратного из количества повторений слова.

Если слово повторялось только 10 раз, то корень извлекается из 10. Чтобы наглядней было, извлечем корень из 16 повторений, будет 4. Такое количество считается нормальным, если текст величиной не менее 7000 сим без пробелов.

На малый объем документа повышенная тошнота текста считается губительной, искусственным добавлением слов, что строго карается и возможен фильтр на сайт.

Ранее добавляли в документ максимальное количество ключей, которые увеличивали тошноту, а теперь за это страница наказывается Баден-Баден.

Ошибки в работе с тошнотой текста

Большая тошнота

Одна из крайностей, которая пользовалась успехом и давала результат. Добавив максимальное число повторений ключевых фраз, можно попасть в ТОП по высокочастотному запросу. Теперь приветствуется LSI-копирайтинг с их смежными словами, которые подходят к запросу и необходимы.

Недостаточная тошнота

Когда статья нерелеватная по смыслу, ключевые слова вставлены в текст для галочки, то поисковый робот может не принять ее всерьез, не показывать в выдаче по главному запросу. Потому отсутствие оптимизации статьи или недостаточное количество необходимых слов по теме могут привести в тому, что робот не покажет вашу статью.

Текст не будет ответом на запрос и статья может уйти далеко вниз, куда посетители вряд ли доходят.

Как снизить тошноту текста?

Уменьшать классическую и академическую тошноту нужно разными способами.

Для уменьшения академической тошноты подойдут такие способы:

- Расширяем статью и увеличиваем количество текста. Даже при ограниченных объемах, но с четким следованием всех параметров, этот способ работает. Если на 1000 знаков требуют вписать около 7-10 ключевых фраз с повторяющимися словами, то увеличивать надо и говорить об этом заранее.

- Удаляем высокочастные фразы. Желательно использовать синонимы и снижать водность с помощью уменьшения стоп-слов. Программа синонимайзер поможет в этом.

Классическую тошноту уменьшают так:

- Делаем анализ семантики статьи. Выделяем самое популярное слово, которое повторяется и удаляем его. Если использовать сервис проверки тошноты, то он покажет сколько слов находится на втором и третьем месте по популярности.

- Вычеркните все стоп-слова. Когда часто используют союзы, особенно если их можно опустить. Неуместно добавлены вводные конструкции: «однако», «например», «конечно». Говорим не о разом использовании, а о постоянном повторении этих слов.

Где проанализировать статью?

Можно применить способ визуального анализа документа и прочитать статью, если какие-то слова будут попадаться слишком часто — это необходимо убрать. У этого метода анализа есть недостаток: после 3 или 4 статьи глаза начинают привыкать к тематикам, пропускать какие-то выражения, потому что все смешивается.

Второй способ популярный и действенный, отнимает мало времени — воспользоваться онлайн сервисами для проверки тошноты текста.

Онлайн-сервис Адвего

Увидим в результате анализа что такое тошнота текста и какая она бывает. Сервис помогает смотреть на количество фраз в документе, а не только по одному слову. Если ключ состоит из 3 слов, его использовать n-е количество раз в статье, то Адвего покажет частоту фразы полностью.

Чтобы это посмотреть нужно опустить курсор ниже.

Смотрим теперь цифры по каждой фразе:

Показатели в норме, потому что не превышают 3%, цифра 2,46 еще допускается.

Сервис istio.com

Сервис показывает общую тошноту текста и количество используемых фраз. Общая может повышаться благодаря неразумному использованию предлогов «и» и «в». Если она превышает 7 баллов, то такие статьи вряд ли станут популярными и займут сразу ТОП. Хотя, может быть всякое.

Сервис SEO-прорыв

Предлагается несколько вариантов SEO анализа сайта: разовый анализ, пакет из 10 проверок и ручной премиум аккаунт.

Сервис помогает с переспамом, позволяет увидеть, с каких страниц сайта трафик ушел, где статья поднялась вверх.

В результате анализа дается таблица показателей, где можно увидеть значения.

Программа TextusPro

Ее надо скачивать на компьютер и в окно вносить текст, потом она самостоятельно посчитает тошноту текста и покажет количество повторений. Программу создали под руководством копирайтера — Дениса Каплунова.

Удобно, что в программе можно отслеживать статистику текста и статистику фраз и слов в документе.

Как убрать тошноту текста?

Не все копирайтеры пишут идеальные тексты. У некоторых материал появляется после нескольких корректировок.

Проверяем текст в Адвего. Находим слова, которые часто употребляются, выписываем их частотность, начинаем корректировать. Заменяем ключевые слова на синонимы, а где-то вовсе их удаляем.

Понадобится больше времени на написание материала, но результат оправдает. Редактируя предложения, желательно не только уменьшать тошноту, но и переспам (фразы повторяются в предложениях), безжалостно вычеркивать стоп-слова, смотреть на тавтологию.

Тошнота определяет количество ключевых фраз в статье и их повторений в разных падежах. По слову показывает, сколько раз оно использовано. Если вам понравилась статья на Редачим, то ставьте «нравится» и ждем вашего мнения в виде комментариев.

кто хочет в группу единомышленников присоединяйтесь к нам

Присоединиться1

2

3

4

5

6

7

8

9

10

11

12

Интересное:

Как снег на голову мне на голову упал снег, и я пошел по заснеженному полю, сбивая снежинки и снеговые кучи…

Вас не стошнило? Чувствуете перебор слова «снег». И если такой текст режет слух читателю, то поисковыми роботами он воспринимается как заспамленность контента. Чтобы не пропустить в интернет подобные шедевры была разработана специальная программа, фильтры Гугл и Яндекс, которые отслеживают тошнотность всех текстов на сайте и ставят страницу на определенное место в поисковой выдаче.

Что такое тошнота или тошнотность текста

Проверка текста на тошноту осуществляется простым подсчетом однокоренных слов. Всех. Поэтому в статье может быть перебор не только ключевых запросов, но и любых других слов. Существует два показателя: классическая и академическая тошнота текста.

- Академическая показывает процент частотности определенного слова по отношению к другим словам.

- Классическая, это математически выведенная единица: квадратный корень от числа повторов самого тошнотного слова, независимо от объема текста.

Хорошим результатом проверки на тошноту считается:

- частотность по слову не более 2,5 %;

- классическая тошнота до 3.5%;

- академическая до 7,5%.

Перед вами скрин первых двух подзаголовков этого текста. Как видите, результаты отвратительные. И слов мало и перебор по тошноте огромный.

Как убрать тошноту текста

Алексей Трудов, известный интернет-маркетолог, который много лет проводит исследования на тему как влияет качество статьи на ранжирование текста однозначно заявляет, что показатель тошнотности, сам по себе, играет не большую роль для продвижения сайта.

Но все дело в том, что многие сайты создаются такими же дилетантами как я, которые учатся и работают одновременно. И для нас важно исправить все, на что хватает знаний, и сократить претензии от поисковиков везде, где только можно. Поэтому привести в порядок текст по показателям тошноты, воды и уникальности самое простое, что мы можем сделать.

Тошнота сео текста приводится в норму простой заменой частых слов на синонимы. Есть достаточно сервисов, где можно подобрать синонимы, например, на бирже копирайтинга Text sale. Внизу правого меню есть специальная кнопка «В помощь копирайтеру. Подбор синонимов.»

Программа синонимайзер. Это не просто подбор синонимов, это замена всего текста, часто с потерей смысла. Пользуясь таким подсказчиком будьте очень внимательны, результат не предсказуем.

Вторая проблема, с которой может столкнуться копирайтер — нехватка ключевых запросов. Желательно, чтобы ключей в тексте было максимальное количество по сравнению с другими словами. Выход из положения аналогичный – добавляем ключевые запросы в разбавленном вхождении и повышаем тошноту ключами, а не дополнительными словами.

Где сделать анализ тошноты текста

Любую статью, независимо от платформы публикации тяжело читать, если в ней встречается стойкое повторение одних и тех же понятий. Это как слово «Класс!» которым подростки выражают всю гамму чувств и одновременно дают оценку происходящему. Поэтому проверять свою работу необходимо сразу после написания и перед сдачей заказчику или публикацией на сайте. Сервисы проверки.

Биржа копирайтинга Advego. Автору будет достаточно проверить работу, перейдя во вкладку «Сео анализ». Регистрировать на странице для получения бесплатной проверки не требуется. Кроме тошнотности, здесь отслеживают уровень воды, количество знаков, указывают на процент стоп слов, которые не несут смысловой нагрузки.

Платформа Istio.com. Удобна как для автора, так и для вэб мастера. Четкий и быстрый анализ покажет и общее количество переспама и подсветит конкретные слова, которые влияют на большой уровень тошноты. Онлайн, в окне проверки можно сделать коррекцию текста и перепроверить свою работу.

Но! После того, как вы скопируете переделанную, отлично оптимизированную работу, готовьтесь к тому, что статья потеряет свое первоначальное форматирование. Исчезнут списки, выделения, стили, и получится красивая статья для роботов, а для людей придется сделать оформление заново.

Тургенев. В 2017 году Яндекс запустил новый фильтр под интересным названием «Баден Баден», в Гугл используется алгоритм «Панда», который проверяет контент на сайте буквально на все, в том числе и на спам, и, как результат, многие блоги перестали ранжироваться (быть видными пользователям).

В ответ на это гении с противоположного лагеря разработали платформу Тургенев, где даже копирайтерам новичкам легко работать. Править статью можно на странице сервиса бесплатно, количество правок не ограничено, Тургенев дает ссылку на результат. Регистрация необходима.

Ну а теперь, когда эта статья дописана, давайте проверим ее на тошнотность. Если Вы заметили, вторая часть практически не содержит этих заезженных слов «проверить тошноту». И вот результат. Все отлично, проверяем уникальность, исправляем грамматические ошибки и публикуем. Всем удачи.

Посмотрите интересное видео, и у Вас больше не возникнет вопросов, что такое тошноте и с чем ее, простите, едят.

- Товары

- Клиенты

- Случаи использования

- Переполнение стека Публичные вопросы и ответы

- Команды Частные вопросы и ответы для вашей команды

- предприятие Частные вопросы и ответы для вашего предприятия

- работы Программирование и связанные с ним технические возможности карьерного роста

- Талант Нанимать технический талант

- реклама Связаться с разработчиками по всему миру

Загрузка…

,Подсчет частот слов с помощью Python

Содержание

Цели урока

Ваш список теперь достаточно чист, чтобы вы могли начать анализировать его содержимое значимым образом. Подсчет частоты конкретных слов в списке может предоставить иллюстративные данные. Python имеет простой способ считать частот, но это требует использования нового типа переменной: словарь . Прежде чем начать работу со словарем, рассмотрите процессы, используемые для расчета частот в списке.

файлов, необходимых для этого урока

Если у вас нет этих файлов, вы можете скачайте (zip) файл, содержащий весь код из предыдущих уроков этой серии.

Частоты

Теперь мы хотим посчитать частоту каждого слова в нашем списке. Вы имеете

Уже было видно, что обработать список легко, используя цикл для . Пытаться

сохранение и выполнение следующего примера. Напомним, что + = говорит

Программа для добавления чего-либо в конец существующей переменной.

# count-list-items-1.py

wordstring = 'это были лучшие времена, это были худшие времена'

wordstring + = 'это был век мудрости, это был век глупости'

wordlist = wordstring.split ()

wordfreq = []

для w в списке слов:

wordfreq.append (wordlist.count (ж))

печать ("String \ n" + wordstring + "\ n")

print ("Список \ n" + str (список слов) + "\ n")

print ("Частоты \ n" + str (wordfreq) + "\ n")

print ("Pairs \ n" + str (list (zip (список слов, wordfreq))))

Здесь мы начинаем со строки и разделяем ее на список, как мы сделали

перед.Затем мы создаем (изначально пустой) список с именем wordfreq , иди

через каждое слово в словарном списке и посчитайте, сколько раз

слово появляется во всем списке. Затем мы добавляем количество каждого слова к нашему wordfreq список. Используя операцию zip , мы можем сопоставить первую

слово из списка слов с первым номером в списке частот,

второе слово и вторая частота и так далее. В итоге мы получаем список

пары слов и частот. Функция str превращает любой объект в

строка, так что это может быть напечатано.

Вы должны получить что-то вроде этого:

Строка

это были лучшие времена, это было .Понимание написанных слов: тщательный обзор Word2vec, GloVe, TF-IDF, Bag-of-word, N-граммы, методы кодирования 1-hot

В этой статье рассматривается представление язык для обработки естественного языка (НЛП). Если вы один из тех редких гуру глубокого обучения, вы, скорее всего, не узнаете здесь ничего нового. Если нет, погрузитесь со мной в увлекательный мир превращения слов в некоторые представления, которые могут понять алгоритмы.Мы мотивируем, почему мы хотели бы сделать это, какие подходы существуют, и как они работают на простых примерах. Мы будем избегать как можно большего количества математики и будем использовать легкий стиль написания, чтобы увеличить шансы на то, что вы действительно прочитаете статью до конца. Хотя статья кажется довольно длинной, заниматься серфингом весело.

История языкового происхождения повторяется каждый раз, когда ребенок начинает говорить. Действительно, язык зародился, когда люди начали называть объекты, действия и явления, которые появились в реальной жизни.Глядя на веру в божественное творение, разделяемое миллиардами людей, мы можем думать о том, что языки так же стары, как и люди. Каждый раз, когда мы пишем короткое сообщение, твит, чат, электронное письмо, пост или даже веб-страницу, статью, блог или книгу, мы превращаем мысли в слова или символы. Благодаря языку люди могут превращать невидимые идеи в видимые вещи. Кроме того, человеческие мысли становятся доступными для других людей, а также для… угадайте, что? Компьютеры! Если люди способны восстанавливать мысли из слов, могут ли компьютеры это делать?

С недавним ажиотажем, называемым искусственным интеллектом, весьма полезно иметь компьютеры, способные обрабатывать, понимать и генерировать человеческий язык.Перевод Google — хороший пример, полезный. Google начал с сканирования большого количества книг из университетских библиотек и списков веб-страниц, включая их человеческие переводы, и изучения шаблонов между источником и целью (статистический машинный перевод). Сегодня благодаря Google Translate и его последовательным моделям (нейронный машинный перевод) мы можем получить доступ к мыслям, закодированным на любом языке, на котором мы еще не говорим.

Другим примером является текстовой категоризации .Люди очень хорошо разбираются в категориях, например, «хорошо» и «плохо». Они делают это целую вечность. В то же время люди очень хорошо умеют генерировать и записывать информацию в форме текста. По данным Google, во всем мире насчитывается около 129 864 880 книг. Спорим, вы не хотите классифицировать их вручную, даже если вам предоставлена самая большая библиотека в мире с достаточным пространством и полками. В то же время вам действительно нужно классифицировать эти книги, по крайней мере, по жанрам: комиксы, кулинария, бизнес, биографии и т. Д.Здесь вы бы включили компьютерную программу, которая считывала бы содержание книги и автоматически определяла ее жанр. Давайте на минутку уйдем от книг. Среди нас все больше людей, которые не читают книги и предпочитают новостные ленты. Они обычно получают сотни сообщений, сообщений или статей каждый день. Сортировка спам-сообщений и поддельных новостей из соответствующих обновлений, например, о промышленности и рынке, стала очень актуальной задачей для них, если это делается с помощью компьютерной программы.Вероятно, вы читаете эту статью, потому что алгоритм рекомендаций отсортировал ее по многим другим статьям и отправил в почтовый ящик или мобильное приложение. Этот алгоритм должен был распределить по категориям тысячи статей и выбрать эту статью-победителя, которая вам, скорее всего, понравится, конечно же, исходя из вашей истории чтения и вашего умного взгляда.

Ответы на вопросы ботов — еще одна шумиха в наши дни. Представьте себе, сколько времени вы, как специалист службы поддержки клиентов, сэкономили бы, если бы у вас была копия, отвечающая на десятки звонков, которые вы получаете каждый день от ваших клиентов, задающих одни и те же вопросы снова и снова.Мы все слышали об Amazon Alexa, Apple Siri или Google Assistant. Эти системы автоматически отвечают на вопросы людей на естественном языке.

Надеемся, что приведенные выше примеры мотивируют, почему компьютеры, обрабатывающие естественный язык, являются интересной темой для вас. Если нет, то если вы посмотрите на другие примеры, иллюстрирующие распознавание речи , имитацию речи и синтез речи , вы наверняка поразитесь.

Теперь, почему все эти разговоры о языке и компьютерах? Вы печатаете текст в своем любимом текстовом редакторе или программном обеспечении электронной почты каждый день.Итак, почему компьютеру должно быть трудно понять ваш текст? Язык неоднозначен на всех уровнях: лексическом, фразовом, семантическом. Язык предполагает, что слушатель знает мир, контекст и методы общения. Если вы вводите «информацию о мышке» в поисковой системе, вы ищете домашнее животное или инструмент? Представление текста очень важно для производительности многих реальных приложений.

Теперь, как мы можем превратить язык в то, чем пользуются компьютерные алгоритмы? В основе процессоры в компьютерах выполняют простую арифметику, такую как сложение и умножение чисел.Это причина, почему компьютеры любят цифры? Кто знает. Во всяком случае, эта проблема хорошо решена для изображений. Например, область, отмеченная кружком на рисунке ниже, представлена тремя матрицами чисел, по одной для каждого цветового канала: красным, зеленым и синим. Каждое число указывает уровень красного, зеленого или синего в месте расположения пикселя. (0,0,0) отображается черным, а пиксель, компоненты цвета которого (255,255,255), отображается белым.

источникПроцесс преобразования текста в числовой материал, аналогичный тому, что мы сделали с изображением выше, обычно выполняется путем построения языковой модели .Эти модели обычно назначают вероятности, частоты или некоторые непонятные числа словам, последовательностям слов, группе слов, разделу документов или целым документам. Наиболее распространенные методы: 1-горячее кодирование, N-граммы, пакет слов, векторная семантика (tf-idf), семантика распределения (Word2vec, GloVe). Посмотрим, поймем ли мы, что все это значит. Мы должны быть в состоянии. Мы не компьютеры. Вы, по крайней мере.

Если в документе есть словарь с 1000 слов, мы можем представить слова с горячими векторами.Другими словами, у нас есть 1000-мерные векторы представления, и мы связываем каждое уникальное слово с индексом в этом векторе. Чтобы представить уникальное слово, мы устанавливаем компонент вектора равным 1 и обнуляем все остальные компоненты.

источник: Основы глубокого обучения, Н. Будума, 2017Это представление довольно условно. Это пропускает отношения между словами и не передает информацию об их окружающем контексте. Этот метод становится крайне неэффективным для больших словарей.В следующих нескольких разделах мы рассмотрим более интересные подходы.

Мы начинаем смотреть на самую основную модель N-граммы. Давайте рассмотрим наше самое любимое предложение из нашего детства: «Пожалуйста, ешьте свою еду». 2 грамма (или биграмма) — это последовательность из двух слов, таких как «пожалуйста, ешьте», «ешьте свое» или «ваша еда». 3 грамма (или триграмма) будут представлять собой последовательность из трех слов, например «пожалуйста, ешьте свою» или «ешьте свою еду». Модели N-грамматического языка оценивают вероятность последнего слова с учетом предыдущих слов.Например, учитывая последовательность слов «пожалуйста, ешьте свое», вероятность следующего слова выше для «еды», чем для «ложки». В последнем случае наша мама будет менее счастлива. Лучший способ вычислить такую вероятность для любой пары, тройки, четверки, … слов — это использовать большой объем текста. На изображении ниже показано несколько вероятностей, полученных из сравнительно небольшого текста, содержащего вопросы и ответы, касающиеся ресторанов и продуктов питания. За «я» часто следует глагол «хочу», «есть» или «тратить».

источник: Jurafsky et al., 1994Google (снова) фактически предоставляет больший набор вероятностей для 1 грамма, 2 грамма, 3 грамма, 4 грамма и 5 граммов на нескольких языках. Они рассчитали их по источникам, напечатанным между 1500 и 2008 годами! Google Ngram Viewer позволяет вам загружать и использовать эту большую коллекцию n-грамм для проверки орфографии, автозаполнения, определения языка, генерации текста и распознавания речи.

Чем длиннее контекст, в котором мы обучаем N-граммовую модель, тем более согласованными могут быть предложения.На рисунке ниже показаны 3 предложения, сгенерированные случайным образом из 1-граммовых, 2-граммовых и 3-граммовых моделей, вычисленных из 40 миллионов слов Wall Street Journal.